Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

J’ai écrit mon article Back to the future en janvier 2020, deux mois avant que le Covid frappe l’occident. J’y cherchais les poches d’inévitabilité du futur, en matière technologique, les rares instances où présent et futur sont reliés par un pont quasi-indestructible:

La troisième méthode décrite par Venkatesh Rao est de découvrir les poches d’inévitabilité du futur, de construire un pont entre présent et futur, qui permette d’accéder au futur comme si c’était le présent, transformant alors le présent en passé. Bref , il s’agit de découvrir quand le futur est déjà écrit. Comme l’explique Venkatesh Rao, l’exercice est difficile, car il faut ressentir ce pont dans les tripes, ce n’est pas un exercice rationnel: le présent doit nous paraître obsolète!

Je donnais:

deux exemples de futur brumeux: l’AR/VR et les cryptomonnaies.

une impasse: Dropbox, utilisant un paradigme du passé: la valise.

deux types de futur inévitables: le moteur électrique, en particulier Tesla et l’automatisme en intelligence artificielle (un prolongement de la prédiction)

Beaucoup d’eau a coulé sous le pont depuis le Covid, puis la reprise et des ruptures d’approvisionnement inédites, l’inflation, le krach technologique et une récession planifiée par les banques centrales, sans effet immédiat sur l’emploi et l’inflation. De quoi détruire le pont aux fondations les plus solides …je souhaite revoir les prédictions aujourd’hui car un point d’inflexion majeur semble toucher celle sur l’IA et le brouillard pourrait se dégager sur la réalité virtuelle. Mais d’abord un rapide bilan:

Bilan sur les prédictions

1/ le futur semble toujours brumeux sur l’AR/VR, les applications toujours inexistantes. Même Meta a du mal à faire adopter Horizon Worlds par ses salariés. D’après The Verge, le 7 octobre 2022:

Le réseau social VR Horizon Worlds de Meta - l'application phare de la société, le "metaverse" - souffre de trop de problèmes de qualité et même l'équipe qui le construit ne l'utilise pas beaucoup, selon des mémos internes obtenus par The Verge.

Dans l'un des mémos adressés aux employés et datés du 15 septembre, le vice-président de Meta chargé du Metaverse, Vishal Shah, a déclaré que l'équipe resterait en "verrouillage de la qualité" pour le reste de l'année afin de "s'assurer que nous corrigions nos lacunes en matière de qualité et nos problèmes de performance avant d'ouvrir Horizon à davantage d'utilisateurs".

Horizon Worlds permet aux gens de construire et d'interagir dans des mondes virtuels en tant qu'avatars sans jambes, un peu comme si Roblox rencontrait Minecraft.

2/ les cryptomonnaies n’ont toujours pas de “killer app”, leurs bases de données sont peu performantes à une époque où on demande toujours plus de capacité de calcul. Enfin le protocole de sécurité du Bitcoin qui en fait sa renommée (proof of work) est de moins en moins populaire. La aussi le futur reste brumeux.

3/ Dropbox a plutôt bien résisté, défiant mes sombres prédictions. Leur nombre d’utilisateurs payant a progressé de 14,3 millions en décembre 2019 à 17,4 millions fin juin 2022 , soit plus de 20%. Ce n’est pas de la haute croissance mais cela reste solide.

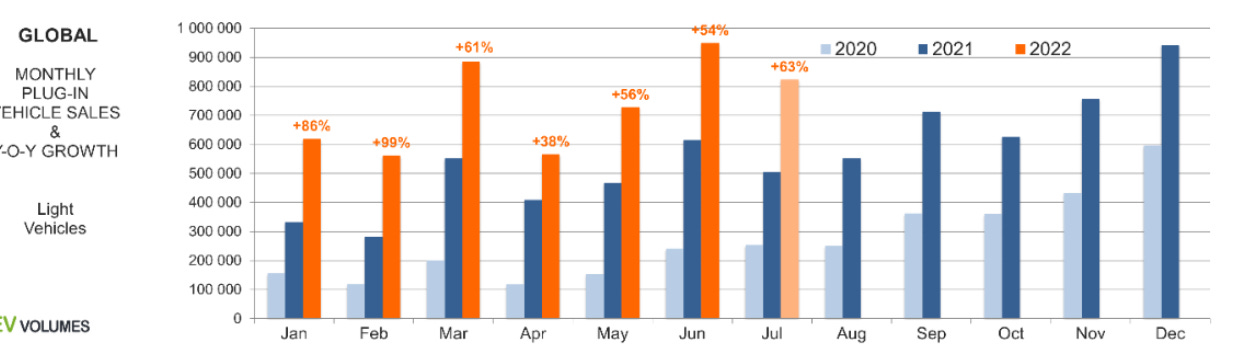

4/ Les voitures électriques ont confirmé un succès, qui ne se dément pas:

Et Tesla en particulier: 343 000 voitures livrées au 3eme trimestre 2022 contre 112 000 au 4eme trimestre 2019 (x3).

4/ Enfin l’IA semble bien être passée de l’ère de la prévision (machine à recommander) à l’ère de l’automatisme (machine à créer) avec l’ouverture au public cet été de Midjourney et Stable Diffusion suivi de Dall.E 2 en octobre.

Je veux revenir aujourd’hui sur deux avancées importantes: une sur l’IA car il semble que le pont entre IA prédictive et IA générative ait été franchi, ce qui ouvre la possibilité de nouveaux futurs très intéressants à explorer. Enfin la réalité virtuelle car, malgré les visions pessimistes de la presse, je me demande si un pont n’est pas en train de s’établir sur un avenir “certain”.

De l’IA prédictive …

Le principe de l’IA en simplifiant est de trouver des points communs entre les éléments qui concourent à un certain objectif. On définit la cible (regarder tel film) et on en déduit les points communs entre ceux qui regardent ce film. Cette déduction se fait en entraînant le modèle à grande échelle. Une fois les points communs établis, on peut prévoir qui regardera le film. On applique alors le modèle à des situations particulières. La prédiction est d’autant plus précise que le nombre de points communs est élevé; schématiquement, la précision est proportionnelle à la puissance de calcul et aux montant de données pertinentes sur lesquelles entraîner l’algorithme. Dans les premiers temps, les points communs étaient relativement peu nombreux, la prédiction imprécise. On compensait par des astuces. Par exemple chez Facebook, le contenu était trié par les amis, cela améliorait les chances qu’il soit apprécié. Les like et les retweets étaient des succédanés d’intelligence artificielle. Pour améliorer le dispositif de prédiction, on a simplifié l’objectif, augmenté et nettoyé les données pour les rendre plus pertinentes, enfin amélioré sensiblement les GPUs et autres puces d’intelligence artificielle, augmentant leur capacité à traiter des points communs (parallélisme). Le résultat est que les Mega Tech se transforment aujourd’hui en machines à recommander. Michael Mignano, anciennement chez Spotify note cette transformation profonde:

Des plates-formes comme TikTok et YouTube, qui connaissent un succès considérable (et qui continuent de se développer), accordent beaucoup moins d'importance aux amis et aux graphes sociaux qu'à des expériences algorithmiques magiques soigneusement sélectionnées, qui associent le contenu parfait aux bonnes personnes au moment exact. C'est ce qu'on appelle les médias de recommandation, et c'est la nouvelle norme pour la distribution de contenu sur Internet.

Avec une IA prédictive maintenant perfectionnée, les grandes plates-formes enferment leurs utilisateurs. L’internet ne permettant pas de “lock in” (la concurrence étant à un clic), elles essaient de créer une dépendance par le mécanisme de l’attention. Commercialement, c’est très efficace: donner aux gens ce qu’ils veulent jusqu’à plus soif. Mais:

1/ l’homme ne grandit pas d’une addiction. Ces systèmes vont rencontrer de plus en plus d’obstacles.

2/ la productivité risque d’en pâtir. La croissance économique vient souvent du radicalement nouveau, non du recyclage. Ni l’internet, ni l’iPhone n’ont émergé de groupes de discussion. Steve Jobs:

"Il est vraiment difficile de concevoir des produits par des groupes de discussion. Très souvent, les gens ne savent pas ce qu'ils veulent jusqu'à ce que vous le leur montriez."

L’IA prédictive fonctionne sur le principe de répétition. A a aimé x, B lui ressemble donc va aimer x aussi.

Le problème jusqu’à peu est que l’IA n’était bonne qu’à voir des corrélations immédiates, sans intégrer le contexte, sans mémoire. Le nombre de points qu’on pouvait traiter en parallèle était limité. Les applications de clavier par exemple ne pouvaient prédire qu’un mot ou groupe de mots. De même les applications de traduction individualisaient les mots ou au mieux les groupes de mots. Les capacités de l’IA la contraignait à des prédictions simples. Elle a trouvé naturellement son utilisation dans la prédiction à courte vue, immédiate (le clic ou l’arrêt sur image).

Cependant Google par l’intermédiaire de son laboratoire DeepMind travaillait à donner à la prédiction de la profondeur pour la rendre plus opérationnelle à effectuer des tâches. AlphaGo réussit à battre un professionnel du jeu de Go en 2015 sur un match à 5 parties (4/1). Puis en 2017, la version encore plus puissante d’AlphaGo réussit à vaincre le numéro 1 mondial sur un match à 3 parties (3/0). Les recherches de Google étaient cependant propriétaires. C’est en 2017 qu’une avancée majeure s’est produite…

…à l’IA générative

En 2017, un noyau de scientifiques, presque tous de Google, rédigent un papier appelé Attention is all you need, proposant une méthode performante pour améliorer la traduction, méthode généralisable à d’autres tâches. Ils y décrivent un moyen de paralléliser l’entraînement des modèles pour traiter plus vite beaucoup plus de données qu’auparavant et donner du contexte, de la mémoire à la prédiction. L’idée est de transformer du séquentiel (l’entrainement d’une tâche, sa mémoire) en parallèle pour gagner du temps sur le traitement et le rendre opérationnel. Le traitement séquentiel est très chronophage d’où l’idée de le réduire au minimum. Extrait de l’article:

Dans ce travail, nous proposons le Transformer, une architecture de modèle évitant la récurrence et s'appuyant entièrement sur un mécanisme d'attention pour établir des dépendances globales entre l'entrée et la sortie. Le Transformer permet une parallélisation beaucoup plus importante et peut atteindre un nouvel état de l'art en matière de qualité de traduction après avoir été entraîné pendant seulement douze heures sur huit GPU P100.

Le Transformer est une innovation algorithmique qui a déjà donné lieu à différents modèles comme BERT utilisé par le moteur de recherche de Google, GPT versions 1 à 3 qui produit du texte à partir d’instructions écrites, ou encore T5 qui transforme du texte en texte. Il permet de traiter beaucoup plus de paramètres qu’auparavant.

Le laboratoire OpenAI est devenue la figure de proue des modèles Transformer avec GPT (texte à texte puis texte à code, texte à partition avec GPT-3) puis Dall.E (texte à images). Il est une initiative d’Elon Musk, Sam Altman (Y-Combinator) et quelques autres investisseurs. Il est concurrent de DeepMind mais en plus ouvert, car il propose l’accès à ses modèles en beta a des développeurs. Dès lors, bien que les ingénieurs de Google ont été les concepteurs de la technologie Transformer, OpenAI en a récolté les fruits en la répandant et popularisant au travers de ses modèles GPT (Generative Pré-trained Transformer). Depuis Microsoft a investi dans le laboratoire et lui donne une ampleur institutionnelle (les moyens) et commerciale. GPT-3 sorti en 2020 à constitué un progrès majeur en terme de génération (textes élaborés, tweets, poèmes, musique, code). GPT-3 a été entraîné sur 175 milliards de paramètres contre 1,5 milliards pour GPT-2.

L’élément intéressant est que cette révolution de l’IA (du prédictif au productif) est un produit d’une innovation logicielle qui a été dévoilée sur la place publique. Cette innovation requiert une multitude de données qui pour certaines catégories sont aussi sur la place publique (textes et images, voire vidéos qui abondent sur internet). La concurrence est donc ouverte, non limitée par une supériorité en moyens matériels. Cela explique l’arrivée de petits acteurs récemment qui semblent dépasser DeepMind et OpenAI grâce à une stratégie plutôt astucieuse: commercialiser auprès du grand public, sans période transitoire, un modèle forcément populaire car spectaculaire: la transformation de texte en images. C’est astucieux car c’est s’appuyer sur la faiblesse des deux grands laboratoires qui hésitent à répandre l’utilisation de leurs modèles par crainte du « deep fake » et autre utilisations potentiellement répréhensibles. Ces petits acteurs utilisent le Transformer pour le texte couplé à une autre technologie logicielle pour la traduction en images: la diffusion.

MidJourney est un laboratoire indépendant créé par David Holz, le fondateur de Leap Motion. En juillet 2022, il propose une offre commerciale: un bot IA (texte à images) disponible sur un serveur Discord (paiement à l’image générée ou abonnement au delà d’un certain nombre d’images gratuites). Il devient vite populaire, s’appuyant intelligemment sur un réseau social. Midjourney emploie 10 personnes environ et s’autofinance entièrement. Son produit est propriétaire.

C’est la différence avec Stability AI, un autre petit laboratoire indépendant qui a franchi un pas de plus en codant son modèle Stable Diffusion en open source. Il élargit ainsi considérablement le champ de la concurrence pour les modèles texte à images pour le moment mais pour d’autres types de modèles ensuite. Stable Diffusion aurait été entraîné avec un coût de $600 000 sur AWS (source Wikipedia) ! C’est dire si le hardware n’est pas la contrainte pour les modèles génératifs aujourd’hui. Stability AI adopte le même modèle commercial freemium que Midjourney.

Les grands laboratoires sont pris de court par la vitesse de mise sur le marché de modèles bons marchés populaires et sont obligés d’accélérer le rythme de leur propre commercialisation (OpenAI ouvre Dall.E 2 au public, Google lance Imagen , Meta annonce Make-A-Vido, etc.). Cette mise en concurrence inédite, impulsée par l’open source comme au temps de Linux empêche un des grands laboratoires de centraliser la création.

Le futur de l’IA générative

Certes les grands laboratoires vont essayer de reprendre la main en donnant encore plus de contexte, de mémoire à leur IA, en termes matériels intégrer plus de paramètres pertinents. GPT-1 fonctionnait avec 117 millions de paramètres, GPT-2 avec 1,5 milliards, GPT-3 avec 176 milliards. GPT-4 est attendu avec 100 trillions de paramètres, de quoi composer non un simple post mais un livre tout entier ! Là encore il semble que le hardware (GPU) ne sera pas un élément de différenciation: Alibaba a récemment entraîné un modèle à 10 trillions de paramètres (50 fois GPT-3) avec 512 GPUs en 10 jours, pour un coût matériel de $300 000 environ. GPT-3 avait lui été entraîné un an auparavant pendant 34 jours avec un équivalent de 1024 GPU. La progression de la puissance des GPUs est exponentielle ! C’est d’avantage sur la pertinence des données source que les grands laboratoires vont agir, effectuant un travail fastidieux de nettoyage hors de portée de Midjourney et Stable Diffusion. Ce nettoyage peut rendre les modèles plus efficaces à paramètres constants et favoriser ainsi les grands laboratoires. Cependant cet avantage est tenu et la différenciation pourrait venir d’ailleurs, comme je vais l’étudier plus loin.

Un software déflationniste

Une IA qui produit (dans un premier temps du texte, des images, du code ou de la vidéo) peut remplacer des taches aujourd’hui réalisées par des cols blancs (écrivains, dessinateurs, juristes, programmeurs, etc.). Au lieu d’embaucher une équipe de codeurs par exemple, un responsable de programme utilisera Copilot, une IA qui crée du code à partir d’une instruction en texte. L’effet de cette innovation de l’IA générative est évidemment la déflation, cette fois à grande échelle. L’entrepreneur Daniel Gross de Y-Combinator met en perspective le software post GPT et celui des années d’avant:

Rétrospectivement, la période 1990-2020 pourrait être considérée comme une sorte d'ère interstitielle pour les logiciels, comme les premiers films sans son ou la télévision sans câble. Nous pensons que les logiciels sont impressionnants, mais peut-être qu'avec le recul, la numérisation de la réalité sera considérée comme un simple mécanisme de diffusion de l'IA. Le clavier n'est pas beaucoup plus puissant que le stylo... jusqu'à ce que l'IA entre en scène.

Prenons par exemple une journée dans la vie d'un avocat, qui n'a pas beaucoup changé depuis 1970. Il communique avec ses clients, rédige des documents, envoie des documents, discute au téléphone, signe des documents, etc. DocuSign est légèrement meilleur que le fax, mais pas de façon spectaculaire. Avec l'arrivée des LLM et de l'IA, les choses deviennent très différentes. Un seul avocat se voit insuffler la puissance de 100 assistants juridiques. Il devient un éditeur, pas un créateur, supervisant la sortie d'un modèle informatique au lieu de faire le travail. Une seule personne devient cinq à dix fois plus productive.

Il ne s'agit pas seulement du droit. Tous les producteurs de biens d'information - ingénieurs en logiciels, scientifiques de l'industrie pharmaceutique, comptables et chefs de projet - deviennent soudainement dix fois plus compétents.

Et il arrive souvent que de nouveaux types de cas d'utilisation - des choses difficiles à prévoir mais évidentes a posteriori, comme Uber ou YouTube - aient les conséquences économiques les plus importantes. Si tout le monde a un téléphone dans sa poche, nous aurons Uber. Qu'obtiendrons-nous si tout le monde a un travailleur universel à distance ?

80% de la population active travaillant dans les services, son remplacement partiel par l’IA pourrait constituer un choc déflationniste que n’ont pu déclencher les BigTech jusqu’à présent avec la première vague de logiciels. Ce serait un scénario inverse à ce que l’on nous prédit aujourd’hui, au milieu de pénuries de toutes sortes. Ce choc pourrait avoir un effet comparable à celui provoqué par l’ouverture du mur de Berlin et l’accès à la main d’œuvre bon marché des pays émergents. Mais au lieu de l’industrie (20% de l’économie), il concernera les services.

La transition

Ce futur nécessite une transition. En effet ces modèles directement issus de laboratoires ne sont efficaces qu’à 20%, 30% ou au mieux 40%. Les utiliser sortis d’usine, comme c’est le cas aujourd’hui pour Midjourney ou Stable Diffusion peut conduire à des erreurs flagrantes (par exemple absence de bras ou bras à l’envers sur une représentation humaine). Leur utilisation est exclue pour la fabrication de matériaux par exemple car elle conduirait à trop de gaspillage matériel. En revanche dans les 20%, 30% ou 40% où elle est efficace l’IA donne des résultats époustouflants sans intervention humaine. En fait, le dialogue avec la machine pour améliorer son travail (mécanisme de questions-réponses) n’est pas efficace car deux fois sur trois, la réponse est absurde, ce qui est relativement frustrant.

Aussi une nouvelle génération de logiciels va émerger visant à trier le travail utile de l’absurde et ne présenter à l’utilisateur rapidement que la ou les créations qui apportent une véritable valeur ajoutée. Une IA générative n’est pas une béquille au service de l’utilisateur (un chatbot ) mais un exécutant qui va faire le travail à sa place. Dans cette veine, GitHub et OpenAI ont créé en juin 2022 un programmeur IA à partir de GPT-3 appelé GitHub Copilot. D’après le blog de Copilot

Nous avons spécifiquement conçu GitHub Copilot comme une extension d'éditeur pour nous assurer que rien ne vienne entraver votre travail. GitHub Copilot distille les connaissances collectives des développeurs du monde entier dans une extension d'éditeur qui suggère du code en temps réel, pour vous aider à rester concentré sur ce qui compte le plus : créer de superbes logiciels.

Lorsque vous tapez du code ou des commentaires, GitHub Copilot vous suggère la ligne de code suivante. Mais il ne s'agit pas seulement d'un seul mot ou d'une seule ligne de code. GitHub Copilot peut suggérer des méthodes complètes, du code passe-partout, des tests unitaires entiers et même des algorithmes complexes.

Copilot est en aval de GPT-3 pour simplifier la vie du programmeur, lui indiquer quel travail de l’IA plutôt retenir et quel autre rejeter. C’est un produit opérationnel qui cherche à affiner GPT-3 pour faire gagner du temps au programmeur. D’après Nat Friedman le fondateur et directeur général de GitHub:

Aujourd'hui, je pense que l'une des statistiques d'une étude récente qui était vraiment intéressante était que Copilot pour les programmeurs, étant donné un certain test pour écrire un serveur web à partir de zéro, ce genre de chose, va accomplir la tâche plus de 50% plus vite s'ils utilisent Copilot que s'ils ne le font pas. Grâce à la télémétrie, nous savons que, pour certains langages, Copilot permet d'écrire jusqu'à 40 % du code que les gens ont dans le nouveau code qu'ils écrivent lorsqu'il est activé. C'est donc un succès incroyable, des millions de personnes l'ont utilisé et l'aiment, c'est un gros problème.

Le futur de l’intelligence artificielle, dans un premier temps, est dans l’interface utilisateur plus que dans les grands modèles dont la précision risque d’être lente à améliorer. Il y a là une mine d’or pour des start up innovantes car l’UI est généralement un point faible des BigTech. Slack et Zoom sont meilleurs que Teams, Figma qu’Adobe, Spotify qu’Apple Music, etc. Il faut une interface pour éviter les frustrations de l’utilisateur et au contraire mettre en valeur les super pouvoirs apportés par l’IA. Copilot est le précurseur d’une nouvelle génération de sociétés de logiciels qui cette fois-ci vont réellement améliorer la productivité de l’économie mondiale.

Mon prochain article sera consacré à un futur dont les contours semblent également se préciser: la réalité virtuelle.

Bonne semaine,

Hervé