Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Consomac, le 20 septembre 2024:

À l'occasion de la présentation de l'iPhone 16 la semaine dernière, Apple montré l'aperçu d'une future fonctionnalité appelée Visual Intelligence qui sera lancée à l'automne : elle permet de pointer l'appareil photo vers un sujet d'intérêt afin d'obtenir des informations sur celui-ci.

Apple a donné quelques exemples. En pointant vers un restaurant, on obtient sa fiche avec les horaires d'ouverture, les avis des clients ou encore les photos des plats. En pointant vers l'affiche d'un événement, on peut créer automatiquement un événement dans le calendrier qui sera pré-rempli à la bonne date, avec le bon titre sans oublier la géolocalisation. En pointant vers un chien, on est redirigé vers la page Wikipédia de la race en question. Il sera également possible de lier Visual Intelligence à des applications tierces. En pointant vers un vélo, on pourra ainsi identifier de modèle il s'agit et trouver la boutique qui le vend par le biais de Google. En pointant vers ses notes de cours, c'est ChatGPT qui pourra prendre le relais pour donner plus d'explications.

Cette fonctionnalité lancée sous la bannière d'Apple Intelligence n'est à ce stade pas disponible sur la version bêta d'iOS 18.1 : elle attendra peut-être iOS 18.2 en décembre mais sera en tout cas lancée « plus tard cette année ». Apple a été clair durant sa présentation : pour actionner Visual Intelligence, il faudra maintenir appuyée la nouvelle commande de l'appareil photo de l'iPhone 16, ce nouveau bouton tactile dédié à la caméra.

L’intelligence visuelle est passée largement inaperçue au milieu de toutes les nouveautés d’Apple Intelligence, en particulier en Europe où le service ne verra pas le jour avant le printemps 2025. L’iPhone 16 a été sous-estimé, considéré comme un 15 amélioré sans réelle innovation. De fait, le bouton caméra qui va permettre de déclencher Visual Intelligence est exclusif à la génération 16. Apple a ainsi créé un nouveau type de hardware (le bouton caméra), intégré à un software unique (Visual Intelligence) qui a pour objectif de redonner plusieurs années de vie à l’iPhone. Depuis deux ans environ, on cherche le hardware le plus adapté à l’IA générative, celui qui pourrait abattre l’iPhone: Rabbit R1, Pixel Pro, Meta Ray Ban, Humane AI Pin, hardware OpenAI en préparation. Et si ce bouton était le nouveau hardware d’IA générative tant attendu ? Les Meta, Google et OpenAI ne l’entendent sans doute pas de la même oreille ou attendent justement que ce produit ouvre la voie à une nouvelle génération de hardware… qui leur donnera cette fois leur chance.

Le précurseur Google Lens

Google Lens propose déjà de la recherche visuelle (par caméra ou image) …depuis 2017. D’après Sundar Pichai, CEO de Google, le 29 octobre 2024:

Lens est aujourd'hui utilisé pour plus de 20 milliards de recherches visuelles par mois. Lens est l'un des types de requêtes qui connaissent la croissance la plus rapide sur Search, en raison de sa capacité à répondre à des questions complexes et multimodales, et à aider à la découverte de produits et à l'achat.

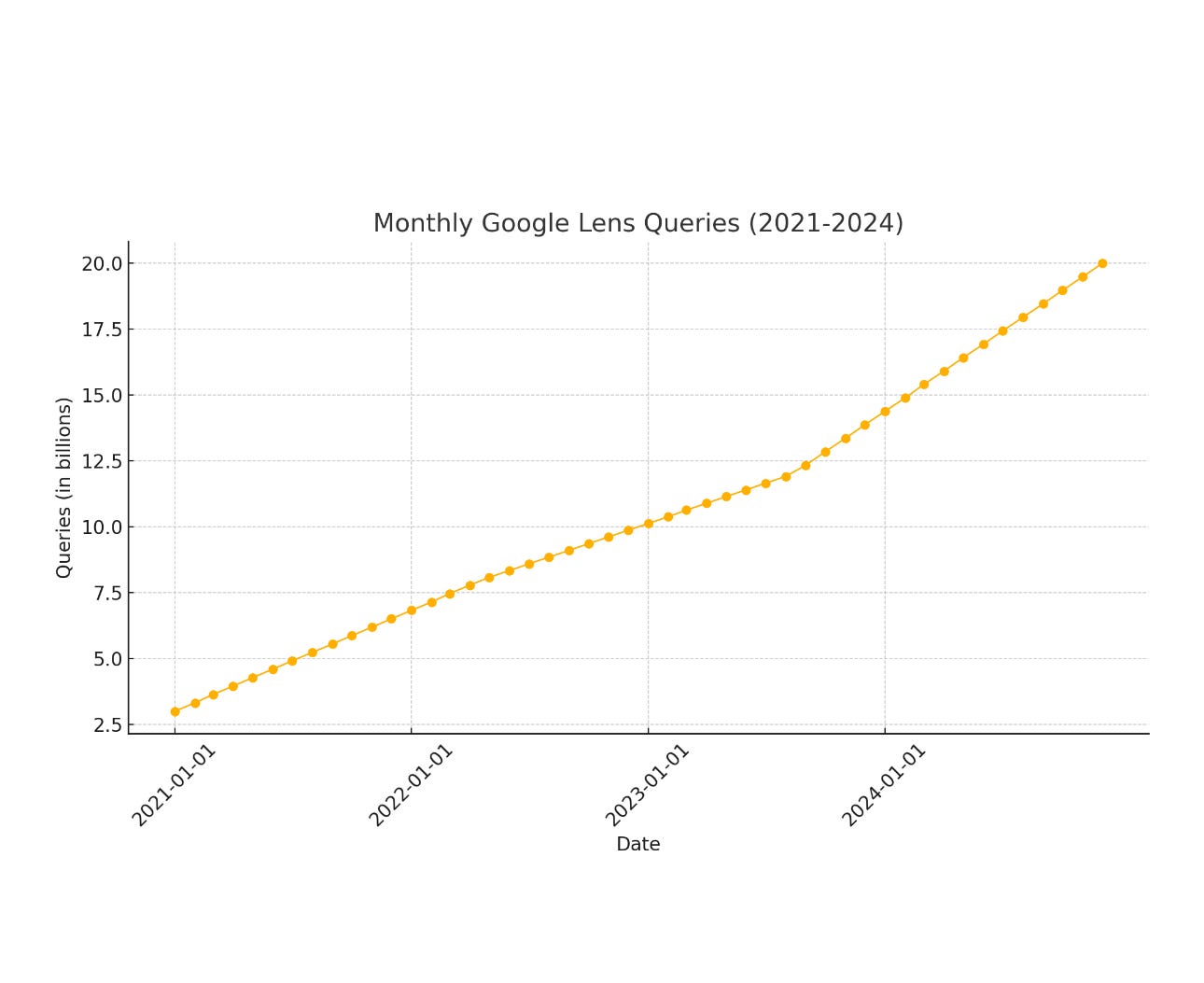

Le taux de progression de la recherche visuelle est spectaculaire:

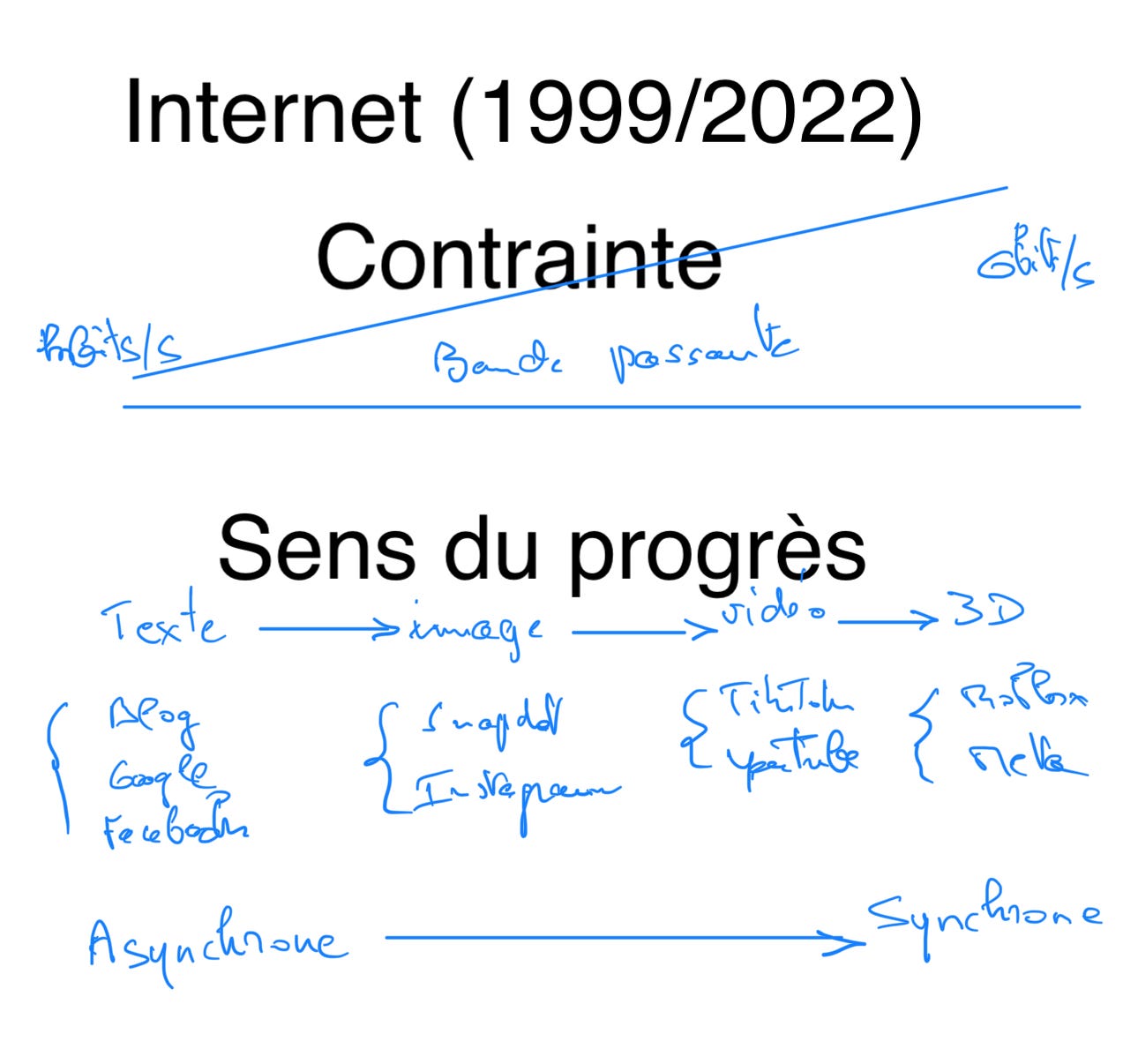

x 6 en 3 ans pour Google Lens (et s’accélérant) contre x1,6 environ pour Google Search. La recherche visuelle correspond à une tendance de fond du numérique qui est d’aller progressivement du texte à la photo, à la vidéo puis à la 3D, de l’asynchrone vers le synchrone. J’avais abordé cette question dans mon article Text is back, expliquant que jusqu’en 2022, la contrainte de la bande passante se relâchant, l’Internet allait vers plus de synchronie :

L’arrivée de ChatGPT a cassé la tendance et redonné de l’attrait au texte (le contenu primant alors sur la latence). Les chatbots se sont multipliés depuis 2023, ChatGPT gardant la première place sans conteste, grignotant aussi sur la recherche traditionnelle:

La progression de ChatGPT est phénoménale, validant ainsi apparemment l’idée du retour du texte. Cependant, contrairement à ce que j’imaginais dans cet article, la tendance vers plus de synchronie s’est juste brièvement interrompue. L’accélération de la croissance de ChatGPT a correspondu à l’annonce puis à la mise à disposition de ChatGPT Voice, l’IA conversationnelle en simultané d’OpenAI. Gemini et Copilot ont emboîté le pas avec leur IA conversationnelle. La voix et l’image sont les deux vecteurs de la représentation du monde en temps réel, qu’on peut nommer également réalité augmentée. C’est une direction majeure pour la technologie. Le succès de Google Lens, même si ce dernier est enfoui dans la foison d’applications Alphabet, n’est pas sans rappeler celui de ChatGPT: 2/3 ans pour atteindre 3 milliards de requêtes (Google Lens a été lancé très progressivement d’abord sur les Pixel, puis sur les Android, enfin sur les iPhones en décembre 2018). Google Lens est maintenant un atout stratégique pour Google, qu’il déploie par exemple sur Chrome pour contrer Safari.

D’après HotHardware, le 13 novembre 2024:

Alors qu'Apple poursuit sa campagne de protection de la vie privée avec Safari, les utilisateurs d'iPhone et d'iPad qui utilisent Google Chrome sont sur le point de voir plusieurs nouvelles fonctionnalités ajoutées à leur navigateur de prédilection. Chrome bénéficiera d'une mise à jour de Google Lens, d'une intégration avec Drive et Photos, d'une amélioration de Shopping Insights et d'un moyen plus fluide de trouver son chemin avec Maps.

Avec cette mise à jour, Google Lens est sur le point de devenir beaucoup plus puissant, car les utilisateurs pourront télécharger une photo tout en ajoutant du texte à une requête de recherche visuelle. Cette mise à jour devrait permettre aux utilisateurs "d'effectuer des recherches plus complexes et plus spécifiques, avec des résultats plus utiles et plus pertinents". Ces résultats pourraient parfois inclure "un aperçu de l'IA qui rassemble les informations les plus pertinentes à travers le web".

La recherche visuelle permet d’interpréter ce qu’on voit en temps réel, de lui donner un sens en pointant l’appareil photo. Le préalable est d’avoir accès à l’information en temps réel également. C’est une condition nécessaire pour faire de la recherche visuelle. Cela nécessite d’avoir un outil pour indexer tout ce qui se produit avant de le restituer par le texte, la voix ou l’image. Bref, il faut développer un moteur de recherche qui donne une réponse à une question posée (orale ou écrite) plutôt que de conduire à différents sites internet en fonction de mots clés. En effet, dans une situation pratique, en mobilité, la réponse doit être rapide et facile à enregistrer. Il ne s’agit pas d’ouvrir des perspectives comme le fait la recherche Google.

Les nouveaux moteurs de recherche

Google a quasiment un monopole sur l’indexation de sites (Bing est loin derrière) mais en revanche peut être égalé voire battu sur la restitution. C’est sur cette faiblesse relative que comptent de nouveaux acteurs pour faire valoir leur nouveaux moteurs de recherche avec un objectif à terme qui est la recherche visuelle:

Perplexity cherche à lever $500 millions sur une valorisation de $9 milliards (x3 par rapport à juin 2024). La restitution de Perplexity est de premier plan mais son problème est le manque de données qui le contraint à aller les chercher chez Google et dans des sources non autorisées. La levée de fonds lui permettra probablement de passer des accords avec les grands médias.

OpenAI vient lui de lever $6,6 milliards (valorisation de $157 milliards) et a lancé dans la foulée son moteur de recherche début novembre. Ses sources, utilisées pour la restitution, proviennent de Bing (actionnaire Microsoft). D’après le Guardian:

OpenAI, qui devrait enregistrer une perte de 5 milliards de dollars cette année, a déclaré que cette levée de fonds lui permettrait de "doubler" la recherche de pointe en matière d'IA et d'augmenter sa "capacité de calcul", l'un des principaux facteurs de coût dans la construction et l'exploitation de modèles d'IA puissants.

Meta qui n’a pas d’engin d’indexation ne veut dépendre ni de Google ni de Microsoft et va créer son propre moteur de bout en bout. En effet aujourd’hui Meta AI utilise Google Search et Bing pour donner les réponses aux requêtes de ses utilisateurs. D’après The Verge, Meta travaille depuis 8 mois à créer sa propre base de données d’information pour alimenter ses chatbots. Plus intéressant encore l’article souligne:

Meta a travaillé à l'élaboration de données de localisation qui pourraient concurrencer Google Maps et, le mois dernier, Bloomberg a rapporté que le travail d'Apple sur les outils de recherche dans l'App Store montrait qu'il « a ce qu'il faut » pour remplacer Google Search, qui est alimenté par l'intelligence artificielle.

Car en fait l’objectif de ces moteurs de recherche IA (hormis peut-être Perplexity) n’est pas de concurrencer Google sur la recherche traditionnelle. Ils ont en effet peu de chance car l’avantage de ce dernier est d’être le meilleur guide pour naviguer sur internet, eux se contentant de donner des réponses (avec sources éventuellement). Google fournit une connexion au monde extérieur alors que le moteur IA isole plutôt, même si la réponse immédiate peut paraître plus efficace à court terme. Cet atout indéniable de Google, dont il a le quasi monopole devrait lui permettre de garder le leadership sur la recherche textuelle, et de copier les moteurs IA pour la réponse directe, leur coupant l’herbe sous le pied.

Google cependant perd cet avantage sur la recherche visuelle qui requiert une réponse rapide et précise et non pas une multitude d’options. Google Lens, malgré son succès impressionnant est perfectible car il ne mène pas assez vite à une réponse précise, il est partout certes mais nulle part car enfoui au milieu d’autres options Google. La façon de faire de Google trop brouillonne peut être un handicap pour la recherche visuelle; un moteur natif IA sera calibré pour la rapidité et à la précision. Il pourra donc avoir des chances de succès pourvu qu’il maîtrise:

-le hardware (l’appareil)

-les données

-l’interface utilisateur

L’appareil

Il est censé fournir l’accès le plus rapide possible à l’information visuelle. Une intelligence visuelle nécessitant trois ou quatre étapes avant de fonctionner est disqualifiée. S’il faut prendre le smartphone dans sa poche, l’allumer, entrer le code, trouver l’application ad hoc (type Google Lens), le pointer sur quelque chose et enfin l’interroger, les chances de succès sont limitées, l’intelligence visuelle restera une application parmi tant d’autres.

L’exemple à ne pas suivre est Humane Ai Pin qui a conçu un appareil sans caméra, capable d’intelligence auditive seulement. Voici donc un produit cher ($499), fonctionnant avec un abonnement de $24 par mois et offrant une fonctionnalité limitée (réponse par la voix type ChatGPT de type non interactif). Un peu mieux est Rabbit R1, un petit carré en plastique à $199 disposant d’un écran et d’une caméra. Un simple double-clic permet d’actionner la caméra et d’interroger l’IA sur ce que l’on voit. Le fondateur de Rabbit Tech a bien vu le sens de l’histoire mais son appareil manque de puissance (puce MediaTek à 2,3 GHZ de fréquence et 4GB de mémoire) et ne peut rivaliser avec un smartphone: le temps de réponse est trop long (il faut accéder à un cloud quelle que soit la requête) et ne compense pas l’avantage de la simplicité du R1. Le pari le plus osé a été fait par Meta avec ses lunettes Meta Ray Ban. Équipées de caméra et d’un système audio discrets, elles permettent d’interroger ce qu’on voit très facilement et d’avoir une réponse dans le creux de l’oreille. Ces lunettes rencontrent un grand succès. D’après ChatGPT Search:

En octobre 2024, les lunettes intelligentes Ray-Ban de Meta ont connu un succès notable, avec plus de 700 000 unités expédiées depuis leur lancement en octobre 2023. Dans la région Europe, Moyen-Orient et Afrique (EMEA), ces lunettes sont devenues le produit le plus vendu dans 60 % des magasins Ray-Ban. Face à cette forte demande, Meta a décidé d’élargir sa gamme de produits et d’augmenter ses investissements pour répondre à la popularité croissante de ces lunettes.

Les Meta Ray Ban sont un succès car en plus de l’intelligence visuelle encore limitée, elles permettent de prendre des photos et d’écouter de la musique. L’intelligence visuelle est ce qui les fait vendre, l’audio et la vidéo font qu’elles sont utilisées quotidiennement, grâce à une puce Qualcomm performante. Le problème de cette intelligence visuelle, hormis ses faibles capacités et temps de réponse élevé, est l’obligation de la solliciter à la voix: « Hey Meta, look and tell me what you see ». En dehors des sociopathes, il est difficile d’imaginer à qui va s’adresser cette intelligence visuelle. Meta a encore du pain sur la planche.

Le smartphone, utilisé par 5 milliards de personnes reste l’outil le plus adapté pour proposer une intelligence visuelle, au moins pour quelques années: il a un appareil photo, un écran et une puce de plus en plus puissante permettant de répondre rapidement à toute sollicitation orale ou écrite, capable même d’anticiper les désirs de l’utilisateur. L’intelligence visuelle va donner une nouvelle vie au smartphone. Apple l’a anticipé avec l’iPhone 16 qui donne un accès direct à Apple Visual intelligence. Il va probablement être suivi assez vite par les principaux fabricants de smartphone qui proposeront une intelligence visuelle modulaire (conçue par ChatGPT , Meta ou Google) accessible par bouton caméra ou à l’ouverture de l’appareil.

Il est probable qu’OpenAI s’essaie au hardware pour éviter une dépendance à l’écosystème Apple ou Google (il y a un projet avec Jony Ives, ancien designer d’Apple). Mais comment rivaliser avec un produit dont l’utilisation est complètement entrée dans les mœurs ?

Les données

L’intelligence visuelle comprend l’environnement physique et l’interprète. Un premier niveau conceptuel consiste à reconnaître le type d’environnement (tel arbre, telle vue, tel monument) mais sans le relier au contexte local. C’est aujourd’hui le niveau d’intelligence des Meta Ray Ban par exemple. La Tour Eiffel sera reconnue comme une impressionnante construction en fer. Ce type d’intelligence n’a en fait que peu d’intérêt. Pour être performante, l’intelligence visuelle ne doit pas chercher le générique mais le spécifique. Cela implique nécessairement de dresser une carte 3D de l’environnement. Ce qui laisse aujourd’hui deux concurrents sérieux: Google avec Map et Apple avec Plans, même si Meta travaille pour construire une carte. Cela signifie que ces deux groupes constituent des points de passage obligés pour tout prétendant à l’intelligence visuelle (OpenAI, Meta, Anthropic, etc). Condition nécessaire mais pas suffisante: l’IA va devoir se souvenir du comportement de l’utilisateur et l’enregistrer en mémoire, de manière à pouvoir anticiper son comportement pour lui servir ce qu’il veut sans qu’il ait à demander. Cela explique pourquoi les larges modèles de langage travaillent aujourd’hui sur la mémoire. Le RAG permet d’accéder à la mémoire mais il n’est pas rapide et ne fait pas de hiérarchie. Pour l’intelligence visuelle qui nécessite de réduire au minimum le temps de réponse, il faut une mémoire. Gemini Advanced a introduit la fonction le 19 novembre 2024. Quelques jours auparavant, Mustafa Suleyman, responsable IA chez Microsoft annonçait:

Les prototypes sur lesquels nous travaillons ont une mémoire quasi infinie. Ils n'oublient donc pas, ce qui constitue une véritable transformation.

Au delà de l’algorithme il faut des données sur le comportement de l’utilisateur. Qui est mieux placé que Google et Apple qui dominent le marché du smartphone ? Google a un avantage supplémentaire qui est l’intégration avec sa base de données gigantesque. OpenAI s’il ne veut pas devenir trop dépendant d’Apple n’a pas d’autre choix que lancer son propre appareil avec le risque que ce dernier reste marginal. Enfin Meta va directement se focaliser sur la prochaine plate-forme de réalité augmentée, celle qui triomphera à terme du smartphone, même augmenté par l’IA.

L’interface utilisateur

L’interface actuelle des smartphones date de la fin des années 2000 (applications disposées les unes à côté des autres). Elle est quelque peu archaïque aujourd’hui. On s’y est tellement habitué qu’on la pense immuable et qu’on ne fait pas le lien avec l’IA. Par contre quand on plonge dans les applications, l’IA est omniprésente: dans le fil d’actualité de Facebook ou Instagram, dans la présentation des vidéos de Netflix, dans les flux TikTok , dans la page d’achat Amazon, etc. Ces applications sont spécialisées, de même leur IA. Il est temps d’imaginer une IA plus généraliste, qui anticiperait notre comportement en amont. L’IA généraliste serait dans l’OS (voire serait l’OS) et les apps programmeraient leur propres agent dans cet OS. De cette manière, l’IA permettrait d’accéder à ce que l’on souhaite de manière plus directe et intuitive que le chemin rébarbatif emprunté aujourd’hui: balayer l’écran pour trouver la bonne app, l’ouvrir et naviguer dans l’application selon l’interface imaginée par des développeurs. L’ouverture de l’OS dans la caméra, à la façon de Snapchat, permettrait un accès immédiat à la recherche visuelle (fonction la plus prisée) et à de petits carrés représentant les agents les plus utilisés en fonction de l’heure et du lieu. L’écran serait une lucarne de réalité mixte que l’on pourrait commander sans toucher l’écran, constituant ainsi une préfiguration des lunettes de réalité mixte, telles que celles présentées par Meta dernièrement.

En principe, Apple et Google, exerçant un duopole sur l’OS mobile (iOS et Android), sont les mieux armés pour accompagner la transition vers l’intelligence visuelle. Cependant leur position de force actuelle peut être un inconvénient quand il s’agit de repenser l’OS de bout en bout pour en faire avant tout un agent IA. Les deux groupes ont tissé des relations avec les développeurs d’applications qu’il faudrait revoir. OpenAI, en revanche, commençant avec une page blanche, pourrait concevoir un OS plus novateur et un système de facturation adapté à l’IA, attirant ainsi les développeurs. Les fabricants de smartphones chinois, privés d’Android pourraient aussi être facteurs de changement.

En résumé :

Le smartphone en prend encore pour 5/10 ans de domination, une nouvelle vie lui étant fournie par l’intelligence visuelle.

Les lunettes de réalité augmentée sont l’étape ultime de l’intelligence visuelle. Pour faire une comparaison avec la voiture électrique, les smartphones sont l’équivalent des véhicules hybrides, les lunettes des véhicules tout électrique - les premiers sont une étape vers les seconds- Meta prépare l’étape ultime, faisant une croix sur l’intermédiaire.

Apple a compris l’importance stratégique de l’intelligence visuelle et met ses forces dans la batailles. Il lui manque la profondeur encyclopédique d’OpenAI et plus encore de Google. Il lui faudra passer des accords, potentiellement avec ses ennemis pour éviter le syndrome « Dis Siri »

Google est le mieux armé, en théorie, car il a toutes les pièces du puzzle: l’OS dominant (Android), l’application à succès (Lens), les données géographiques (Map), la profondeur encyclopédique et les algorithmes. Son problème est d’être enchaîné à un modèle économique qui n’est pas forcément le meilleur pour l’intelligence visuelle. Proposer des alternatives (ce que fait Google à merveille) est plus adapté à la recherche traditionnelle (position assise) qu’à la recherche visuelle (en mouvement). Le modèle économique doit changer, ce qui n’est pas gagné…

OpenAI est un sérieux prétendant avec la marque ChatGPT. N’étant pas prisonnier d’un OS mobile, il peut essayer de concevoir en liaison avec un fabricant de smartphones un OS programmé dans l’IA qui constituerait une rupture par rapport à iOS et Android. Il peut s’appuyer sur une forte marque mais il aura le handicap de ne pas avoir assez de données géographiques et devra passer une alliance avec un ennemi…

Le joker serait un fabricant chinois type Huawei. Son nouveau téléphone, le Mate 70 affranchi d’Android, est actionnable par geste, à distance…

Bonne semaine,

Hervé