Hallucinations !

Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Attention: cet article peut comporter des hallucinations !

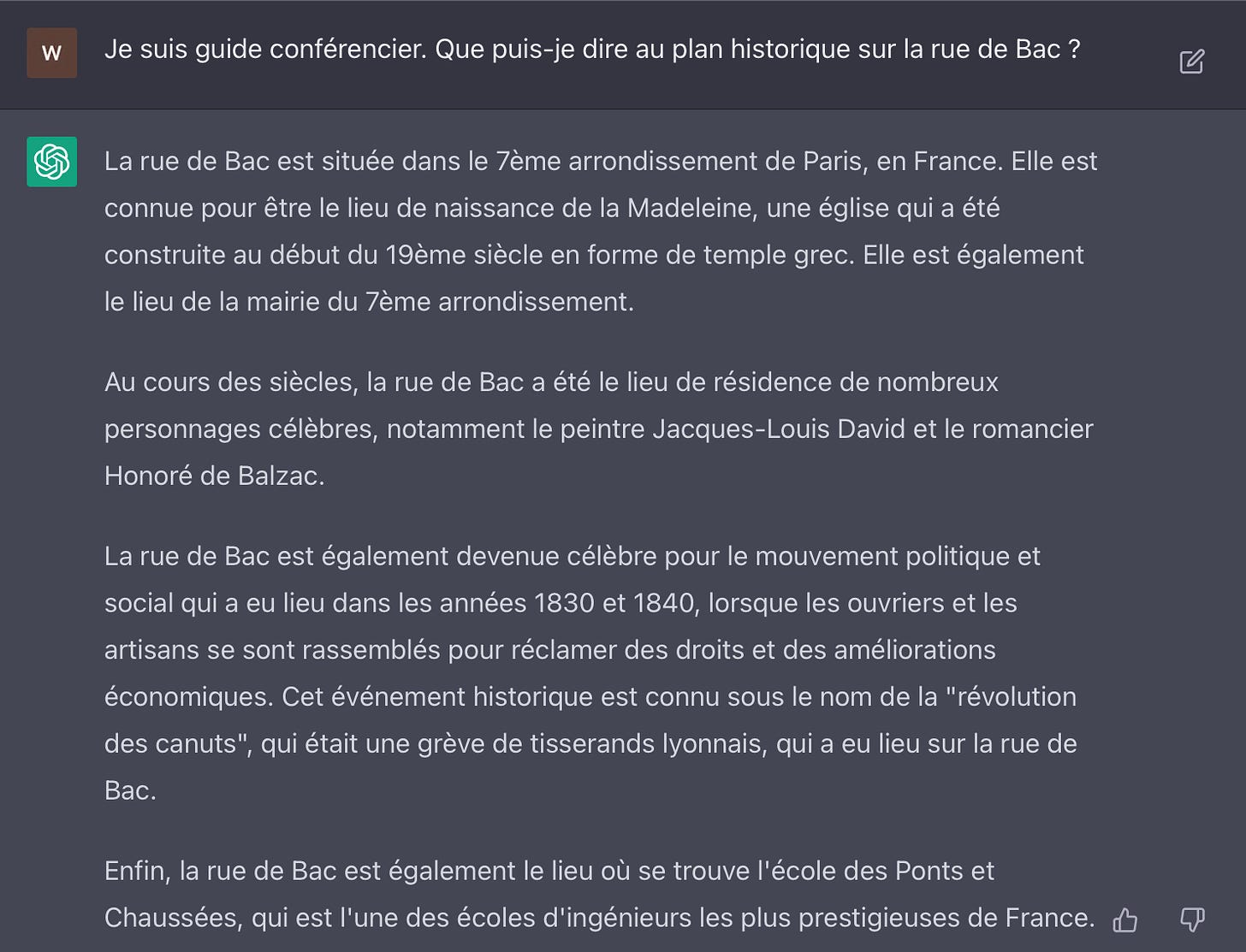

Si vous cherchez une information, ne la demandez surtout pas candidement à ChatGPT. Il est capable de vous induire en erreur avec un ton d’autorité qui vous confondra. Et l’erreur peut être XXL vous couvrant de ridicule si vous prenez sa réponse pour argent comptant…par exemple:

Voici donc un festival d’hallucinations ! Les hallucinations sont la partie la plus fascinante de l’IA générative car elles vont façonner la façon dont cette technologie va être déployée. Pour reprendre la terminologie de Frédéric Bastiat dans son célèbre livre:

Ce qu’on voit: des réponses aux prompts impressionnantes,

ce qu’on ne voit pas: un taux de déchet non négligeable qui contraint le modèle économique.

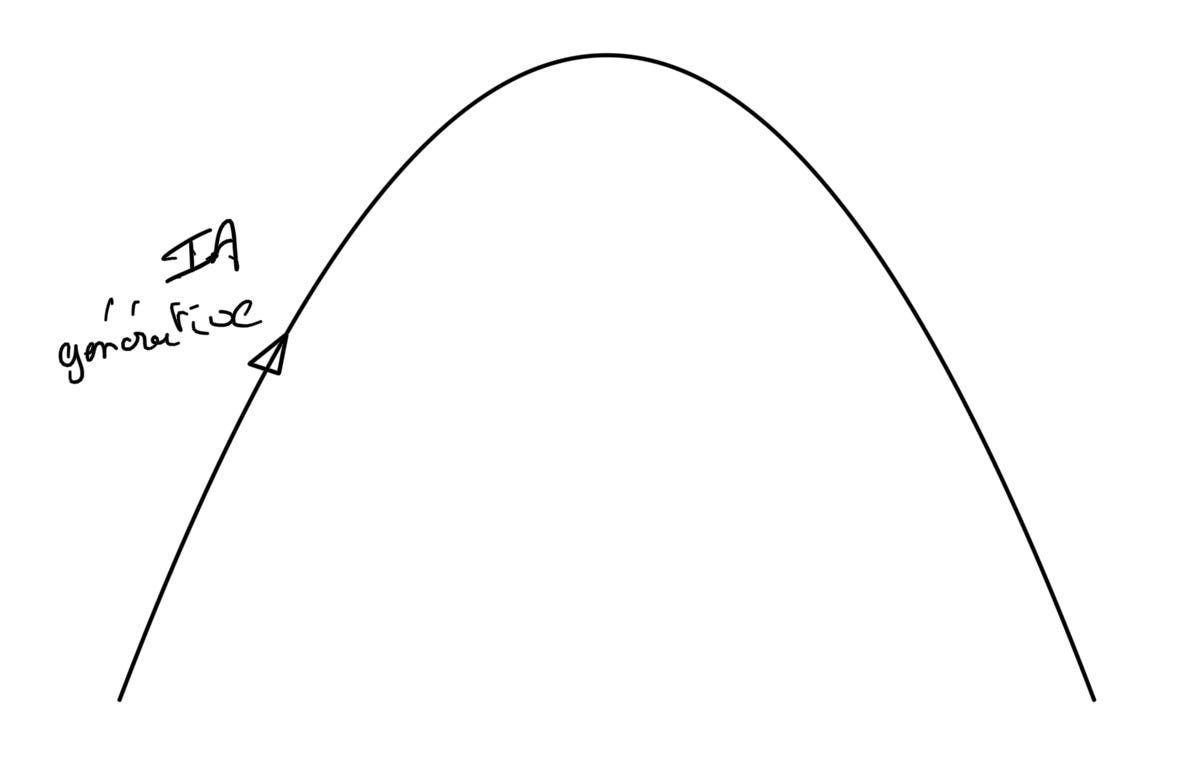

L’effet de mode

On a aujourd’hui tendance à insister sur les prouesses de l’IA générative sans en voir les limites bloquantes:

-le taux de réponses loufoques (taux d’hallucinations),

-l’unicité de la réponse qui peut être soit vraie (pile), soit fausse (face). Qui clique sur le « j’ai de la chance » de Google ?

-le ton autoritaire et l’exhaustivité des réponses hallucinatoires, qui impressionne à tord. Selon la classification de Marshall McLuhan, ChatGPT est un media chaud, fournissant beaucoup d’information à son audience et favorisant la passivité.

-le coût en GPU, déjà important pour un simple prompt, encore plus élevé quand on intègre le taux d’hallucinations,

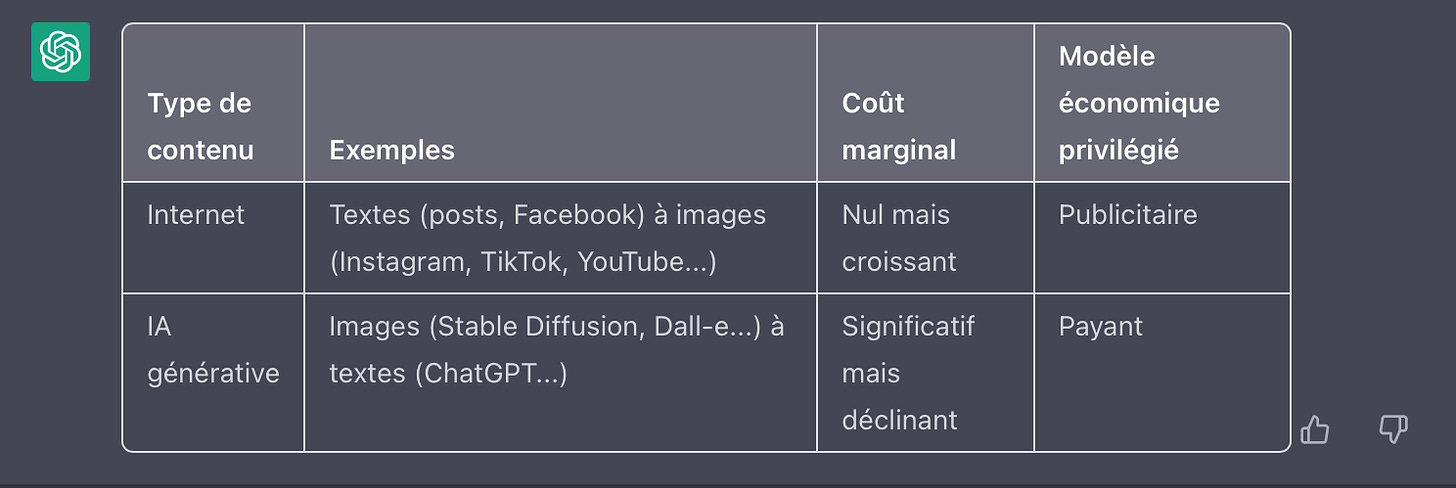

-le modèle économique qui doit être payant, du fait d’un coût marginal de génération significatif et proportionnel au taux d’hallucinations.

-le coût environnemental qui ne va pas tarder à être mis en exergue, à l’instar de celui du Bitcoin pour discréditer la technologie.

Cela ne peut conduire qu’à une déception pour le commun des mortels qui perçoit l’IA générative comme une machine à tout faire prodigieuse. La gratuité (provisoire) de ChatGPT entraîne une certaine excitation sur le produit, assimilé à un nouveau mentor du quotidien. Comme l’aurait dit un ancien président: c’est gratuit, c’est Microsoft qui paie... Cet article de presse du Figaro, comme de nombreux autres font monter cette excitation…édulcorant le caractère hallucinatoire et le coût de ChatGPT.

Qu’on ne pense pas surtout que GPT-4 va résoudre les problèmes. Comme GPT-3, il se nourrit de l’internet qui dit beaucoup de bêtises. De plus, l’internet dans une logique circulaire va être inondé de certitudes Chat-GPT qui seront reprises par les nouvelles versions. Le plus probable est que GPT-4 hallucinera encore mais avec plus de rapidité et de précision dans l’erreur…

La confiance dans un tel dispositif, pour celui qui ne sait pas le piloter, ne peut pas s’installer: trop coûteux pour trop de mensonges. Twitter hallucine aussi mais il est gratuit ! Comment créer une marque durable ainsi comme l’ont fait précédemment les sociétés disruptives, de Microsoft à Amazon, Google, etc. ? Ces dernières avaient la confiance de leurs utilisateurs car elles délivraient plus que ce qu’elles promettaient. Le résultat à court terme sera ici probablement une déception et peut-être un désintérêt: ChatGPT est un modèle de langage, une IA restreinte, emballée dans un beau paquet qui simule une IA générale…Sa spécialité première est le baratin…pour le reste, il faut découvrir ses secrets en travaillant les prompts. Le risque:

Plus qu’un produit, ChatGPT reste une infrastructure. Ce sont les produits, construits sur le modèle, qui manquent désormais.

Des infrastructures, pas des produits

Le malentendu provient du fait que GPT-3, Stable Diffusion ou même ChatGPT sont avant tout des infrastructures, c’est à dire des moyens à partir desquels construire et faire fonctionner des produits. ChatGPT donne l’illusion d’être un produit car il a été conçu pour répondre à tout. Or son taux d’hallucinations le rend inutilisable sans transformation, soit par l’homme, soit par la machine. Pour prendre une image, utiliser ChaGPT brut de pomme, c’est comme si on mettait du Brent dans le réservoir de sa voiture. Pour la faire rouler, comme on ne peut raffiner le pétrole soi même, il faut acheter le produit raffiné. Heureusement il est plus facile de raffiner ChatGPT que du pétrole. Mais l’image reste valable: les hallucinations doivent être détectées, puis soit réduites, soit acceptées si elles sont inséparables des réponses percutantes. Le rendu des prompts doit être géré et son coût minimisé à qualité constante, que ce soit directement, indirectement (par des produits finis) ou les deux à la fois car il est peu probable que les produits finis éliminent complètement les hallucinations. Par exemple Github Copilot , une IA générative de code construite à partir de GPT-3 peut donner des réponses très intéressantes mais de temps en temps débloque complètement. Le développeur doit savoir trier et donc disposer d’une bonne expérience. Nat Friedman, ancien CEO de Github:

Ce que je dirais toujours de ces modèles, c'est qu'ils alternent entre l'effrayant et le loufoque. Donc, la moitié du temps ou une fraction du temps, ils sont si bons que c'est effrayant, du genre : "Comment a-t-il pu comprendre ça ? C'est incroyable. Il lit dans mes pensées", ou "Il connaît ce code mieux que moi". Et puis parfois, c'est bizarre, c'est tellement faux, c'est absurde, c'est ridicule. Donc quand c'était faux, c'était vraiment faux.

Un bon produit n’est pas forcément celui qui réduit les hallucinations (car cela pourrait aussi rendre les réponses moins percutantes) mais celui qui aide l’utilisateur a les repérer. C’est l’objectif de Copilot qui fournit des outils pour surveiller le code (Github Actions, Dependabot, etc.).

D’autres produits viseront plutôt la réduction du taux d’erreur. Compte tenu de l’input humain colossal pour le faire, il faudra 1/ spécialiser le modèle sur des données fiables 2/ éviter de le surcharger en données. Cela milite alors pour des petits modèles mono-fonction qui n’élimineront pas complètement les hallucinations et seront onéreux du fait d’un manque d’échelle prévisible. Leur intérêt proviendra de la possibilité d’être utilisés par des professionnels pour économiser des coûts de personnel.

Une IA pour professionnels

Dans tous les cas de figure, je vois plutôt l’IA générative comme un outil pour les professionnels du fait de la complexité et du coût de gestion des hallucinations (et des réponses non satisfaisantes de toute façon). Pour les professionnels, le deal est très intéressant: ils connaissent le métier, ils ont des équipes auxquelles ils déléguent la réalisation des projets qu’ils ont conçu. Ils savent juger la qualité de leur travail, voir où elles se trompent et rectifier le tir. Le problème est que ces équipes coûtent cher. L’IA générative peut alors être une solution: au lieu de gérer les hallucinations de l’équipe, le professionnel gère celles de l’IA. C’est moins cher et il n’y a pas d’ego en jeu. Les start-up notamment pourraient être tentés par ce dispositif, permettant des économies de coût importantes et un service moins cher. Raphaël Richard, qui a étudié ChatGPT sous tous ses angles, montre dans un excellent post l’intérêt de GPT pour les rédacteurs professionnels:

On lit ici et là que les professionnels du contenu sont menacés à cause de GPT3 parce que l’on a l’impression que n’importe qui peut générer n’importe quel texte avec GPT3.

Dans la réalité, l’utilisateur professionnel de GPT est confronté à de nombreux défis:

- A chaque fois que l’on souhaite générer un nouveau type de contenu, il faut mettre au point, par itérations successives, de nouveaux modèles de prompts

- Il faut améliorer, à la main, la qualité de certains textes

- Il faut, parfois, ajouter des informations essentielles à côté desquelles GPT est passé pour publier un article complet

- Il faut ajouter des pépites pour rendre certains textes plus intéressants et plus cohérents avec les textes que vous avez l’habitude de produire sur votre site

- Il faut souvent rédiger une intro/un chapeau un peu punchys et contextuels afin capter l’attention du lecteur

- Il faut gérer la mauvaise qualité de certains textes de GPT qui ne sont pas toujours qualitatifs,

- Pour d'autres, il faut fournir un plan d’article à GPT pour qu’il traite bien le sujet, lui donner un angle, une liste de points à traiter…

- Demain, il faudra modifier les textes de GPT pour faire sauter le marqueur invisible « généré par GPT » qu’OpenAI intégrera pour Google,

- Mais surtout, pour les contenus les plus complexes, il faut avoir l’expérience de la rédaction.

Bref, ChatGPT se gère et cela nécessite une expérience du métier. On insiste beaucoup ça et là sur le fait que l’IA générative va séparer le créatif de l’exécutant et rendre ce dernier inutile. C’est peut-être vrai de l’exécutant qui n’est pas créatif. Je suis plus dubitatif pour l’exécutant créatif. L’IA générative va à mon sens pousser l’intégration de la création et de l’exécution, car un créatif qui ne maitrise pas l’exécution risque de tomber dans le piège de l’hallucination. Les exécutants vont devoir rehausser leur niveau, les exécutifs parachutés risquent la disruption…

Psychologie de l’hallucination

L’ erreur humaine est tolérée:

Errare humanum est, pereverare diabolicum…

Celle de l’IA choque, voire terrifie. L’hallucination informatique est intolérable. Il suffit de considérer la voiture sans chauffeur: promise depuis des années, elle est sans cesse retardée. Certains pensent qu’elle ne verra jamais le jour et qu’il faudra toujours une personne pour superviser la conduite. Chaque accident de Tesla est mis en exergue pour déconsidérer la technologie. Les promoteurs de systèmes d’autonomie comme Mobileye, Waymo ou Baidu ne valent pas grand chose, car la voiture réellement autonome est reléguée au rang des innovations loufoques comme la fusion nucléaire, l’informatique quantique ou les supra-conducteurs…Il y a plus d’un million de morts sur les routes chaque année dans le monde. Pour que la voiture sans chauffeur soit acceptée, il faudra qu’elle tende vers le zéro décès. Personne n’y croit mais il y a un jackpot à la clé !

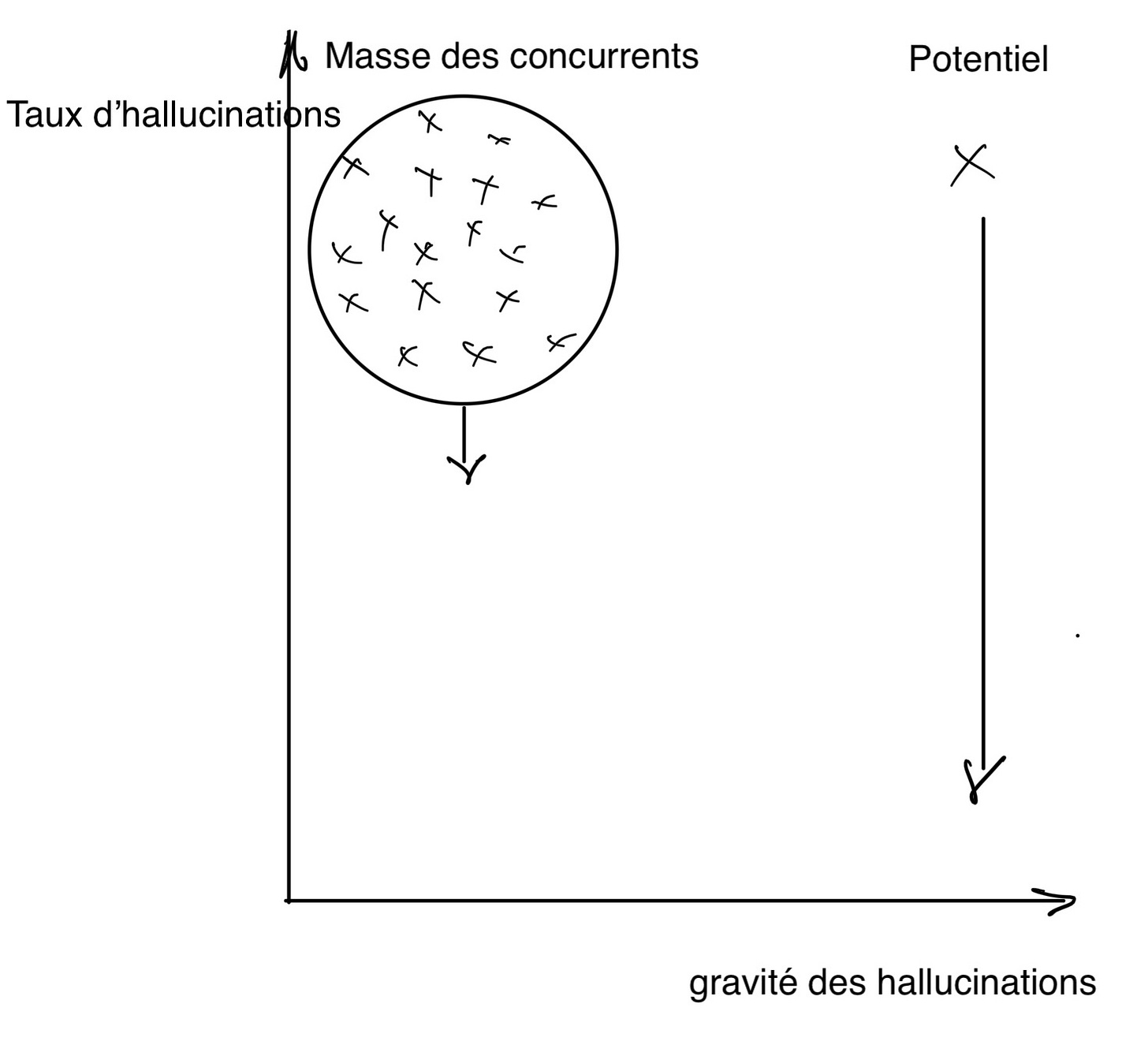

Les conséquences sont importantes pour le développement de l’IA générative car les dégâts hallucinatoires perçus y sont plus rebutants que ceux potentiellement générés par l’homme. Dès lors, les produits d’IA générative vont se concentrer au moins dans un premier temps là où les hallucinations ne portent pas à conséquences. C’est pourquoi la génération d’images et de vidéos a plus de chances que la génération de textes, et au sein de la génération de textes, l’information a le moins de chances de percer. Les dégâts d’une image ratée sont faibles d’autant que l’erreur est facilement détectable, ceux d’une fausse information beaucoup plus graves (droit, médecine, finances, etc.). Il faut s’attendre à une pléthore de produits concurrents sur la génération d’images et de vidéos, lesquels progressivement réduiront leur taux d’hallucinations, donc le coût final pour l’utilisateur, tout en se différenciant sur la qualité du rendu.

Le réel potentiel de l’IA générative cependant est dans les domaines où les hallucinations sont potentiellement dangereuses car la concurrence sera inexistante. Les professionnels se croiront irremplaçables et feront de la résistance au changement, moquant les hallucinations des modèles censés les remplacer. C’est là où la réduction des hallucinations aura le plus de valeur et un potentiel réellement disruptif. C’est là où Google pourrait sentir le vent du boulet: quand l’IA générative s’attaquera réellement à l’information. Mieux vaut pour lui qu’il soit alors le premier:

A gauche du cadran, les concurrents risquent de s’entretuer et leurs produits de devenir des commodités. Ce seront à priori les générateurs d’images. Le coût moins élevé pour générer des images (et probablement des vidéos) que du texte milite dans la même direction: moins de contraintes, plus de concurrents. Comme le dit Nat Friedman:

Une image vaut mille mots.

Une IA générative d’images peut fonctionner localement sur un simple IPhone comme sur le cloud. Ce n’est pas le cas de ChatGPT qui demande plus de contexte. L’IA générative finalement peut suivre un développement inverse de l’internet. Pour ce dernier, l’image a succédé au texte (de Facebook à Instagram), avec un coût marginal de distribution quasi-nul mais croissant. Pour la première, le texte pourrait succéder à l’image avec un coût marginal de génération cette fois conséquent mais qui devrait baisser. : pour l’IA générative, on parle de pennies par prompt, pas de centièmes ou millièmes de pennies par image comme pour l’internet !

Les gagnants

Il est encore beaucoup trop tôt pour se prononcer mais puisque c’est la saison des pronostics, j’en risque quelques uns (qui peuvent changer à tout moment):

1/ l’IA générative d’images va prendre en premier avec une multitude de concurrents, les dommages hallucinatoires étant réduits.

2/ Midjourney me semble au dessus du lot avec un modèle économique intégré (transformeur et produit) du type Apple (hardware et OS): David Holz, le fondateur soigne le moindre détail pour rendre meilleurs les rendus des prompts, version après version.

3/ Un deuxième gagnant pourrait être Apple qui va intégrer Stable Diffusion dans le cahier des charges de ses puces M3, M4, etc. Proposer une solution locale permettra d’économiser des ressources, d’être conforme au RGPD et enfin de limiter l’empreinte CO2. La rapidité de réponse aux prompts sur un IPhone laisse encore à désirer mais cela va s’améliorer.

4/ Les opérateurs cloud partent avec un avantage de performance par rapport aux solutions locales qu’ils essaieront de maintenir au moins sur l’écosystème Android (80% des smartphones). Eux aussi investiront sur des Asics permettant le meilleur rendu et surtout le plus rapide. Aws, Azure et Google cloud profiteront du marché.

5/ l’IA générative de textes a plus de potentiel mais doit apprendre à gérer les hallucinations. L’intégration de ChatGPT dans Word et Office me paraît prometteuse car il est très bon dans la création et mise en forme de texte, et cela sans hallucinations. Cette intégration s’insérerait parfaitement dans le modèle payant d’Office 365. Microsoft pourrait ainsi mettre en valeur son investissement dans OpenAI. En revanche, je ne crois pas beaucoup au succès de ChatGPT dans Bing: beaucoup trop d’hallucinations qui dérangeront ses utilisateurs et un modèle économique publicitaire peu adapté. Cela ne suffira pas à déranger Google…

6/ Puis des IA de langage spécialisées par profession (produits de niche), fondées sur des modèles exploitant ChatGPT, vont émerger. Leur taux d’hallucinations sera réduit du fait de la qualité des données et des feedbacks. Copilot est un précurseur de ce type de produits.

6/ Enfin pourquoi pas des mélanges entre IA de langage et de génération d’images.

L’inconnue reste l’IA réponse à tout (fantasmée par ChatGPT), c’est à dire ChatGPT sans les hallucinations. C’est le rêve de Google qui hésite encore sur le sujet, conscient du caractère toxique des hallucinations. Instruit par l’expérience Waymo, il n’est pas pressé d’exposer ses produits IA au public, voulant sortir le produit « parfait ». Il sera intéressant de voir si et le cas échéant comment la stratégie aventurière d’OpenAi arrivera à bousculer le tempo de Google et le faire sortir du bois …

Bonne semaine,

Hervé