Les cimetières sont remplis de sociétés qui n’on pas compris les règles du jeu.

D’après Wikipedia:

La course de la Reine Rouge tire son nom d'un épisode fameux du livre de Lewis Carroll : De l'autre côté du miroir (deuxième volet d'Alice au pays des merveilles) au cours duquel le personnage principal et la Reine Rouge se lancent dans une course effrénée. Alice remarque alors : « On arriverait généralement à un autre endroit si on courait très vite pendant longtemps, comme nous venons de le faire. » Et la reine lui explique : « Ici, vois-tu, on est obligé de courir tant qu'on peut pour rester au même endroit. Si on veut aller ailleurs, il faut courir au moins deux fois plus vite que ça4 ! »

Un premier bilan

Les stratégies différenciées de Microsoft, Alphabet, Snap et Meta concernant l’intégration de l’IA générative constituent une véritable étude de laboratoire. Microsoft et Snap ont foncé pour inclure de l’IA générative au cœur de leur offre de service, Alphabet et Meta sont restés en retrait, en observateurs attentifs plutôt qu’en acteurs. On peut déjà considérer les résultats d’une approche avec et sans IA générative.

Microsoft a fait grand bruit avec l’introduction de Bing Chat, moteur de recherche piloté par GPT-4. En février 2023, Satya Nadella proclamait fièrement: “nous allons faire danser Google”. Subitement Google était relégué par la presse au rang de Kodak, son moteur de recherche continuant à évoluer à l’allure d’un pachyderme. Fin février, Snap introduit “My AI”, un bot qui devient par défaut l’ami de tous les membres du réseau. Mais que fait Meta qui n’a toujours pas de produit opérationnel à proposer à ses utilisateurs et divulgue ses propres modèles à qui veut bien les adopter ?

On peut déjà dresser un premier bilan de l’impact de ces nouveaux produits à base de ChatGPT, à la lueur des résultats de ces sociétés au deuxième trimestre 2023:

- Microsoft: le chiffre d’affaires de la division moteur de recherche progresse de 8 % d’une année sur l’autre. Ce n’est pas de l’hyper-croissance ! Où est la révolution Bing Chat ?

-Et ce d’autant qu’Alphabet, dans sa division recherche, sans IA générative, voit son chiffre d’affaires progresser de 5 %. Autrement dit, la part de marché de Bing, qui était de 3 % l’année dernière est maintenant de 3,1 % avec Bing Chat. Cela laisse un peu de temps à Alphabet pour préparer sa riposte, d’autant que Bing Chat a bénéficié de l’effet nouveauté !

-Snap de son côté voit son chiffre d’affaires baisser de 4 % d’une année sur l’autre alors que sa perte opérationnelle se creuse. Pourtant, de l’aveu de son PDG Evan Spiegel:

Depuis le lancement de My AI, notre chatbot alimenté par l'IA, plus de 150 millions de personnes ont envoyé plus de 10 milliards de messages, ce qui, selon nous, fait de “My AI” l'un des plus grands chatbots grand public disponibles aujourd'hui.

“My AI” n’a pas sauvé Snap, même si son bot est un des premiers à être intégré nativement à un réseau social.

-Le chiffre d’affaires de Meta progresse, lui, de 11 %, alors qu’il n’a toujours pas lancé son propre bot.

Il est un peu tôt pour tirer des conclusions définitives. Force cependant est de constater à partir de sociétés ayant une base d’utilisateurs suffisante pour faire décoller un produit à succès, qu’introduire de l’IA générative pour moderniser les produits existants n’amène pas de courant d’affaires supplémentaire significatif. En revanche, l’augmentation des coûts ne fait guère de doute:

Les précurseurs, comme Microsoft ou Snap ne semblent pas dégager d’avantages particuliers à l’introduction de nouveaux produits à base de bots. J’y vois en particulier trois raisons:

-les bots ne sont pas fiables, leur taux d’hallucinations étant trop élevé,

-ils sont complexes à manipuler, il faut maîtriser l’art du prompt pour en tirer le meilleur,

-ils sont chers à utiliser (inférence) pour un résultat incertain.

De ce fait une approche directe, c’est à dire sans bot, fait encore souvent gagner du temps et de l’argent.

Le dilemme de l’IA générative

Pour percer face à une approche directe, l’idée générale est d’améliorer la performance des modèles, c’est à dire réduire leur taux d’hallucinations et améliorer la pertinence de leurs réponses. Open AI a fait des sauts de géant entre GPT-1, GPT-2, GPT-3, ChatGPT et enfin GPT-4. On attribue ces sauts à la puissance croissante des modèles, reposant sur un nombre de plus en plus considérable de paramètres. Qu’est-ce donc qu’un paramètre ? J’ai demandé à GPT-4 une explication simple:

Un paramètre dans un modèle d'IA générative comme ChatGPT fait référence aux valeurs internes qui sont ajustées pendant la phase d'entraînement du modèle. Ces valeurs sont utilisées pour prédire la sortie d'un modèle pour une entrée donnée. Voici comment ces paramètres fonctionnent :

Poids et Biais : Dans les réseaux neuronaux, les paramètres les plus importants sont généralement les poids et les biais associés à chaque neurone. Les poids sont utilisés pour pondérer les entrées, et les biais permettent d'ajouter une constante pour ajuster la sortie. Ensemble, ils déterminent la relation linéaire entre l'entrée et la sortie de chaque neurone.

Apprentissage des Paramètres : Au cours de l'entraînement, ces poids et biais sont ajustés en utilisant une méthode d'optimisation (comme la descente de gradient stochastique) qui minimise une fonction de perte. Cette fonction de perte mesure la différence entre les prédictions du modèle et les vraies valeurs. L'objectif est de trouver les valeurs des paramètres qui minimisent cette différence.

Taille du Modèle : Le nombre total de paramètres dans un modèle peut être considéré comme la taille du modèle. Par exemple, GPT-3 avait 175 milliards de paramètres, ce qui le rendait capable de comprendre et de générer du texte dans une grande variété de contextes.

Rôle des Paramètres dans la Génération : Dans un modèle génératif, ces paramètres sont utilisés pour prédire la prochaine partie d'une séquence (comme le prochain mot dans une phrase). Le modèle utilise les mots précédents (et les paramètres appris) pour prédire le mot le plus probable ensuite.

En somme, les paramètres dans un modèle génératif comme ChatGPT sont les éléments fondamentaux qui permettent au modèle d'apprendre à partir des données et de faire des prédictions ou de générer de nouveaux contenus. Ils sont la clé de la capacité du modèle à comprendre et à manipuler la langue.

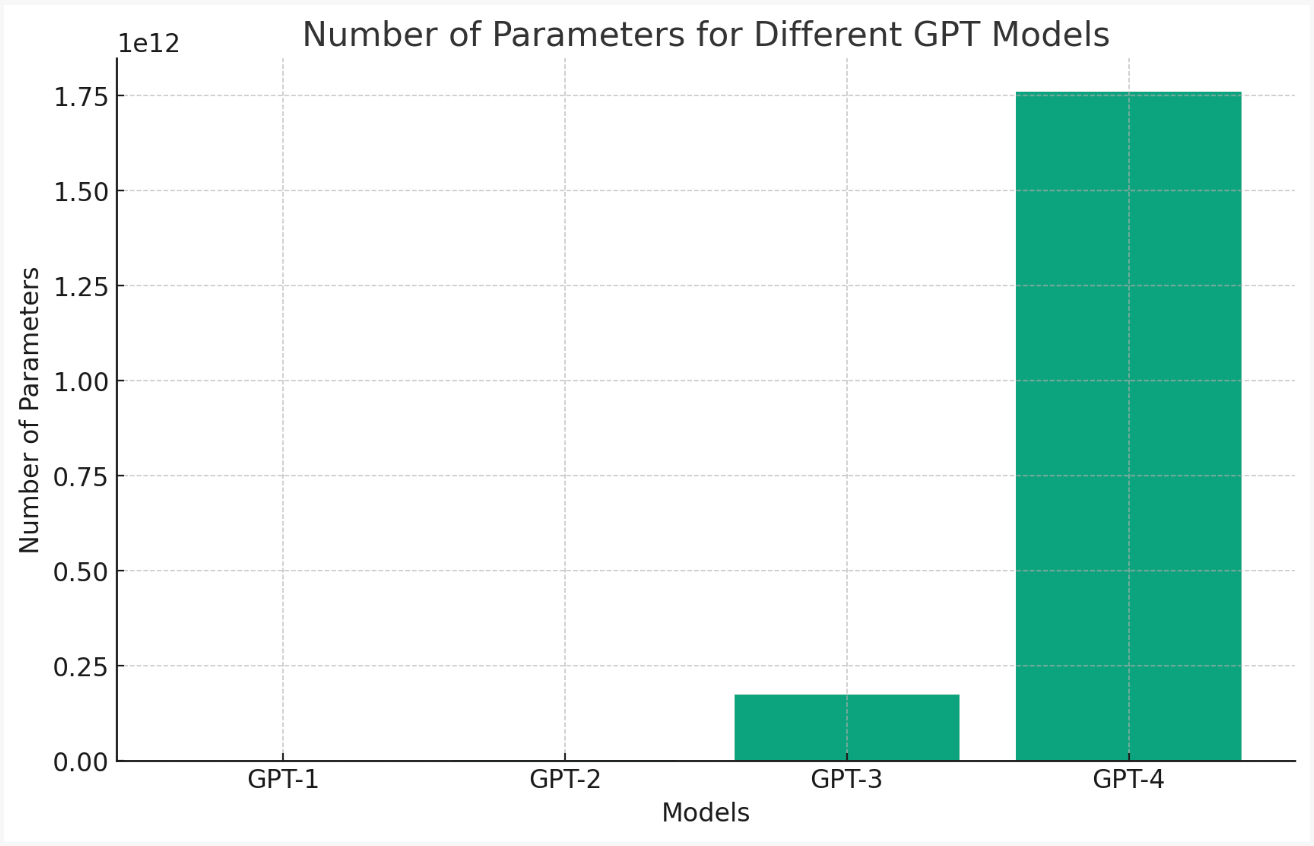

La référence de la performance d’un modèle est son nombre de paramètres:

La progression exponentielle du nombre de paramètres est ce qui frappe le plus:

On peut en déduire que la valeur marginale d’un paramètre est de plus en plus faible (les progrès réalisés entre GPT-3 et GPT-4 ne sont pas exponentiels loin de là). Ce point est problématique car il semble par ailleurs que le coût marginal d’un paramètre soit de plus en plus élevé. Pour faire tourner un modèle en inférence, il faut charger l’ensemble des paramètres dans la mémoire des GPU utilisés et faire des allers retour entre mémoire et calcul. Or il y a disproportion entre la demande de mémoire et celle de calcul qui oblige à une surcapacité en GPU pour faire tourner le modèle. D’après Andreessen Horowitz :

L'A100 a une performance nominale de 312 TFLOPS, ce qui, en théorie, réduirait l'inférence pour GPT-3 à environ 1 seconde. Il s'agit toutefois d'un calcul trop simple pour plusieurs raisons. Tout d'abord, pour la plupart des cas d'utilisation, le goulot d'étranglement n'est pas la puissance de calcul du GPU, mais la capacité d'acheminer les données de la mémoire graphique spécialisée vers les cœurs de tenseur. Deuxièmement, les 175 milliards de poids occuperaient 700 Go et ne tiendraient pas dans la mémoire graphique d'un GPU. Des techniques telles que le partitionnement et le streaming de poids doivent être utilisées. Enfin, il existe un certain nombre d'optimisations (par exemple, l'utilisation de représentations en virgule flottante plus courtes, telles que FP16, FP8, ou des matrices peu denses) qui sont utilisées pour accélérer les calculs.

L’A100 de Nvidia a une capacité mémoire de 40 GB ou 80 GB en option. En théorie, une puce serait suffisante pour une inférence, en pratique, il en faudra une dizaine au moins pour stocker les 175 milliards de paramètres de GPT-3.

GPT-4 comprend 10 fois plus de paramètres à stocker. Supposons que la capacité mémoire requise soit de 7 000 GB. L’inférence nécessite alors plus de 100 A100. Même la dernière génération H100 qui aura 10 fois la puissance de calcul de l’A100 ne dépassera pas 80 GB de mémoire. Le coût en GPU devient astronomique avec le nombre de paramètres, GPU qui seront sous-utilisés par ailleurs. Il y a donc des limites à la taille et à la performance des modèles qui semblent aujourd’hui atteintes.

Le parallèle avec la batterie électrique

Il ne faut pas se tromper de combat. Les infrastructures sont posées avec ChatGPT, Bard, Claude, Llama et peut être quelques autres. La puissance de ces modèles (nombre de paramètres) est peu ou prou plafonnée et leurs performances respectives vont converger. Des lors les modèles d’IA générative deviennent des commodités: seul le coût fait la différence entre les protagonistes.

Cette situation n’est pas sans rappeler celle des batteries électriques. Là aussi, la recherche de performance à tout prix est un leurre. La performance des batteries, mesurée cette fois par la densité énergétique, s’améliore à tout petit pas, sans révolution technologique. Le produit n’est pas parfait et en plus trop cher pour une réelle adoption. La parité de coût entre le moteur électrique et à combustion est le point de déblocage pour l’adoption. De ce fait, le producteur au plus bas coût l’emporte, même à densité légèrement dégradée. Tesla l’a bien compris, “verticalisant” au maximum son processus de production pour ne laisser aucune marge à un quelconque sous-traitant; les constructeurs chinois également en investissant dans les mines de lithium, cobalt ou nickel, le raffinage et modifiant la composition de la batterie pour économiser sur le prix des matériaux (fer au lieu de nickel, sodium au lieu de lithium). Pendant ce temps, les constructeurs traditionnels s’évertuent à inventer la batterie du futur, à l’état solide, se chargeant en 10 minutes pour se décharger sur 1 000 km. Le petit “hic” est que, quand bien même on arriverait à produire à l’échelle cette merveille technologique, son coût serait 3 à 4 fois supérieur à celui d’une batterie à l’état liquide…Les gagnants sont clairement les producteurs à bas coût, ce sont eux qui vont envahir le marché.

Il en est de même pour l’IA générative. Comme pour les batteries électriques, il y a deux méthodes principales pour réduire les coûts:

la “verticalisation”, en l’occurence l’utilisation de puces dédiées, pour l’entrainement et l’inférence, pour éviter de laisser des marges à Nvidia (stratégie à la Tesla)

la compensation du plus faible nombre de paramètres par une meilleure qualité des données utilisées pour l’entrainement. De ce fait, les modèles peuvent utiliser moins de GPUs (stratégie semblable à celle de Byd qui fabrique des batteries fer-phosphate au lieu de nickel-cobalt-manganese : les cellules de batteries des premières sont moins performantes mais plus stables que les secondes, le sytème de contrôle est moins volumineux et Byd en profite pour incorporer plus de cellules, compensant ainsi la moindre densité de chaque cellule par le nombre).

On peut imaginer d’autres méthodes, car la partie logicielle est bien plus importante que pour les batteries et donc bien plus malléable: par exemple, partition du modèle principal en sous-modèles pour éviter de tout charger dans la mémoire.

Aussi, même si ChatGPT semble être le modèle le plus accompli, les modèles à bas coût ne sont pas loin. D’après IEEE Spectrum:

Le rythme de l'innovation dans les puces GPU utilisées pour faire fonctionner l'IA est en retard sur la taille des modèles, ce qui signifie que nous pourrions bientôt être confrontés à un "mur de briques" au-delà duquel la mise à l'échelle ne pourra pas aller de manière plausible. "Nous ne pourrons pas toujours augmenter la taille des modèles", explique Dylan Patel (Semi-Analysis). "Il arrive un moment où, même avec des améliorations matérielles, compte tenu du rythme auquel nous augmentons la taille des modèles, nous ne pouvons tout simplement plus le faire.

Des efforts sont toutefois déployés pour contrer la logique de la mise à l'échelle. L'année dernière, les chercheurs de DeepMind ont montré que l'entraînement de modèles plus petits sur un nombre beaucoup plus important de données permettait d'améliorer considérablement les performances. Le modèle Chinchilla de 70 milliards de paramètres de DeepMind a surpassé le modèle GPT-3 de 175 milliards de paramètres en s'entraînant sur près de cinq fois plus de données. En février dernier, Meta a utilisé la même approche pour former des modèles beaucoup plus petits, capables de rivaliser avec les plus grands LLM. Le modèle LLaMa qui en a résulté était disponible dans une variété de tailles comprises entre 7 et 65 milliards de paramètres, la version à 13 milliards de paramètres surpassant le GPT-3 sur la plupart des points de référence.

Si les modèles d’IA générative deviennent une commodité indifférenciée, les grands gagnants seront les sociétés capables d’offrir un service d’IA générative à bas coût, les perdants seront le reste du monde…

Le mythe de l’intégration

L’espoir est qu’en intégrant un bot intelligent à son produit, celui-ci va être dopé, l’IA permettant d’aider l’utilisateur à en découvrir et exploiter les méandres. Microsoft utilise fort justement le terme de co-pilote. L’IA générative mâche le travail du pilote mais ne peut se substituer à lui. Pour utiliser une image, l’IA est à un produit lambda ce qu’est une batterie à un vélo électrique. Elle multiplie la puissance du cycliste mais ne se substitue pas à lui: il doit pédaler pour que le vélo avance…Quand on a fait l’expérience du vélo électrique, il est difficile de revenir en arrière (sauf si on est un vrai sportif), en particulier sur les terrains pentus. Est-ce pour autant que l’entreprise produisant des vélos électriques a un avantage déterminant ? Pas vraiment puisqu’il suffit que le concurrent incorpore également une batterie et un moteur dans certains de ses modèles pour revenir à niveau. Il en est de même pour les produits dopés à l’IA générative: Bing a beau être amélioré par l’intégration de GPT-4, Google en intégrant Bard arrivera au même résultat. Où résidera la différence au final ? dans la qualité du moteur de recherche. Si Google était meilleur avant, il est très probable qu’il reste meilleur après. Ce graphique très simple montre l’impact de l’IA générative sur l’univers concurrentiel au sein d’un secteur déterminé:

Comme on le voit sur le graphique, chaque entreprise devient plus performante grâce à l’IA générative, mais au final les positions concurrentielles restent inchangées, à partir du moment où tous l’adoptent. On a là une parfaite illustration de la course de la reine rouge: l’entreprise 5, si elle ne fait rien, verra sa performance passer au dessous de l’entreprise 1, si cette dernière incorpore l’IA générative. Si bien que l’entreprise 5 est obligée d’incorporer également l’IA générative pour maintenir sa position. C’est le cas de Google par exemple qui pour maintenir sa position par rapport à Bing doit intégrer Bard dans son moteur de recherche. Au final la position concurrentielle est inchangée avec un produit plus coûteux: qui gagne au change à part le producteur d’IA générative à bas coût qui va gagner progressivement des parts de marché.

Reprenons notre comparaison avec la batterie électrique. La batterie, on l’a vu dans différents articles comme Le pari fou de Dunkerque est d’avantage matière première que technologie. Rien ne ressemble plus à une batterie de voiture électrique qu’une autre batterie de voiture électrique. Aussi, le seul moyen pour un fabricant de voitures électriques d’éviter d’être embarqué dans la course de la reine rouge est de s’associer au producteur de batteries au plus bas coût (ou de l’intégrer). Ainsi, il pourra gagner un avantage de prix et améliorer sa position concurrentielle. La différence va se jouer sur le coût au kWh à niveau de performance donné, c’est à dire sur la capacité à se procurer les matériaux le meilleur marché possible (nickel, manganèse, cobalt, lithium, fer) et à dégager des économies d’échelle à la production. Le leurre consiste à essayer de se battre sur la performance brute, auquel cas il est impossible de ne pas participer à la course de la reine rouge. Le seul échappatoire est de réduire les coûts .

Il en sera probablement de même pour l’IA générative. Toutes les sociétés contribuant à en faire baisser le coût ont un large boulevard devant elles. On pense notamment aux opérateurs cloud qui jouent l’intégration verticale, mais aussi Meta qui divulgue son modèle en open source ou Apple qui va intégrer son modèle à ses propres puces. Ce sont les suspects habituels (Big Tech). Nike a peut être ses chances: pour le reste des sociétés, il faudra s’équiper de bonnes chaussures pour se lancer dans la course de la reine rouge…

Bonnes vacances,

Hervé

Encore une synthèse pédagogique et astucieuse. Hervé arrive à démontrer les enjeux, les points de blocage des innovations qui envahissent notre univers (ici, l'IA générative). Merci pour cette belle analyse.