IA: l’enlisement

Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

C’est le dernier texte avant la trêve estivale. Au moment où GPT-3 fait rêver (ou cauchemarder) sur l’IA du futur, je propose de revenir sur terre pour faire un point sur cette technologie.

Les leçons de Jim Simons

Jim Simons est le fondateur du Medallion Fund, un fonds quantitatif dont la performance a été époustouflante entre 1988 et 2018: 66 % par an avant frais de gestion et 39 % après, d’après Gregory Zuckerman, auteur de The man who solved the market:

Jim Simons a embauché de grands mathématiciens comme Robert Mercer ou Peter Brown en 1993, anciens chercheurs d’IBM travaillant sur la traduction assistée des langues par ordinateur. Après le retrait de Jim Simons de la gestion quotidienne de Medallion en 2010, les deux hommes ont pris la suite jusqu’à ce que Robert Mercer soit remercié dû à des positions politiques marquées. Ces deux mathématiciens étaient spécialisés dans l’intelligence artificielle, ne cherchant pas à comprendre les mots, les phrases ou le texte mais à faire des rapprochements statistiques, tirer une règle mathématique à partir des conclusions. Ils étaient des précurseurs ! Ils ont appliqué leurs méthodes dans les marchés: les trois hommes, et ceux qu’ils recrutaient, n’avaient aucune connaissance de la macro-économie, du fonctionnement des sociétés dont ils avaient même parfois du mal à se remémorer les noms ! Et ils considéraient que c’était mieux ainsi.

On peut tirer de cette réussite quelques enseignements:

L’intelligence artificielle est efficace comme machine de prédiction ! Elle est capable de battre les professionnels les plus aguerris ayant une très bonne compréhension de leurs marchés.

Elle peut saisir en masse des opportunités d’arbitrage se présentant sur les marchés financiers les plus divers.

Le plus extraordinaire est que l’approche de Jim Simons a fonctionné quand l’intelligence artificielle était à ses balbutiements (la régression était la norme) et continue de fonctionner quand elle est beaucoup plus évoluée. Au 28 juin 2020, le Medallion Fund était en hausse de 58% par rapport au début de l’année. L’art de l’investissement consiste à arbitrer une anomalie avant que les autres ne la voient et l’arbitrent également, jusqu’à ce qu’elle disparaisse. Quand le Medallion Fund était le seul à utiliser l’intelligence artificielle pour détecter des anomalies, on peut considérer que cela leur donnait un avantage consistant. Mais à partir des années 2010 et les progrès sur l’apprentissage profond, l’intelligence artificielle est devenue monnaie courante. La performance du Medallion Fund est pourtant restée excellente malgré l’afflux de compétiteurs. Pourquoi ?

L’intelligence artificielle repose sur trois piliers: les algorithmes, la puissance de calcul et les données. Les spécialistes se battent pour savoir quel pilier est le plus important, des séminaires y sont consacrés sans qu’une réponse tranchée ne domine. Le Medallion Fund est probablement un spécimen rare d’intégration entre une énorme quantité de données cumulées, des ordinateurs sur-puissants et des algorithmes supérieurs. La comparaison qui vient à l’esprit est Google dont les imitateurs n’arrivent qu’à la cheville, même après vingt ans. La supériorité de Google est due justement à cette intégration du parc de serveurs le plus étoffé du monde, d’une quantité de données cumulée incomparable et des plus grands mathématiciens. De même que Google trouve l’information la plus pertinente par rapport à ce que l’on cherche sans s’intéresser à comprendre pourquoi, de même le Medallion Fund trouve l’arbitrage le plus intéressant, sans s’intéresser à l’expliquer. Et les deux évoluent pour être toujours plus pertinents, la concurrence cherchant à combler l’écart. Dès l’origine Jim Simons s’est intéressé aux données de masse, a privilégié l’arbitrage sur devises, nettement plus traitées que les actions par exemple et unifié ses algorithmes pour pouvoir les appliquer en exploitant l’ensemble des données collectées; la culture d’IBM, celle de Robert Mercer et Peter Brown était celle des gros systèmes, de la puissance de calcul. Enfin le recrutement systématique de scientifiques de haut vol montre bien l’importance accordée aux algorithmes et au code. Le Medallion Fund est une exception, une supernova comme l’est Google.

Enfin, si le Medallion Fund défie les lois de la pesanteur, il n’en est pas de même des autres fonds gérés par Renaissance Technologies, ceux qui cherchent à exploiter des anomalies de long terme. D’après le Financial Times (12 juin 2020):

Renaissance Technologies, l'un des fonds spéculatifs les plus importants et les plus connus au monde, a prolongé sa récente série de mauvaises performances et a enregistré des pertes à deux chiffres cette année, selon les investisseurs.

Cette société de fonds informatisée de 75 milliards de dollars, fondée par l'ancien briseur de code de la guerre froide Jim Simons, a du mal à faire face à la volatilité accrue du marché provoquée par la pandémie de coronavirus.

Son fonds Renaissance Institutional Diversified Alpha a chuté de 8,8 % au cours de la première semaine de juin, et il est maintenant en baisse de 20,7 % depuis le début de l'année, selon les chiffres envoyés aux investisseurs.

Les fonds axés sur les actions de Renaissance ont été parmi les victimes les plus visibles de la déroute du marché provoquée par le coronavirus au début du mois de mars, ce qui a mis la société sur la voie de l'une de ses pires performances annuelles. La firme a refusé de commenter les chiffres. On peut à mon sens en tirer une conclusion: plus le temps interfère, moins l’intelligence artificielle est utile. Les automatismes ne fonctionnent plus, la prédiction se brouille. On se trouve face à des arbitrages de long terme nécessitant la compréhension, la créativité et l’huile de coude pour créer une filière de distribution, des arbitrages tels que décrits par Braudel et Bill Janeway (voir notre article Il est temps d'innover !):

Dans l'ère prémoderne et préindustrielle qui est le sujet de Braudel, «le jeu capitaliste ne concernait que les connexions inhabituelles, très spéciales ou à très longue distance». «C'est dans le commerce à longue distance que les capitalistes de Braudel ont prospéré: -le commerce à distance a certainement fait de super profits, il était après tout basé sur la différence de prix entre deux marchés très éloignés, avec l'offre et la demande dans l'ignorance complète l'un de l'autre et mis en contact uniquement par l'activité d'intermédiaires .. Si dans la plénitude de temps la compétition est apparue, si les super-profits disparaissaient d'une ligne, il était toujours possible de les retrouver sur une autre route avec des produits différents. Flexibilité illimitée pour arbitrer à travers un vaste espace géographique: c'est l'attribut définitif de Braudel du capitaliste prémoderne. Et la recherche de «super-profits» préfigure la recherche canonique par des investisseurs aventureux d'opportunités avec des «distributions asymétriques de résultats»: inconvénient limité («nous ne pouvons pas perdre plus que tous nos investissements ") et à la hausse sans limite.

Il ne s’agit plus de faire de l’argent en dormant comme le souhaite Jim Simons.

Les leçons que je tire intuitivement de cette réussite exceptionnelle et de ses limites:

L’avantage concurrentiel que peut apporter l’intelligence artificielle est limitée à quelques cas isolés, des exceptions intégrant puissance de calcul, données et mathématiciens, des Medallion, Google ou GPT-3.

L’efficacité de l’intelligence artificielle se dilue avec le temps, ce qui limite singulièrement la portée de son avantage concurrentiel pour la prédiction à long terme, la principale source de richesse. Pour créer un avantage concurrentiel, il faut utiliser l’IA pour des routines de prédiction à court terme qu’il faut sans cesse adapter au fur et à mesure que le temps passe. L’homme reste plus important que l’IA.

Le bla-bla autour de l’IA

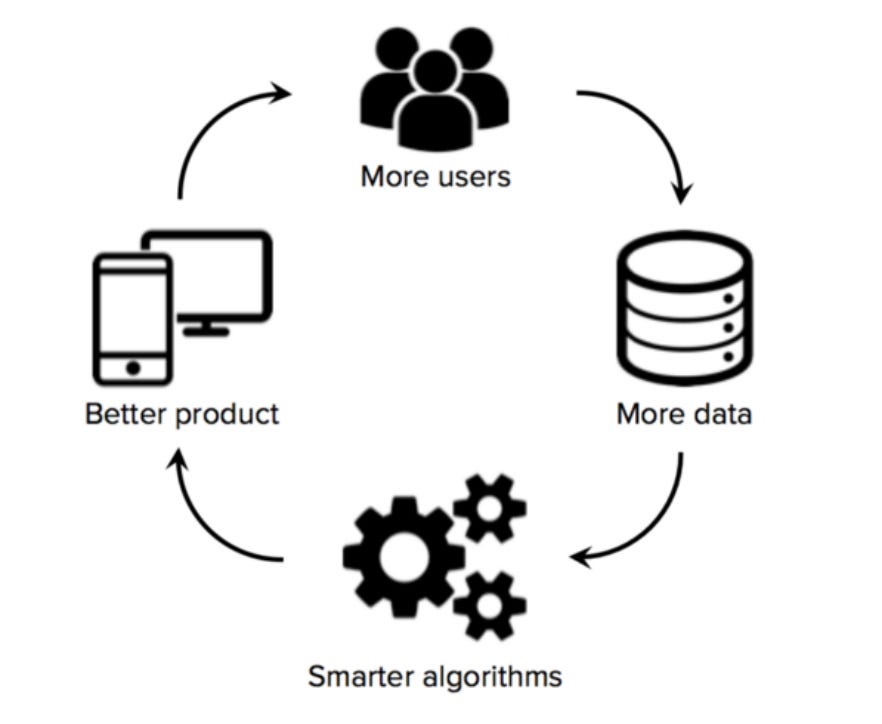

L’intelligence artificielle a un côté magique qui fait que dès que l’on la colle à une thématique ou un produit, par miracle, un effet réseau des données est censé se produire, propulsant l’avantage concurrentiel de celle ou celui-ci. C’est beau et fait toujours bon effet dans une présentation:

J’ai dénoncé ce pseudo effet réseau dans cet article:

Une autre tarte à la crème est l’effet réseau lié à la possession de données. Le raisonnement est le suivant: plus on a de clients, plus on a de données et plus on a de données, mieux les algorithmes d’intelligence artificielle fonctionnent et permettent d’attirer de nouveaux clients. Prenez une idée, appliquez lui un algorithme d’intelligence artificielle et vous avez un effet réseau. Est-ce que l’ajout d’utilisateurs renforce le service pour l’ensemble de ceux-ci ? L’exemple de Netflix est une bonne illustration. Avec 160 millions d’abonnés, son système de recommandation doit être imbattable, lui donnant un avantage dans la course aux abonnés. Pourtant Disney lance un service de streaming en novembre et compte déjà plus de 26 millions d’abonnés. Partant de zéro, Disney a déjà un algorithme de recommandation performant...En fait Disney a acheté BAMTech en 2017, société technologique qui gérait le streaming d’HBO et de ligues sportives. BAMTech a apporté dans son escarcelle un savoir faire en apprentissage profond et données utilisateurs qui n’avait rien à envier à Netflix. Il y a deux éléments importants qui relativisent l’effet réseau des données:

1/ Il est relativement facile dans la majorité des cas usuels d’acquérir des données de base pas cher ou même de les récupérer (en surfant sur le web). Des données plus spécialisées peuvent valoir plus cher mais elle ne découlent pas d’abonnés à un service (exemple des données médicales).

2/ Il est important d’obtenir une masse critique de données mais au delà d’un certain point, l’acquisition de données devient trop chère par rapport à leur utilité marginale. On se retrouve dans le cas des sociétés de logiciel dont le coût d’acquisition des clients devient prohibitif par rapport à la valeur qu’ils vont apporter.

Stitch fix illustre bien l’écart entre le discours et la réalité des affaires. Cette société fournit sous abonnement des habits choisis par un hybride de stylistes et d’intelligence artificielle. Le pitch est l’effet réseau magique: plus de données sur les abonnés permet de mieux calibrer le service, de satisfaire les clients, de leur vendre plus et d’en faire venir d’autres, ce qui augmente la base de données, etc. Le coût d’acquisition du client est donc censé baisser avec le nombre. Les résultats de l’entreprise ne corroborent pas cette thèse: les charges (essentiellement commerciales) montent plus vite que le chiffre d’affaires. La réalité est probablement qu’au départ, l’offre de Stitch Fix a séduit les fans, principalement des femmes, et que la société doit viser maintenant des clientèles moins convaincues du service (les hommes notamment). Encore une fois, où est l’effet réseau des données ? Prétendre qu’il existe un effet réseau des données revient à admettre une supériorité intrinsèque à la propriété des données. Du seul fait de cette propriété l’algorithme de prédiction serait supérieur à ce qu’on peut faire par ailleurs, s’auto-améliorant constamment et laissant sur place la concurrence. Cela reste à démontrer: si un algorithme est efficace à 25%, c’est à dire a un taux d’erreur de 75 %. Un algorithme plus précis à hauteur de 30% aura un taux d’erreur de 70%. L’amélioration du taux d’erreur est de 7 % et l’algorithme reste très imprécis. Si en revanche un algorithme est efficace à 98 % avec un taux d’erreur de 2 %, une plus grande précision de l’algorithme à 99 % représente une amélioration de 50 % du taux d’erreur. Cela fait la différence.. On peut donc d’abord s’interroger sur la qualité de la prédiction de l’algorithme. Pour la plupart des usages, c’est à dire la prédiction du goût des utilisateurs, l’algorithme est à mon avis inefficace à la base. Dès lors, une amélioration, même de 20 % (passage de 25 % à 30 % ne fera pas une différence perçue). Netflix réussit car il a su créer la liquidité maximale sur sa plateforme, à coût d’investissements massifs dans les films et séries, non parce que les données lui permettent de cerner le mieux possible les goûts des utilisateurs et ainsi de mieux choisir les films. En revanche pour une application de traduction, médicale, de détection de fraude, où le taux d’erreur est bien plus faible, les données peuvent faire la différence. C’est ainsi que Deepl (issu de Linguee) est à mon sens bien meilleur que Google Traduction, car il a accès à toutes les données de cette encyclopédie linguistique. Je ne suis pas persuadé que Deepl ait une puissance de calcul qui dépasse celle de Google ou des ingénieurs plus astucieux. Leur supériorité en matières de données fait la différence.

Mais c’est un cas rare. En effet, quand la qualité de la prédiction algorithmique est bonne, elle est le plus souvent liée à des données faciles à obtenir, souvent publiques et faciles également à traiter. L’intelligence artificielle fait alors la différence par rapport à l’homme, mais les sociétés qui l’utilisent se neutralisent mutuellement, car elle est facile à appliquer. Prenons l’exemple des taxis. Leur avantage concurrentiel, en dehors du numerus clausus, reposait sur la connaissance approfondie d’une ville nécessitant trois ans d’apprentissage et leur permettant de choisir le plus court trajet pour aller de A à B. Les applications de type Waze reposant sur l’intelligence artificielle ont anéanti l’avantage des taxis: n’importe quel détenteur de permis B peut faire leur métier aussi bien avec plus de transparence. L’intelligence artificielle a décimé la profession de taxi. Pourtant, elle n’a pas donné d’avantage à Uber ou Lyft. Ces derniers peuvent vanter l’avantage des données qu’ils collectent et qui les rendent plus intelligents. C’est le pitch marketing. Voici ce qu’affirmait Uber dans son document d’introduction en bourse:

Réseau massif. Notre réseau massif, efficace et intelligent se compose de dizaines de millions de conducteurs, de consommateurs, de restaurants, d'expéditeurs, de transporteurs, de vélos et de scooters électroniques sans station d'accueil, ainsi que de données sous-jacentes, de technologies et d'infrastructures partagées. Notre réseau devient plus intelligent à chaque voyage. Dans plus de 700 villes du monde entier, notre réseau permet à des millions de personnes, et nous espérons qu'à terme, des milliards, de se déplacer en appuyant sur un bouton.En fait l’avantage d’UBER, et de toute société de ce type, repose sur la liquidité de sa plate-forme, liquidité obtenue par des $ milliards investis pour attirer chauffeurs et passager. L’avantage doit être gagné ville par ville, le transport étant local. Cela explique la floraison de compétiteurs et le sang versé pour obtenir la suprématie. L’intelligence artificielle a permis Uber mais ne lui a pas donné de supériorité car elle créé une routine facilement réplicable. C’est tout le problème avec la généralisation de l’IA facilitée par les bibliothèques Open source comme TensorFlow. Des prédictions réalisées par l’homme vont être remplacées par des prédictions algorithmiques, rendant obsolètes de nombreuses tâches, sans créer pour autant d’avantages pour les nouveaux. Plus les données seront homogènes et faciles à traiter (le passé étant un bon indicateur de ce qui va se passer dans le futur), moins l’intelligence artificielle sera différentiante. La technique de Google avec TensorFlow est la même qu’il utilise avec Chrome ou Kubernetes. Je l’ai mentionnée dans mon article Zoom peut-il chambouler le cloud ?

L’idée est toujours la même: prendre le contrôle d’une technologie qui réduit les frictions antérieures (Android, Chrome, Kubernetes, TenserFlow), la rendre open source pour en généraliser l’adoption, établir sa version améliorée propriétaire et peser sur les standards de place pour structurer le marché à sa convenance. Chrome est le cas d’école. Google a rendu open source le bloc navigateur Chromium, objet d’un de ses programmes de recherche, lequel a servi pour concevoir d’autres navigateurs (Opera, Firefox et maintenant Microsoft Edge, une reconnaissance de la défaite de Microsoft Explorer). Puis Google a rajouté à Chromium des fonctionnalités propriétaires (plug in) dans un navigateur qu’il a appelé Chrome. Ce dernier s’est montré supérieur à ses concurrents open source ou non.Google veut simplement banaliser l’intelligence artificielle et garder la supériorité grâce à sa puissance de calcul et ses mathématiciens capables d’ajouter un petit plus aux algorithmes pour faire toute la différence (comme le Medallion Fund pour la prévision financière).

L’enlisement

J’irai même plus loin: dans la plupart des cas, l’IA détruit de la valeur que le logiciel, dans ses premières versions, a construit. Le coût marginal nul s’applique au logiciel et à la distribution internet. C’est ce qui a permis la constitution des agrégateurs, des opérateurs cloud ainsi que d’une myriade de sociétés « as a service » comme MongoDB, Alteryx, ServiceNow, etc. qui dominent l’économie et les indices boursiers. Ces sociétés sont bâties sur les économies d’échelle rendues possibles par le coût marginal zéro. Comme l’a très bien montré Andreessen Horowitz dans ce billet, l’intelligence artificielle ajoute un coût variable au logiciel et en détruit les économies d’échelle:

Nous croyons énormément au pouvoir de l'IA pour transformer les entreprises : Nous avons investi dans cette thèse, et nous continuerons à investir massivement dans les entreprises d'IA appliquée et dans l'infrastructure d'IA. Cependant, nous avons remarqué dans de nombreux cas que les entreprises d'IA n'ont tout simplement pas la même construction économique que les entreprises de logiciels. Parfois, elles peuvent même ressembler davantage à des entreprises de services traditionnelles. C'est notamment le cas de nombreuses sociétés d'IA :

1/ Des marges brutes plus faibles en raison d'une utilisation importante de l'infrastructure de cloud computing et d'un soutien humain permanent

2/ Des difficultés d'échelle en raison de l'épineux problème des cas marginaux ;

3/ Des barrières à l’entrée plus faibles en raison de la banalisation des modèles d'IA et des difficultés liées aux effets des réseaux de données.

De manière anecdotique, nous avons observé une tendance étonnamment cohérente dans les données financières des entreprises d'IA, avec des marges brutes souvent de l'ordre de 50 à 60 % - bien en dessous de la barre des 60 à 80 %+ pour des entreprises SaaS comparables. Les capitaux privés en phase de démarrage peuvent cacher ces inefficacités à court terme, d'autant plus que certains investisseurs privilégient la croissance à la rentabilité. Il n'est cependant pas certain qu'une optimisation à long terme des produits ou de la mise sur le marché (GTM) puisse résoudre complètement le problème.Les sociétés de software sont des bijoux car:

Elles ont un code propriétaire qui constitue leur avantage: l’open source est juste un marche-pied pour le code propriétaire, un faire-valoir du 1 % par le 99 % qui en favorise l’adoption.

Elles peuvent s’étendre et conquérir le monde entier avec des marges brutes de l’ordre de 70 % à 80 %.

L’ajout de l’intelligence artificielle les fait revenir sur terre: l’entraînement des modèles et même la conception de la puce requiert de la main d’oeuvre souvent locale, pour optimiser l’efficacité des prédictions. Il faut de plus souvent contrôler le travail de l’IA. 80 % du personnel (35 000 sur 43 000) de Facebook travaille dans la sécurité à surveiller l’épurage imparfait du réseau effectué par l’IA. Ce sont des charges variables considérables. Les données de surcroit sont rarement propriétaires et quand elles le sont n’apportent pas forcément grand chose aux algorithmes. Au final c’est un gouffre pour les sociétés de logiciel sans leur apporter d’avantage supplémentaire, juste une mise à niveau. Les gagnants sont ceux qui proposent la puissance de calcul comme les fabricants de puces (Nvidia, Intel) ou les opérateurs cloud. Le billet d’Andreessen Horowitz fait justement remarquer:

Par exemple, les ressources de calcul nécessaires pour former des modèles d'IA de pointe ont été multipliées par plus de 300 000 depuis 2012, alors que le nombre de transistors des GPU NVIDIA n'a augmenté que d'environ 4 fois !Comme au temps de la ruée vers l’or, ce sont les fabricants de jeans et de piolets qui se sont enrichis, plus que les chercheurs d’or.

Enfin l’intelligence artificielle, dans la mesure où elle s’appuie sur une montagne de données a une dimension géopolitique: où sont conservé ces données, comment sont elles exploitées ou contrôlées par les autorités locales ? Ces considérations impliquent des frictions et donc des coûts supplémentaires. Au pire, la sanction peut être une interdiction comme pour TikTok en Inde et peut-être aux Etats-Unis.

L’intelligence artificielle peut être illustrée par la course de la Reine rouge dans Alice au pays des merveilles:

"Dans notre pays, dit Alice, encore un peu haletante, on arrive généralement à aller ailleurs - si on court très vite pendant longtemps, comme nous le faisons.

"Un pays plutôt lent !" dit la Reine. "Maintenant, ici, vous voyez, il faut courir le plus vite possible, pour rester au même endroit. Si vous voulez aller ailleurs, vous devez courir au moins deux fois plus vite que ça !" Dans une récente colonne, Morning Brew s’interroge sur un éventuel nouvel hiver de l’intelligence artificielle, comme on l’a eu dans les années 80. Aura-t-on la courbe classique de l’innovation et sommes nous à son pic ?

L’exemple du Medallion Fund et de Google montrent que l’IA peut être un facteur différenciant à condition de cumuler données, puissance de calcul et mathématiciens, le tout dans une intégration propriétaire. Il y a beaucoup d’appelés mais il y aura peu d’élus...

Sauver le soldat IA

Dans Zero to One, Peter Thiel écrit:

L'idéologie de l'informatique

Pourquoi tant de gens mésestiment-ils le pouvoir de la complémentarité? Ça commence à l'école. Les ingénieurs logiciels ont tendance à travailler sur des projets qui remplacent les efforts humains, car c'est pour cela qu'ils sont formés. Les universitaires font leur réputation grâce à des recherches spécialisées; leur objectif premier est de publier des articles, et publier signifie respecter les limites d'une discipline particulière. Pour les informaticiens, cela signifie réduire les capacités humaines en tâches spécialisées que les ordinateurs peuvent être formés à conquérir un par un. Il suffit de regarder les domaines les plus branchés de l'informatique aujourd'hui. Le terme même de «machine learning» évoque des images de remplacement, et ses partisans les plus convaincus semblent croire que les ordinateurs peuvent apprendre à effectuer presque toutes les tâches, tant que nous leur fournissons suffisamment de données de formation. Tout utilisateur de Netflix ou Amazon a expérimenté les résultats de apprentissage automatique de première main: les deux sociétés utilisent des algorithmes pour recommander des produits en fonction de votre historique de visualisation et d'achat. Alimentez-les et les recommandations s'améliorent de plus en plus. Google Translate fonctionne de la même manière, fournissant des traductions approximatives mais utiles dans n'importe quel des 80 langues qu'il prend en charge, non pas parce que le logiciel comprend le langage humain, mais parce qu'il a extrait des modèles par l'analyse statistique d'un énorme corpus de texte. L'autre mot à la mode qui résume un biais en faveur de la substitution est le «big data». Les entreprises d'aujourd'hui ont un appétit insatiable pour les données, croyant à tort que plus de données créent toujours plus de valeur. Mais les mégadonnées sont généralement des données stupides. Les ordinateurs peuvent trouver des modèles qui échappent aux humains, mais ils ne savent pas comment comparer des modèles provenant de différentes sources ou comment interpréter des comportements complexes. Les informations exploitables ne peuvent provenir que d'un analyste humain (ou du type d'intelligence artificielle généralisée qui n'existe que dans la science-fiction). Nous nous sommes laissés envoûter par les mégadonnées uniquement parce que nous fétichisons la technologie. Nous sommes impressionnés par les petits exploits accomplis par les ordinateurs seuls, mais nous ignorons les grandes réalisations de la complémentarité parce que la contribution humaine les rend moins étranges. Watson, Deep Blue et les meilleurs algorithmes d'apprentissage automatique sont cool. Mais les entreprises les plus précieuses à l'avenir ne se demanderont pas quels problèmes peuvent être résolus avec les seuls ordinateurs. Au lieu de cela, ils demanderont: comment les ordinateurs peuvent-ils aider les humains à résoudre des problèmes difficiles?Ce texte est remarquable dans la mesure où il montre comment les hommes ont tendance à faire de la technologie un fétiche et ainsi à prendre de mauvaises directions. Pour Peter Thiel, en allant plus loin, la complémentarité est la base sur laquelle construire un avantage concurrentiel, qui sera d’autant plus marqué qu’il n’y aura pas de concurrent! Faire zig quand les autres font zag...Palantir, valorisé à environ $30 milliards maintenant, a été bâti sur cette hypothèse.

Car l’IA et l’homme sont bien complémentaires:

L’IA est très forte dans les environnements stables, statistiquement prévisibles. C’est pourquoi le long terme, qui apporte son lot de signes noirs échappe à l’IA. Paradoxalement, c’est dans ces environnements stables que l’homme peut manquer de jugement, emporté par ses impressions., alors que l’IA va voir des corrélations qui lui échappent. En cherchant à expliquer les choses, l’homme peut sur-réagir. En lançant un dé cinq fois consécutivement, il tombe systématiquement sur le 4. La sixième fois, il va surpondérer la probabilité que le 4 tombe une nouvelle fois car après tout, le dé est peut-être pipé...

L’homme est très fort quand il y a peu de données (il comble les manques), quand il y a des ruptures et des scénarios inattendus.

L’homme a une capacité de jugement, pas la machine. Cette dernière peut essayer d’apprendre à juger à conditions que les conséquences d’une action ne soient pas trop complexes et inattendues, en bref qu’elles soient statistiquement prévisibles. C’est pourquoi passer d’une IA prédictive à une IA qui exécute est semé d’embuches. Le débat autour des voitures sans chauffeur en est une illustration: peut on accepter que la voiture décide s’il vaut mieux tuer un vieillard qui traverse sans regarder ou l’homme dans la fleur de l’âge qui fait son jogging le long de la route.

L’IA est encore plus biaisée que l’homme dans ses prédictions car les biais des concepteurs sont codés, gravés dans le marbre. Au moins l’homme peut essayer de corriger ses biais ou de les faire corriger par d’autres.

Enfin l’homme a une capacité de sentir que n’a pas la machine. Les puces analogiques sont encore très en retard par rapport à nos cinq sens. Elles sont à la machine ce que les yeux ou les oreilles sont à l’être humain. Les puces analogiques qui convertissent un signal analogique en digital et vice-versa sont extrêmement difficiles à concevoir et intégrer, ont une durée de vie très longue, n’étant pas remises en question par la miniaturisation des processus de fabrication. Les leaders sont Texas Instrument et Analog Devices (surtout après sa fusion avec Maxim Integrated). La lenteur d’évolution de ces puces liée à leur intégration dans de nombreux systèmes industriels coûteux fait que les sens humains seront encore supérieurs pendant longtemps.

La supériorité de l’homme sur l’IA est donc écrasante, même si l’IA est bien meilleure dans certains cas où les corrélations sont fortes et difficiles à percevoir à l’oeil nu. L’homme prédit et exerce son jugement sans séparer les deux fonctions, mesurant intuitivement les conséquences de ses décisions. L’IA organise la division du travail: : elle peut traiter en masse des routines de prédiction, la contrepartie étant qu’elle laisse à l’homme le jugement pour exercer ou non ces routines (sinon, c’est vite la catastrophe !). Plus de prédictions entraine plus de jugement, donc plus de travail pour l’homme. Un exemple tout simple: quand Netflix fait tourner ses algorithmes pour aider à choisir une série, il laisse à l’abonné la décision de cliquer ou non. Ce dernier doit exercer son jugement et décider si la série vaut la peine. Il y a bien un travail homme/machine, mais l’astuce y est de faire travailler l’homme sans le rémunérer...Dans le système ancien, la chaine TV linéaire faisait la prédiction de ce que les spectateurs allaient aimer et la programmation qui s’ensuivait: le spectateur se faisait mâcher le travail, souvent à son détriment. Les meilleurs outils décisionnels combineront la capacité de prédiction en masse de l’IA, complétée, contrôlée, amendée par le jugement humain. C’est la force du Medallion Fund: les données sont traitées en masse mais le cerveau humain doit sans cesse améliorer les agorithmes pour ne pas se faire rattraper par la concurrence. C’est également la force de Google: il lui faut sans cesse réviser ses algorithmes pour combattre les petits malins qui veulent faire tourner le moteur de recherche à leur profit (SEO). Ces deux maitres de l‘intelligence artificielle poussent tous les leviers à fonds: données, puissance de calcul, cerveaux. C’est la recette pour avoir un avantage concurrentiel pérenne.

Dans Zero to One, Peter Thiel explique comment lui est venu l’idée de Palantir, en essayant d’automatiser la détection de fraude quand il était encore chez Paypal: le problème était qu’à chaque fois qu’ils concevaient un algorithme savant, les fraudeurs le découvraient vite et le contournaient. Peter Thiel a fini par trouver la solution:

Les capacité d'adaptation des fraudeurs a trompé nos algorithmes de détection automatique, mais nous avons constaté qu'elle ne trompait pas aussi facilement nos analystes humains. Max et ses ingénieurs ont donc réécrit le logiciel pour adopter une approche hybride : l'ordinateur signalerait les transactions les plus suspectes sur une interface utilisateur bien conçue, et les opérateurs humains porteraient le jugement final quant à leur légitimité. Grâce à ce système hybride - nous l'avons appelé "Igor", du nom du fraudeur russe qui se vantait que nous ne pourrions jamais l'arrêter - nous avons réalisé notre premier bénéfice trimestriel au premier trimestre 2002 L’intervention humaine dans les processus d’intelligence artificielle est lourde mais peut se transformer en avantage si elle utilise judicieusement la complémentarité.

Finalement, les plus malins sont ceux qui gardent la partie algorithmique, les coûts fixes, et sous-traitent la partie humaine (le jugement) à leurs utilisateurs, sans les payer. En rendant le service addictif, ils leur font oublier qu’ils les font travailler (on présente ce travail positivement en vantant l’importance d’augmenter le choix...). Ils peuvent même endurer un taux de défaut très important dans leurs prédictions car les rares fois où les utilisateurs cliquent suffisent largement à compenser le coût des erreurs de prédiction qu’ils peuvent faire par ailleurs. Ce sont les dominants de la publicité digitale...les Facebook, Google et Amazon, qui arrivent à maintenir leur modèle économique de coût marginal zéro, grâce à la supériorité écrasante de leurs données et puissance de calcul...Leur capacité prédictive n’est peut être pas formidable, simplement un peu meilleure que celle des autres et cela suffit, comme le Medallion Fund à faire la différence...

Bonnes vacances!

Hervé