Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Pour les abonnés, podcast à suivre.

La dernière vague d’innovations a eu pour centre le smartphone (plus de 4 milliards d’appareils en usage aujourd’hui). Y aura-t-il une nouvelle vague et si oui quel sera son centre ?

De ValueWalk (31 janvier 2020):

Avec tous les discours sur le coronavirus qui paralysent la chaîne d'approvisionnement d'Apple, on pourrait penser que la société ne pourra pas lancer de nouveaux produits au cours du premier semestre de l'année. Cependant, l'analyste de renom Ming-Chi Kuo s'attend à ce qu'Apple lance AirTags, un nouveau tapis de recharge sans fil et d'autres produits malgré l'impact du coronavirus sur sa chaîne d'approvisionnement en Chine.

Rumeurs sur les AirTags d'Apple

Dans une note vue par MacRumors, Kuo a parlé des balises de suivi qui supportent l'ultra-large bande. MacRumors a indiqué l'année dernière que la société travaillait sur des étiquettes de suivi similaires aux étiquettes Tile et Cube. Le code dans l'iOS 13 suggérait l'existence du produit et faisait référence à un nom possible : AirTags.

Les AirTags d'Apple, ou quel que soit leur nom, n'avaient pas de nom dans la note de Kuo, mais il s'attend à ce qu'ils supportent l'ultra-large bande comme le fait la gamme iPhone 11. Cette technologie permettrait de localiser les balises avec plus de précision que si elles utilisaient le Wi-Fi ou le Bluetooth LE.

A première vue, ces AirTags n’ont rien de révolutionnaire. Reprenons tout d’abord le débat autour de la prochaine vague d’innovation informatique.

Le débat sur l’innovation informatique

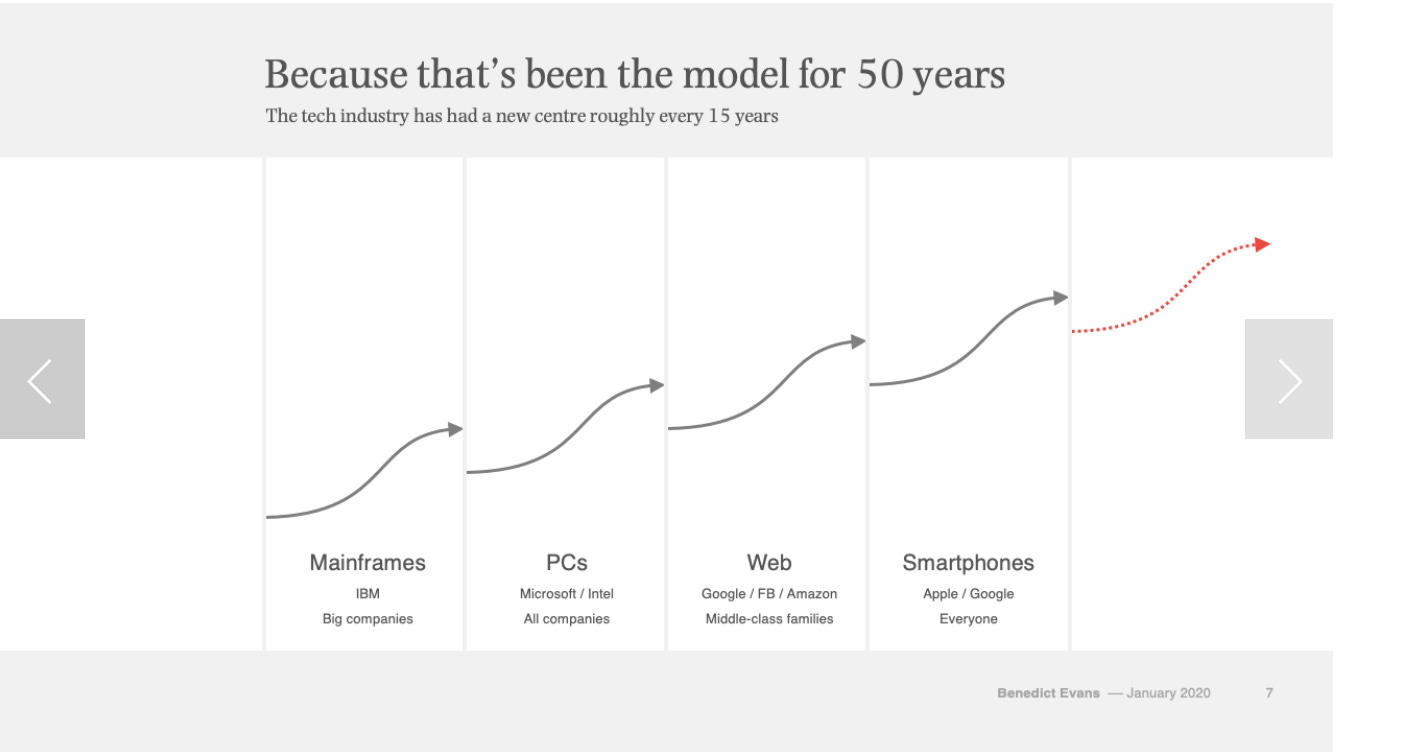

On a d’un côté le discours ambiant qui constate que le smartphone est arrivé à maturité, tout comme le PC il y a 20 ans et donc qu’il est destiné à être éclipsé par une nouvelle vague d’innovations. Benedict Evans est dans ce camp:

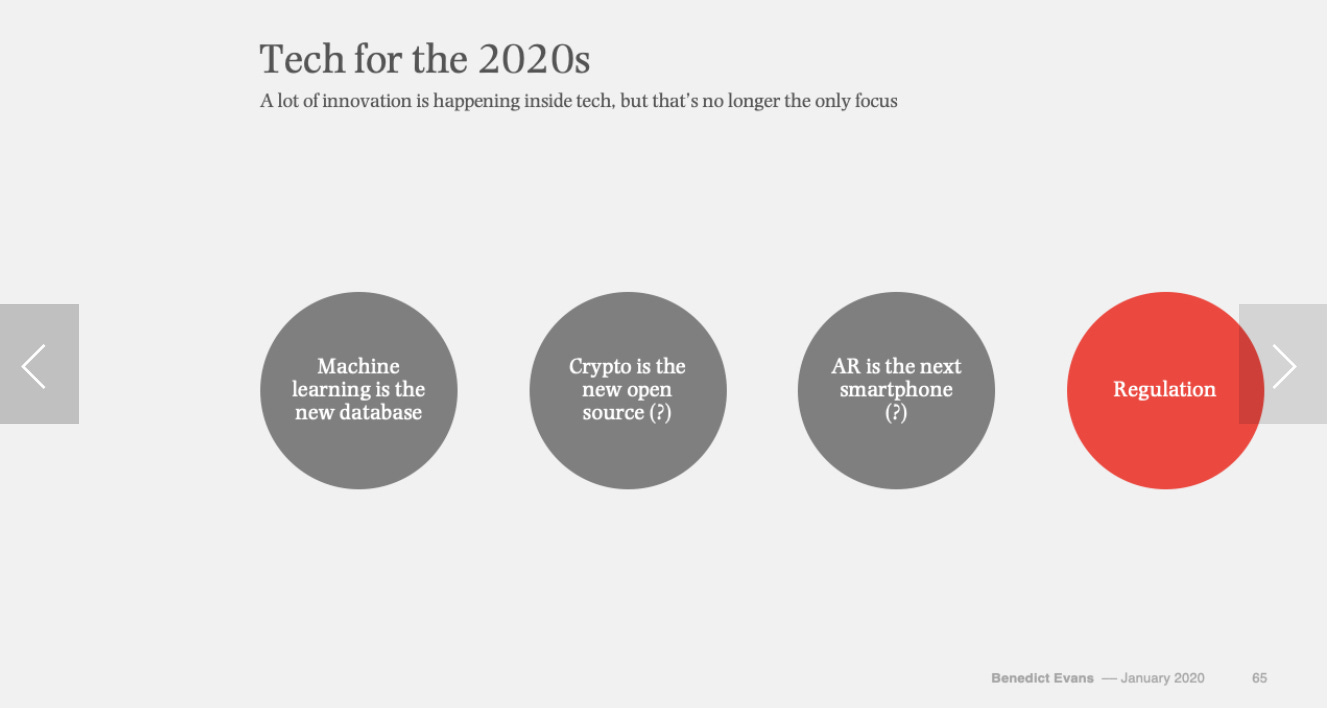

L’innovation, pour lui suit une courbe en S: stupide au départ puis excitante, enfin ennuyeuse, prête à être remplacée. Schématiquement, tous les quinze ans, il faut s’attendre à un nouveau S. Quel sera donc le prochain ? Benedict Evans n’a pas la réponse mais suggère différentes voies possibles, la plus probable selon lui étant la réglementation (encore au stade stupide):

De l’autre côté, certains prêchent la fin de l’Histoire. C’est le cas de Ben Thompson qui considère l’ère de l’ordinateur comme arrivée à son terme. Il prend du recul et compare cette ère à celle de l’automobile dans cet article:

Le premier constructeur automobile américain, Duryea Motor Wagon Company, a été fondé en 1895 ; 34 autres constructeurs automobiles seront fondés aux États-Unis dans les cinq années suivantes. Puis, une explosion : 233 autres constructeurs automobiles ont été fondés au cours de la première décennie du XXe siècle, et 168 autres entre 1910 et 1919. A partir de ce moment, le rythme a continué à ralentir …

En 1920, la construction automobile était déjà dominée par GM, Ford et Chrysler. AMC, une combinaison de plusieurs marques plus petites, a été un bref challenger dans les années 1950 et 1960, mais les "trois grands" avaient surtout le marché pour eux, du moins jusqu'à ce que les importations commencent à apparaître dans les années 1970.

Ce n'est pas parce que la prolifération des nouveaux constructeurs automobiles s'est arrêtée que l'impact de l'automobile a ralenti le moins du monde : en effet, c'est surtout dans la seconde moitié du siècle que l'impact réel de l'automobile s'est fait sentir dans tous les domaines, du développement des banlieues aux grandes surfaces et à tout ce qui se trouve entre les deux. L'automobile a été le fondement de la transformation de la société, mais pas nécessairement des entreprises automobiles.

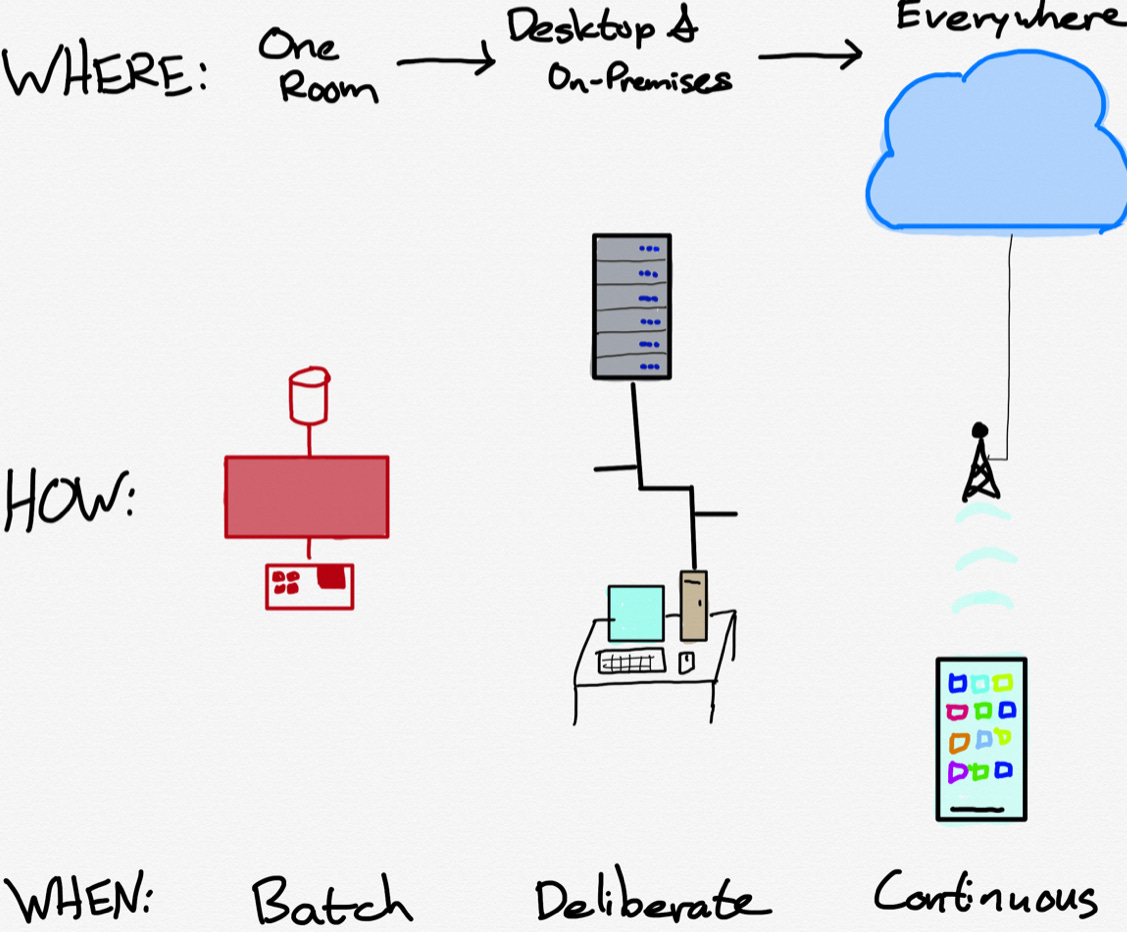

Le but ultime de l’automobile était de mettre une voiture dans chaque foyer. L’histoire était déjà écrite avec le modèle T (1907) qui introduisit la standardisation, meilleur moyen d’y arriver. La standardisation était la fin de l’histoire, l’automobile déroule le fil de ce concept depuis lors: la vague de création de nouvelles sociétés automobiles s’est arrêtée dans les années 30 et depuis, c’est la concentration. Général Motors, Ford et Chrysler étaient dominant en 1920, ils le sont encore aujourd’hui. La disruption n’existe pas. Pour lui, l’informatique est comparable. Le but ultime est de fournir à tout être humain un prolongement digital de lui même . Au départ l’outil était localisé dans des grandes pièces (unités centrales) avec traitement batch , puis sur chaque bureau (PC) et à la demande, enfin sur soi (smartphone) avec traitement continu. Ben Thomson représente ainsi cette évolution (sans révolution):

Le smartphone, alimenté par le cloud représente donc l’étape ultime, qui peut durer 50 ans. Si cette analyse est bonne, les GAFA sont installés pour longtemps ! Il y a cependant une manière différente de voir les choses qui réconcilie les deux points de vue: et si, en prenant encore d’avantage de recul, l’informatique avait pour but ultime de libérer l’information de ses carcans ?

La libération de l’information

L’informatique est alors vue comme une évolution de l’imprimerie, comme l’imprimerie est une évolution de l’écriture manuscrite et enfin l’écriture manuscrite comme une évolution de la tradition orale: un outil d’émancipation. L’écriture est un moyen de stocker et transporter l’information, une technologie plus puissante que la voix (tradition orale). Elle est naturellement liée au développement des villes et des empires qui nécessitent une importante coordination. Les premiers textes traitaient d’administration, de droit, d’éducation, de rituels. L’information était un outil de commandement, les scribes étaient les énarques de l’époque (antique). A information centralisée et peu véloce correspond une hiérarchie extrêmement centralisée. Le passage de l’argile et de la pierre au papier ont favorisé la circulation d’information et l’expansion des empires. L’écriture restait l’apanage d’une élite formée (moines copistes par exemple). L’invention de l’imprimerie a bousculé cette organisation hiérarchique. L’information devenait une affaire d’argent (coût de la presse à imprimer). Le pouvoir bourgeois pouvait s’imposer (parlements). L’informatique est une invention qui bouleverse le pouvoir bourgeois. Elle permet le transport bon marché et rapide de l’information qui devient progressivement accessible pour tout le monde. Chacun devient son propre patron. L’unité centrale réservait l’information et son transport aux grandes entreprises, le PC aux PME et particuliers éduqués (CompuServe, AOL, internet), le smartphone à 4 milliards de personnes sur la planète. Si on analyse l’innovation informatique avec ce regard, il devient vite patent que le smartphone n’est pas la fin de l’histoire. Il y a encore trois gaps majeurs à combler:

L’information contenue dans les objets, le monde physique, reste encore prisonnière. La digitalisation s’est arrêtée au smartphone, elle doit maintenant toucher le monde physique pour libérer son potentiel.

La libération de l’information censée redonner le pouvoir à l’homme face aux hiérarchies institutionnelles le rend prisonnier d’autres institutions: les GAFA. L’information ne lui appartient pas, elle appartient aux GAFA.

Le stockage et transport de l’information s’améliore à chaque étape de sa transformation. L’oral était peu sûr (les écrits restent, les paroles s’envolent). L’écriture a apporté une amélioration nette mais le papier peut être corrompu, moisir, être volé ou brûlé (Savonarole). L’informatique rend la duplication de l’information plus aisée mais également son piratage et le développement de fausses informations. Avec l’abondance, le bruit abonde également.

Il est probable que la prochaine courbe en S s’attaquera à un ou plusieurs de ces trois problèmes. Les crypto-monnaies sont intéressantes car elles cherchent à libérer l’information du carcan institutionnel en instaurant un régime auto-géré, sans permission. De plus elle transportent une information qui va de l’envoyeur au destinataire sans corruption d’aucune sorte. Le problème est que la crypto-monnaie n’a pas trouvé encore d’application commerciale qui pourrait enclencher le bas du S. Elle laisse de plus sans solution la digitalisation du monde physique. Les GAFA en profitent pour s’attaquer à la fois à l’internet des objets et à la sécurité, mais il le font à leur manière, en s’inscrivant dans le paradigme intelligence locale/cloud qui les renforce en même temps que le contrôle qu’ils exercent sur l’information.

Le prisme intelligence locale/intelligence centrale

Les GAFA sont contraints par leur prisme de fonctionnement qui est de coupler l’intelligence du smartphone (ou equivalent Echo pour Amazon), avec une intelligence centrale (le cloud). A la fois l’internet des objets et la sécurité sont vus à travers ce prisme. La conséquence est que ce qui se passe au niveau des objets n’a pas d’importance, ce qui importe est l’intelligence pour les voir ou les entendre et interpréter. L’évolution de l’iPhone à cet égard est caractéristique: d’une caméra de 2 megapixels au départ l’iPhone 11 pro est maintenant constitué de 3 caméras HDR de 12 megapixels chacune et d’une puce A13 comprenant un accélérateur IA. L’iPhone 11 pro est présenté comme une caméra avant tout:

Google est moins avancé en matière de caméra intégrée dans le smartphone incliné culturellement à faire le travail avec du software plutôt qu’avec du hardware. Cependant le Pixel 4, le dernier né de la gamme a deux caméras. Google investit également beaucoup dans la reconnaissance vocale (BERT). 10% des recherches sont maintenant vocales. L’idée directrice est que la valeur ajoutée doit se produire entre le hardware (smartphone, Echo, Watch, Google Home, etc.) et le cloud, la zone que les GAFA contrôlent. Le hardware est donc équipé de senseurs qui captent le monde physique, de puces et logiciels qui exécutent le travail facile et renvoient le plus difficile dans le cloud. Ce qui intéresse les GAFA est de jouer sur leur force qui est leur parc de serveurs, leurs puces et leurs logiciels: il veulent constituer le cerveau du monde physique, par lequel toute l’information est traitée et sécurisée. Cette façon de voir leur fait négliger les derniers mètres, l’accès au monde physique. Ils mettent tout leur effort entre le terminal intelligent et le cloud super-intelligent, sécurisant le transport entre les deux: Facebook emploie 35 000 personnes dans la sécurité de son réseau par exemple. Or pour réellement accéder au monde physique, on a besoin de ces derniers mètres. Les géants de l’internet se contentent du Bluetooth, du wifi ou de la norme NFC, du QR code, au pire de la caméra car ce qui les intéresse commence au terminal intelligent. Et c’est peut-être par les derniers mètres que la révolution va arriver, ces derniers mètres autant négligés qu’importants.

Les failles des derniers mètres

Il y a à mon sens deux failles principales des modes de communication existants pour les derniers mètres:

L’énergie consommée est trop importante par rapport au travail effectué. Il y a trop d’entropie, de déperdition de signal à la fois dans le Bluetooth et le wifi. Cela implique que le Bluetooth/wifi nécessite de la batterie rechargeable qui alourdit les objets. Le Bluetooth et le wifi ne peuvent envahir le monde des objets, seulement certains, bien spécifiques. Le travail de recharge serait beaucoup trop fastidieux, coûteux, et de nombreux objets perdraient de leur esthétique et de leur fonctionnalité. Ces deux protocoles ne peuvent être la solution pour l’internet des objets, par conséquent, la 5G qui fonctionne sur des protocoles voisins non plus.

La connexion du dernier décamètre mètre n’est pas sécurisée. Il y a donc un point d’entrée pour le piratage de l’ensemble de l’information. Combien même l’information serait complètement sécurisée dans les tuyaux, entre le smartphone et le cloud, si elle ne l’est ni à l’entrée, ni à la sortie, il y a un problème. La communication des derniers mètres est cryptée mais pour réaliser des économies d’énergie (nécessaire dans les petits objets), le cryptage est léger, les possibilités de piratage multiples. La norme NFC est efficace certes mais sur le dernier centimètre, ce qui est nettement insuffisant.

Compte tenu de ses contraintes, les GAFA essaient de contourner le problème en développant dans le hardware des capteurs intelligents, des caméras ou systèmes de reconnaissance vocale censés percevoir le monde physique autour d’eux. Mais de tels systèmes d’interprétation demandent beaucoup d’énergie, de puces complexes (du GPU à l’accélérateur IA), ainsi que du logiciel, pour une précision finalement approximative. On ne résout que partiellement le problème de la consommation énergétique (elle est transférée des objets au terminal intelligent). Et surtout, on ne libère pas l’information la plus exclusive de chaque objet: sa localisation.

L’Ultra-large bande est la clé

L’ultra-large bande (UWB) résout les deux problèmes à la fois: consommation énergétique et sécurité. Il permet la libération complète de l’information qui va pouvoir circuler en tout point du monde physique sans corruption et à faible coût. La question sera alors de déterminer qui va contrôler cette information. L’UWB résout le problème de la localisation précise de l’objet, l’information la plus importante qu’il renferme. Un peu de technique: pour mesurer la localisation d’un objet par onde radio, il faut mesurer le temps que l’onde met pour parcourir la distance entre l’émetteur et le récepteur. Sachant que l’onde se meut à la vitesse de la lumière, le calcul de la distance est alors aisé. Le problème est de repérer le timing de départ de l’onde, ce qui est extrêmement difficile. Le principe d’incertitude d’Heisenberg stipule qu’il est impossible de connaître à la fois la fréquence et le timing d’un signal. Or la fréquence est plus facile à déterminer. Par triangulation de différentes fréquences on peut arriver à mesurer la distance mais il faut pour être précis travailler sur une bande de fréquence très large. Le wifi ou Bluetooth avec une largeur de bande de 20 MHz apporte une précision inférieure au mètre. L’UWB envoie des impulsions sur une largeur de bande de 500 MHz, obtenant une précision au cm:

Pour simplifier, l’UWB est un LIDAR de poche. Et la beauté du dispositif UWB est que les impulsions sont très légères, consomment très peu d’énergie et ne produisent que peu d’interférences sur les bandes de fréquences attribuées par le régulateur. De ce fait ce dernier n’hésite pas à attribuer un spectre très large au protocole UWB. Le wifi et le Bluetooth notamment produisent des signaux beaucoup plus bruyants et sont donc contraints en bande passante: c’est la grosse cavalerie. Avec l’UWB, les objets peuvent être localisés précisément et sans calcul algorithmique complexe ! La localisation est la signature de l’objet, qui peut alors converser de manière sécurisée (en plus de la signature, les impulsions multiples sont très difficiles à pirater) et économique avec son environnement. La vitesse de passage est en plus décuplée par rapport au Bluetooth ! Résumons les trois avantages de l’UWB:

il est très rapide (10 fois le Bluetooth sur une portée de 10 mètres, soit 480 mbps)

Il consomme très peu d’énergie

Il envoie et reçoit des messages super-sécurisés (preuve de l’envoi ou réception par la localisation, piratage quasi-impossible)

Le protocole peut donc s’étendre comme une traînée de poudre dans le monde des objets.

Apple prend le leadership

Jusqu’à la Keynote d’Apple en septembre annonçant l’intégration de sa puce UWB dans l’iPhone 11, ce protocole était surtout utilisé en matière industrielle pour des applications très spécifiques de géolocalisation précise. La technologie est très ancienne et a été approuvée par l’autorité des télécommunications américaine (la FCC) dès 2002. Cependant, un désaccord sur les standards a empêché son adoption alors que le Bluetooth plus consensuel faisait son chemin. Aujourd’hui encore, deux groupes d’industrie revendiquent le standard: l’UWB alliance créée en 2018 et le FiRa Consortium formé en août 2019. Les partis peuvent guerroyer longtemps, mais Apple qui n’est membre ni de l’un ni de l’autre a décidé de les départager en avançant sur son propre standard. Apple a aujourd’hui un tel écosystème (1,5 milliards d’appareils) qu’il peut aisément faire cavalier seul et doubler les autres, d’autant plus s’ils se disputent. Apple va donc lancer la révolution avec une nette longueur d’avance. Pourra-t-il la contenir ?

On peut imaginer les applications les plus immédiates qui seront déployées par Apple pour renforcer encore son écosystème: suppression définitive des câbles sur le Mac, paiement à distance (Watch et iPhone), lunettes AR esthétiques (plus besoin d’une caméra Bluetooth encombrante grâce au LIDAR de poche UWB)., ouverture de portes sans clé, etc. Les AirTags d’Apple permettront de réaliser facilement des plans d’architecte, de retrouver un objet, peut être d’éviter la noyade d’un enfant et de secourir rapidement un vieillard qui tombe, etc. Au delà de ces quelques services, il faut bien voir les enjeux: le sens de l’histoire est la digitalisation du monde physique. Chaque courbe en S décrite plus haut est fondée sur une digitalisation plus poussée de celui-ci. Avec le smartphone, une étape considérable a été franchie: l’ordinateur sort du laboratoire pour aller dans tous les logements puis enfin partout dans le monde. Maintenant, l’ordinateur va sortir de notre poche pour imprégner tout le monde physique. La digitalisation du dernier décamètre est ce qui pourrait créer une nouvelle courbe en S, peut-être la dernière selon l’analyse de Ben Thompson.

Comment les GAFA pourraient se faire déplacer

C’est un peu de la science fiction mais analysons le phénomène UWB avec le prisme de la loi de conservation des profits attractifs vue dans mon article sur la voiture autonome :

La loi de conservation des profits attractifs, énoncée par Clayton Christensens (un grand penseur de l’innovation décédé la semaine dernière) est bien utile dans ce type d’analyse. Elle stipule que dans une chaîne de production, le profit se concentre sur la tâche qui n’est pas suffisamment bien remplie aux yeux des consommateurs, le reste des tâches étant modularisées. Elle stipule également que quand la tâche qui concentrait le profit devient suffisamment remplie aux yeux du consommateur, le profit se déplace à un nouvel endroit de la chaîne où la satisfaction du consommateur est insuffisante. Cette loi est particulièrement adaptée aux secteurs qui évoluent vite comme la technologie. Dans l’industrie du PC, pendant des années, le problème était le cerveau de l’ordinateur (Microsoft+ Intel), le reste des pièces étant relativement facile à faire et collant à la demande (disque dur, unité centrale, etc.). Puis quand la demande s’est déplacée sur le smartphone, ce qui ne collait pas était l’expérience utilisateur nécessitant une intégration de toutes les pièces et software dans un petit espace, le cerveau était amplement suffisant, d’où Apple. Le corollaire de cette loi est l’intégration de toutes les pièces nécessaires pour accomplir la tâche qui ne satisfait pas la demande. Pourquoi ? Tout simplement parce que ces pièces doivent être améliorées en fonction des feedbacks utilisateurs et que l’intégration facilite la vitesse de réponse au feedback.

Et si la partie à améliorer maintenant était la connexion du dernier décamètre, la norme UWB permettant de faire des progrès de géant dans les applications liées au monde physique ? La pièce essentielle de la connexion du dernier décamètre est la sécurité car la localisation est exclusive à chaque objet, personne du monde physique à l’instant t. De même qu’un bitcoin est unique et ne peut être envoyé à deux endroits à la fois, un objet est unique dans sa localisation et ne peut être contrefait. De même que la sécurité du bitcoin est décentralisée, la sécurité de la connexion du dernier décamètre repose sur des LIDAR de poche bon marché construits sur une norme ouverte, l’UWB, pas sur des algorithmes complexes gérés par les GAFA. Si le dernier décamètre devient le point de passage obligé pour la sécurité de l’ensemble de l’internet (preuve par le positionnement), de multiples applications pourront se construire dessus, modularisant les opérateurs cloud devenus interchangeables. Dans l’industrie des télécommunications, la valeur s’est concentrée sur les opérateurs locaux au détriment des opérateurs longue distance: le local prime. Les baby bells ont détrôné AT&T. Il faut avoir en tête que 50% des données seront créées pat les objets connectés d’ici 2025 (source Intel). La décentralisation du dernier décamètre pourrait prévaloir sur la centralisation de l’internet. Autant le bitcoin a échoué car il n’a pas su se greffer sur des applications utiles, autant l’UWB pourrait prendre en raison de nombreuses applications possibles fondées sur la localisation. Le bitcoin a rêvé de rendre l’information à ses propriétaires, l’UWB pourra peut être réaliser ce rêve.

Bien entendu, il faut compter sur la résistance des GAFA face à ce bouleversement possible. Pour contrer, il leur faut diviser, empêcher l’émergence d’un protocole standard UWB. Apple l’a bien compris et fait cavalier seul, voulant contrôler complètement son écosystème. Une brèche comme celle de l’UWB pourrait être fatale, un retour au temps où l’internet était décentralisé, l’internet des sites web et des mails comme moyen de communication. Il sera intéressant de suivre comment Google, Facebook et Amazon vont essayer de se positionner sur la question. Qui va créer le standard complémentaire d’Apple. afin d’éliminer totalement la possibilité d’un standard commun…Déjà Facebook anticipe…Cliquez ici !

Bonne fin de semaine,

Hervé