Où sont les produits ?

Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Entretien entre Nat Friedman, Daniel Gross et Ben Thompson, le 13/06/2024:

NF : Ben et moi sommes âgés, et nous avons donc tous les deux l'habitude de porter des bagages à la main dans les aéroports. À un moment donné, quelqu'un s'est dit : "Pourquoi ne pas simplement mettre des roues sur ces choses ? Les roues existaient, nous avions des rollers, des skateboards, mais personne n'y avait pensé pour une raison ou une autre.

BT : C'est à la fois encourageant et déprimant.

NF : Oui, nous attendons la valise à roulettes de l'IA.

On assiste aujourd’hui à une course au LLM le plus performant. Les grands protagonistes sont peu ou prou à égalité sur les performances ( ChatGPT, Gemini. Anthropic, Llama, bientôt X AI…). Pour faire la différence, il faut pouvoir créer un modèle 30% meilleur et non pas seulement 0,3% meilleur comme l’indique Jensen Huang, CEO de Nvidia…et le sortir avant les autres pour espérer gagner des utilisateurs. Dès lors, la solution est d’investir dans des clusters GPUs géants (l’équivalent de 100 000 H100 de Nvidia, au lieu de 20 000 aujourd’hui pour les datacenters les plus équipés). Ces investissements sans précédents dans les centres de données entraînent une pénurie de puces Nvidia (Microsoft est contraint d’utiliser les GPUs d’Oracle !) et un retard sur la sortie des modèles de langage les plus efficaces. Coût et retard sont les deux mamelles de l’IA générale…GPT 5 est maintenant attendu fin 2025, début 2026. CCN, le 21 juin 2024:

Interrogé sur le calendrier de lancement, Mira Murati a indiqué que GPT-5 pourrait être lancé à la fin de l'année 2025 ou au début de l'année 2026. Il s'agit d'un changement par rapport aux rumeurs précédentes qui suggéraient un lancement dès la fin de l'année 2023, avant d'être ramenées à l'été 2024.

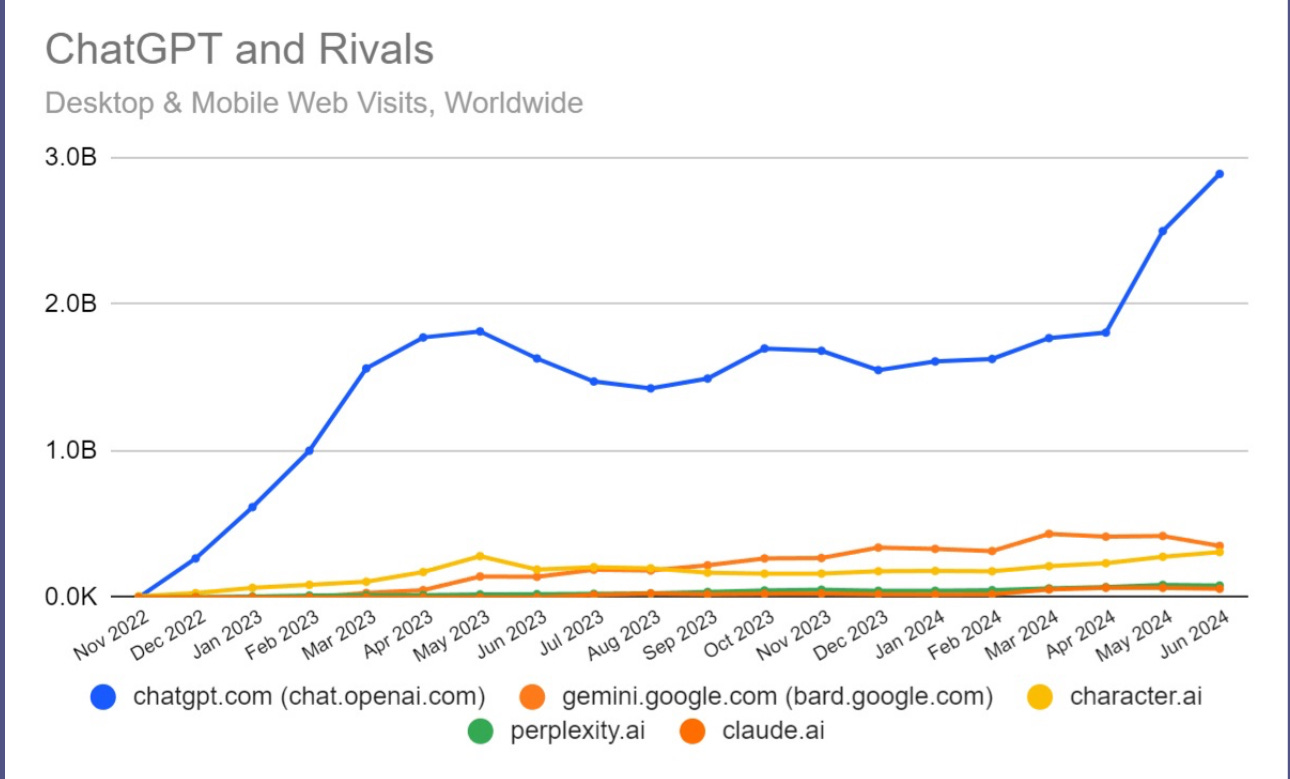

Jusqu’à aujourd’hui ces LLMs sont restés essentiellement des expérimentations de laboratoire, pas forcément très exploitables du fait de leur taux d’hallucinations. Seul OpenAI est sorti du lot avec un produit (ChatGPT) réalisant un chiffre d’affaires annualisé de $3,4 milliards et dominant l’audience:

Source BDM

Aussi impressionnants que ces LLMs paraissent, la question est maintenant de savoir quels problèmes ils cherchent à résoudre. Alex Wang, CEO de Scale AI résume bien la problématique en ces termes:

J'ai très vite réalisé que la sélection des problèmes, ce sur quoi vous choisissez de travailler, a dix fois plus d'effet sur votre impact final que la façon dont vous résolvez un problème individuel. J'ai été obsédé par cette idée : "Oh, il faut être en général très bon dans la sélection des problèmes, et c'est en fait ce qui détermine l'impact que l'on aura au bout du compte".

Robert Plath, pilote de Northwest Airlines a sélectionné son problème à résoudre: comment réduire la débauche d’énergie déployée pour transporter les bagages ? Il a pensé pour le résoudre aux petites roues placées à la verticale des valises et à la poignée télescopique. Le « Rollaboard » était inventé…Les différents éléments coexistaient déjà depuis longtemps, l’invention était dans l’assemblage. Depuis 1987, date de cette trouvaille, on voyage différemment.

Combien de temps va pouvoir continuer la course au modèle si on ne cherche pas les problèmes à résoudre, préférant opter pour la machine qui résout tous les problèmes ?

L’effet Osborne

Le chiffre d’affaires généré aujourd’hui par les modèles (un bon proxy des produits existants) est relativement faible: en plus des $3,4 milliards de ChatGPT, on peut estimer Copilot à $1 milliard (source The Information); Anthropic fin 2023 visait un chiffre d’affaires annualisé de $850 millions en décembre 2024, il reste donc en dessous de Microsoft aujourd’hui. Une estimation haut de fourchette du chiffre d’affaires annualisé global généré par les modèles serait de $5 milliards. Il faut rapporter ce chiffre aux $50 milliards d’investissements en infrastructures supplémentaires réalisés par les hyper scalers en 2024…auxquels s’ajoutent tous les autres (Mistral, Cohere, etc.). Ces investissements sont exorbitants pour au moins deux raisons:

Les marges brutes sur un produit à base de LLM ne sont pas celles d’un logiciel (compter 50% plutôt que 80%), en raison de la consommation en GPUs pour l’inférence.

Le taux de dépréciation du modèle est bien plus élevé que celui d’un logiciel. Il faut entraîner un nouveau modèle tous les ans…juste pour rester dans la course…les versions anciennes du modèle étant vite dépassées.

Il y a un troisième élément contre lequel les développeurs de modèles doivent lutter: l’effet Osborne qui pourrait retarder la croissance des nouveaux utilisateurs. D’après Wikipedia :

L'effet Osborne est un phénomène social qui consiste, pour les clients, à annuler ou à reporter les commandes du produit actuel, qui sera bientôt obsolète, en raison d'un inconvénient inattendu lié à l'annonce prématurée d'un futur produit par l'entreprise. Il s'agit d'un exemple de cannibalisation. Le terme fait référence à la société Osborne Computer Corporation, dont le deuxième produit n'est devenu disponible que plus d'un an après son annonce. La faillite de l'entreprise a été largement attribuée à la baisse des ventes après l'annonce.

Si l’on nous promet monts et merveilles sur un futur modèle, pourquoi ne pas l’attendre avant d’adopter une version payante ? D’après Mira Murati, GPT-5 aura l’intelligence d’un Ph.D, dépassant largement le niveau de GPT-4, proche de celui d’un lycéen. Pourquoi ne pas surfer en attendant avec les modèles gratuits tels que Llama 3 ou Gemini qui peu ou prou valent GPT-4 ? Pour éviter l’effet Osborne et faire patienter les utilisateurs, Les concepteurs de modèles apprennent à maîtriser l’art de la Keynote, présentant leurs modèles intermédiaires de manière extrêmement avantageuse. À défaut de bataille technique, on a une bataille oratoire. Les produits réels tardent à sortir et ne correspondent pas vraiment à l’image qu’on en a donnée. La démonstration ChatGPT-o du 14 mai dernier était brillante, la voix de l’IA répondant instantanément aux sollicitations avec les bonnes intonations. La sortie de cette fonctionnalité du modèle annoncée en grande pompe est maintenant retardée discrètement. D’après WinBuzzer le 26 juin 2024:

OpenAI a reporté la sortie prévue d'un assistant vocal GPT-4o pour ChatGPT, appelé "mode vocal avancé". Ce délai supplémentaire sera mis à profit pour effectuer des contrôles de sécurité et de performance plus poussés. Initialement, la nouvelle fonctionnalité devait être lancée pour les abonnés de ChatGPT Plus à la fin du mois de juin, mais cette date a été repoussée d'au moins un mois.

Au moins un mois est un euphémisme. Viser la fin de 2024 paraît plus réaliste. Il est probable qu’alors, l’interactivité ne sera pas sensationnelle en raison d’une latence qui sera loin de la démonstration produite le 14 mai. La surenchère verbale est une stratégie visant à gagner la bataille de l’attention et ainsi éviter l’effet Osborne: « abonnez vous, le produit va évoluer de manière imminente et vous avez droit à ces évolutions»

OpenAI ou Anthropic, des créateurs de modèles indépendants sont les plus menacés par l’effet Osborne car ils doivent gagner les utilisateurs. Les hyper scalers les ont déjà et l’IA générative n’est qu’une corde de plus à leur arc. Ils peuvent ainsi se contenter de suivre le rythme des indépendants en faisant levier sur leur base d’utilisateurs, leur infrastructure et leurs données. Les indépendants impriment le rythme de la course et sont les plus vulnérables à l’effet Osborne. Sam Altman l’a compris et parle maintenant d’une évolution permanente du modèle au lieu de sauts de générations. C’est probablement une arme plus redoutable que la Keynote pour éviter le désintérêt des utilisateurs pour la génération actuelle. Une technique que Sam Altman a également employée est de suspendre (temporairement) les souscriptions. C’est un moyen de créer un effet rareté qui dissuade les utilisateurs de se désabonner et fait monter la crainte de manquer le train.

Toutes ces stratégies visent à faire patienter et monter le désir de l’outil universel- un outil qui serait bien plus fort que le smartphone, reléguant ce dernier au rang d’un faire valoir- Quand on considère le succès du smartphone et son milliard et demi de ventes chaque année, on imagine bien la motivation pour créer un couteau suisse 🇨🇭 encore supérieur. Ce pari nécessite de mobiliser des ressources considérables en puissance de calcul, algorithmes et données…sur le long terme…avec un résultat encore hypothétique. Est-il prudent de tout miser sur cet objectif… et d’en oublier les problèmes qui pourraient être résolus avec les modèles fonctionnant aujourd’hui, même s’ils ne sont pas les plus performants ? N’est-il pas temps d’inventer la valise à roulette de l’IA ?

L’exemple Apple Intelligence

Apple prend le contrepied de la tendance actuelle, estimant que son iPhone est la forme définitive du couteau suisse 🇨🇭 , l’IA générative en étant un faire valoir plutôt qu’un substitut potentiel. Il cherche concrètement à rendre plus facile l’utilisation des applications Apple logées sur iOS, de manière à ce qu’elles répondent plus directement à nos demandes. L’idée est de simplifier la navigation pour arriver plus vite à son objectif, qu’il soit une information et/ou une décision (par exemple chercher dans les mails un rendez vous et réserver un Uber au bon moment). Pour ce faire, il n’est nul besoin de recourir à un modèle de langage sophistiqué car les actions possibles sur les applications Apple sont relativement limitées. Il faut surtout avoir les données sur l’utilisateur (sa mémoire) et un petit modèle (3 milliards de paramètres) qui accède à l’index des données de l’utilisateur par la technique RAG (Retrieval And Generate). Le modèle est logé sur l’iPhone, ce qui est particulièrement économique pour Apple: l’utilisateur paie par l’énergie qu’il consomme à faire tourner la puce de l’iPhone. Les requêtes un peu plus complexes seront balancées sur des serveurs Apple dotés de puces Apple. Enfin, les requêtes d’ordre général seront traitées par un LLM type ChatGPT (premier candidat) ou Gemini, ces derniers payant les requêtes contre le privilège d’être distribués et avoir la chance d’acquérir de nouveaux utilisateurs payant.

Apple crée ainsi un vrai produit non reproductible (base de données unique propriétaire sur chaque utilisateur) qui peut lui faire vendre plus d’iPhones. Il évite la course coûteuse et hasardeuse au LLM, estimant que les coureurs se battront pour avoir une position privilégiée sur l’iPhone. Apple a juste mis des roues à son hardware…

Quand Apple crée un produit, il donne une forte tendance: iPods, iPhone, iPad, Apple Watch et maintenant Apple Intelligence. Ces produits deviennent dominants dans les populations aisées et servent de base pour développer un écosystème créatif. Il convient donc d’être particulièrement attentif à Apple Intelligence.

Quel type de produit ?

Dans l’exemple d’Apple, l’IA ne remplace pas le produit existant, elle en facilite l’utilisation. Elle réduit la quantité de travail nécessaire pour faire fonctionner le produit. Le fantasme aujourd’hui autour de l’IA générative est qu’elle va tout remplacer du fait de ses capacités infinies (à venir). Restons pragmatiques: l’informatique actuelle automatise un grand nombre de tâches de manière efficace. La nécessité d’économies d’échelle a entraîné une spécialisation des fonctions à l’échelle mondiale (cloud). Les applications (produit final) font le job à faible coût marginal. La programmation est largement déterministe, non pas probabiliste, ce qui réduit le taux d’erreur. Les deux avantages de l’informatique d’aujourd’hui sont:

un coût bas et qui diminue avec le volume (coût marginal zéro)

un degré de précision élevé (CPUs au lieu de GPUs)

Pourquoi remplacer les programmes actuels par des programmes IA qui auront un coût marginal élevé (du fait de la consommation de GPUs) et un taux d’erreur significatif (hallucinations) ? Le plus simple et moins risqué est de rajouter des roues à la valise, de rendre encore moins cher l’utilisation des programmes actuels, de leur mise en place jusqu’à la maintenance. Il faut non pas remplacer les programmes mais les tâches qui sont juxtaposées aux programmes et demandent une intervention humaine. Le potentiel de gains de productivité est alors très conséquent. C’est ce qu’explique Aaron Levie, CEO de Box:

En ce moment, le modèle économique dominant dans les SaaS est basé sur le nombre de sièges, ce qui signifie inévitablement que le nombre total de sièges que vous pouvez vendre est limité au nombre d'employés dans l'organisation qui sont pertinents pour votre logiciel particulier. Le logiciel juridique est en gros limité par la taille de l'équipe juridique, le logiciel d'audit est limité par la taille de l'équipe d'audit, et ainsi de suite. Cela implique que le client doit généralement *déjà* avoir non seulement un besoin pour votre solution, mais aussi l'effectif existant dans l'organisation pour devenir des utilisateurs de votre logiciel. Incidemment, c'est souvent pourquoi tant de produits SaaS tendent à viser les catégories de productivité horizontale, car cela maximise le nombre d'utilisateurs potentiels auxquels vous avez accès dans une organisation.

L'IA renverse cette logique, notamment avec la puissance des agents IA, et vous obtenez une nouvelle forme de "résultat en tant que service". Lorsque l'IA fait réellement le travail au sein du logiciel lui-même, vous n'êtes plus contraint par le nombre d'employés dans l'organisation pour utiliser le logiciel. Le logiciel apporte littéralement le travail avec lui et délivre un résultat commercial particulier. Il est clair que le plein potentiel de cette situation n'est pas encore pleinement compris, car cela représente une transformation massive de l'industrie des logiciels.

Lorsque vous n'êtes plus limité par la taille d'une équipe ou d'un département pour utiliser votre logiciel, les marchés ne sont plus arbitrairement plafonnés en taille. Dans cette nouvelle ère, le logiciel qui alimente un flux de travail juridique apporte en réalité l'équivalent d'un travail de connaissance juridique, et le logiciel pour les audits apporte l'équivalent d'un travail d'audit. Tout d'un coup, les petites entreprises, les équipes sous-dotées dans les grandes entreprises, et toutes les nouvelles géographies commencent à s'ouvrir en tant que marchés. L'IA permettra à des catégories de logiciels autrement de niche de devenir beaucoup plus grandes, et à des catégories de logiciels déjà grandes de devenir encore plus importantes.

Apple montre la voie de ce qu’est un réel produit IA et ébauche la plate-forme sur laquelle ces futurs produits IA pourraient être développés, créant un nouvel écosystème.

La mise en place des plateformes

À partir du moment où des millions d’applications fonctionnent sur IOS, Android ou Windows, il est légitime que ces plateformes de développement prennent un nouvel essor pour aider à la création de produits IA, la plupart liés aux applications existantes. Une abstraction au niveau de la plateforme sera moins coûteuse, plus souple et plus facile à gérer qu’une abstraction au niveau du modèle à tout faire probablement sur-dimensionné. C’est pourquoi les plateformes ont des chances de gagner les développeurs. L’Europe sera l’exception.

L’exception européenne

D’après 9to5Mac, le 28 juin 2024:

Apple a prévenu qu'il ne déploierait pas en Europe les nouvelles fonctionnalités d'intelligence artificielle de l'iPhone lorsqu'elles seront lancées ailleurs cette année, invoquant des "incertitudes" découlant des nouvelles règles de concurrence de Bruxelles [...].

Apple a déclaré vendredi : "En raison des incertitudes réglementaires engendrées par la loi sur les marchés numériques, nous ne pensons pas être en mesure de déployer trois de ces [nouvelles] fonctionnalités - iPhone Mirroring, SharePlay Screen Sharing et Apple Intelligence - auprès de nos utilisateurs européens cette année."

La commission européenne a frappé fort en imposant des conditions drastiques au lancement d’Apple Intelligence en Europe. Cette dernière rêve d’un monde modulaire où les pièces de technologie se branchent entre elles comme du lego sans intégration possible, notamment avec les données. Clayton Christensen a bien montré pourtant que l’innovation en technologie passe d’abord par l’intégration. c’est là où se font les profits dans une chaîne de valeur. En refusant cette étape, l’Europe se détourne en fait de l’innovation. Apple ne va pas changer son modèle économique pour les beaux yeux de l’Union Européenne qui ne représente plus que 7% de son chiffre d’affaires (combien de sa profitabilité après amendes potentielles ?) La conséquence inévitable est que l’innovation se produira ailleurs et ce d’autant que des amendes considérables menacent les intégrateurs. Mieux vaut pour eux introduire les versions minimales en Europe et se concentrer sur les zones rentables.

Le pire est que l’Europe semble très fière qu’Apple ait renoncé au lancement de son produit IA comme si c’était une victoire pour l’innovation… Les développeurs européens seront en fait privés de la plateforme Apple Intelligence pour créer leurs applications IA et devront laisser place à des développeurs extérieurs à l’Europe, à moins de déménager. Le déclassement technologique de l’Europe s’accentue, ce qui n’empêche la technocratie normative de rester droit dans ses bottes…Souhaitons que le même sort ne soit pas réservé aux autres créateurs de plateformes comme Microsoft ou Google, mais rien n’est moins sûr car le DMA (Digital Market Act) veille au grain…Avant Apple, il a déjà frappé Meta qui a décidé de retarder ad nutum le lancement de son IA en Europe. Et maintenant Microsoft est menacé d’une amende de 10% de son chiffre d’affaires mondial pour avoir intégré Teams dans son offre Microsoft 365…Plus généralement, on pourrait imaginer une Union Européenne sans Big Tech. Le calcul est simple: chacun est menacé d’une amende de 10% de son chiffre d’affaires mondial alors que son chiffre d’affaires dans l’Union en représente moins de 10%.…ce n’est guère motivant.

Le reste du monde…

En attendant, l’innovation avec ou sans l’Europe va se produire grâce à ces grandes plateformes qui alignent hardware, systèmes d’exploitation et audience, peuvent apporter de la stabilité aux développeurs sans tomber dans la dépendance coûteuse de Nvidia :

La plateforme Apple Intelligence: dans iOS et avec l’aide d’un NPU performant, Apple orchestre l’utilisation du modèle local, du modèle logé dans son petit cloud et des larges modèles type ChatGPT avec lesquels il aura passé un accord. Il conçoit d’abord ses propres programmes d’IA (par exemple Siri) comme support de ses applications (mail, calendrier, plan, etc.). Dans un deuxième temps, Apple Intelligence s’ouvrira à des développeurs extérieurs qui s’appuieront dessus pour créer leurs propres applications IA. C’est un classique chez les Big Tech: commencer par soi même et puis étendre le concept (Amazon avec sa place de marché, Google avec le cloud, etc.)

Microsoft suit le même playbook qu’Apple, sa plate-forme étant Windows Copilot (associée au PC). Il s’appuie sur les mêmes éléments qu’Apple: un petit modèle fonctionnant en local sur un PC délivrant au moins 45 TOPS, un index sémantique constitué de toutes les données relatives à l’utilisateur logées dans les applications Microsoft, enfin un LLM. Windows alors orchestre entre les modèles en fonction des demandes de l’utilisateur. Avec l’AI, Windows qui était jusqu’alors aux oubliettes reprend du poil de la bête. Satya Nadella veut dès le départ une plateforme plus ouverte aux développeurs que ne l’est Apple Intelligence. Dans sa Keynote du 21 mai, Microsoft a déjà introduit des partenaires développeurs tels qu’Adobe, DaVinci Résolve Studio ou CapCut. En rachetant GitHub en 2018, Microsoft s’était rapproché des développeurs. Il cherche à transformer son avantage vis à vis d’un Apple de moins en moins populaire au sein de la profession des développeurs.

Google prévoit sa Keynote pour le 13 août. Il présentera son dernier smartphone, le Pixel 9. Il faut s’attendre à ce qu’y soit dévoilée une plateforme de développement Android IA constituée du Pixel, de Gemini nano pour les fonctions locales et Gemini Pro/ Ultra pour les interactions avec le cloud. A La difference d’Apple, Google peut jouer sur les deux tableaux: 1/ les produits spécialisés (roulettes pour les valises) conçus sur Android par lui même ou des développeurs tiers, 2/ l’intelligence générale, le produit qui résout tous les problèmes.

À la rentrée, les trois grandes plateformes iOS+ Apple Intelligence, Windows+ Copilot et Android+Gemini seront en place pour accueillir les développeurs à la recherche de valises à roulettes de l’IA. On a beaucoup parlé de Nvidia qui reste la voie royale pour construire les autoroutes de l’IA. Mais tout un écosystème local va se créer (NPUs, PC, smartphones, modèles nano…) pour que l’IA puisse se développer dans des produits concrets, pour résoudre des problèmes concrets.

Bonne semaine,

Hervé