Quantique: révolution ou pétard mouillé ?

Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Je m’intéresse aujourd’hui aux enjeux économiques de l’informatique quantique.

Steve Cheney est connu pour ses déclarations fracassantes, c’est après tout la recette pour collectionner les abonnés sur Twitter, mais il y là a un point intéressant à creuser. La Silicon Valley ne se serait-elle pas enfermée dans la bulle du silicium, entrainant tout l’écosystème high tech à sa suite ? Le sous-jacent à toutes les innovations tech, du transistor à la dernière application mobile révolutionnaire est le codage et stockage de l’information en 0 et 1. Cette technologie est tenue pour acquise, la preuve en étant les valorisations pharamineuses du secteur technologique. L’informatique quantique passe du traitement du bit à celui du qubit, de l’électron au photon. Le qubit est la plus petite unité de stockage quantique. Son traitement est tellement instable, nécessitant le plus souvent un environnement supraconducteur, que l’ordinateur quantique est relégué aux oubliettes, considéré comme l’innovation qui ne percera jamais ou dans un temps si lointain qu’on peut l’oublier et continuer à évoluer dans le monde du bit sans inquiétude…On se querelle sur la supériorité d’ARM sur X 86, de l’intérêt d’avoir son SOC plutôt que de sous-traiter à Nvidia. Et si la puce quantique mettait tout le monde d’accord reléguant toutes les innovations actuelles à la préhistoire technologique ?

Qu’est ce que l’ordinateur quantique ? J’ai trouvé un bon résumé dans le blog d’AWS qui a lancé un service quantique:

Les ordinateurs ordinaires (classiques) utilisent des collections de bits pour représenter leur état. Chaque bit est définitivement 0 ou 1, et le nombre d'états possibles est de 2n si vous avez n bits. Un bit peut être dans l'un des deux états, deux bits peuvent être dans l'un des quatre états, et ainsi de suite. Un ordinateur avec 1 Mio de mémoire a 2^(8*1048576) états, à l'exclusion des registres du CPU et du stockage externe. C'est un grand nombre, mais il est fini et peut être calculé.

Les ordinateurs quantiques utilisent une représentation de données plus sophistiquée appelée qubit ou bit quantique. Chaque qubit peut exister dans l'état 1 ou 0, mais aussi dans des superpositions de 1 et 0, ce qui signifie que le qubit occupe simultanément les deux états. Ces états peuvent être spécifiés par un vecteur bidimensionnel qui contient une paire de nombres complexes, ce qui donne un nombre infini d'états. Chacun des nombres complexes est une amplitude de probabilité, c'est-à-dire la probabilité que le qubit soit un 0 ou un 1, respectivement.

Un ordinateur classique peut se trouver dans un seul de ces 2n états à un moment donné, mais un ordinateur quantique peut les occuper tous en parallèle.

Pourquoi le quantique pourrait arriver plus tôt que prévu

Les modèles économiques sont alignés pour faire accélérer l’adoption du quantique. L’ordinateur quantique coûte très cher, nécessite un environnement très contrôlé (zéro absolu ou vide) et nécessite d’être amorti sur un nombre considérable de chercheurs/développeurs pour leur donner espoir de jackpot. Le cloud est idéal pour l’héberger, le maintenir et créer cette dynamique potentielle de profit pour les développeurs. Les opérateurs cloud prennent en charge le matériel des différents fournisseurs (comme ils le font aujourd’hui avec les serveurs et microprocesseurs) et donne les outils (pas encore d’OS) aux développeurs pour programmer selon la logique qubit. Les chercheurs/développeurs paient à l’usage. Où en sont les opérateurs cloud ? Amazon a ouvert au public Amazon Braket en août 2020:

Amazon Braket est un service d'informatique quantique entièrement géré qui aide les chercheurs et les développeurs à se lancer dans cette technologie pour accélérer la recherche et la découverte. Amazon Braket offre un environnement de développement qui vous permet d'explorer et de créer des algorithmes quantiques, de les tester sur des simulateurs de circuits quantiques et de les faire fonctionner sur différentes technologies de matériel quantique…Avec Amazon Braket, vous pouvez concevoir et créer vos propres algorithmes quantiques à partir de zéro ou choisir parmi un ensemble d'algorithmes existants. Une fois que vous avez créé votre algorithme, Amazon Braket vous propose un choix de simulateurs pour le tester, le dépanner et l'exécuter. Dès que vous êtes prêt, vous pouvez exécuter votre algorithme sur les ordinateurs quantiques de votre choix, y compris les redresseurs quantiques de D-Wave et les ordinateurs à porte de Rigetti et IonQ. Amazon Braket vous permet désormais d'évaluer le potentiel de l'informatique quantique pour votre organisation et de développer votre expertise.

Le service Amazon Braket est idéal pour créer un effet réseau: un coût d’entrée nul, une facturation à l’usage et un modèle open source favorisant la coopération de la communauté pour faire progresser les algorithmes quantiques. Les développements aujourd’hui sont assez ciblés, ce qui devrait permettre d’avancer plus vite. Voici le D-Wave 2000 Q, ordinateur quantique proposé par Amazon:

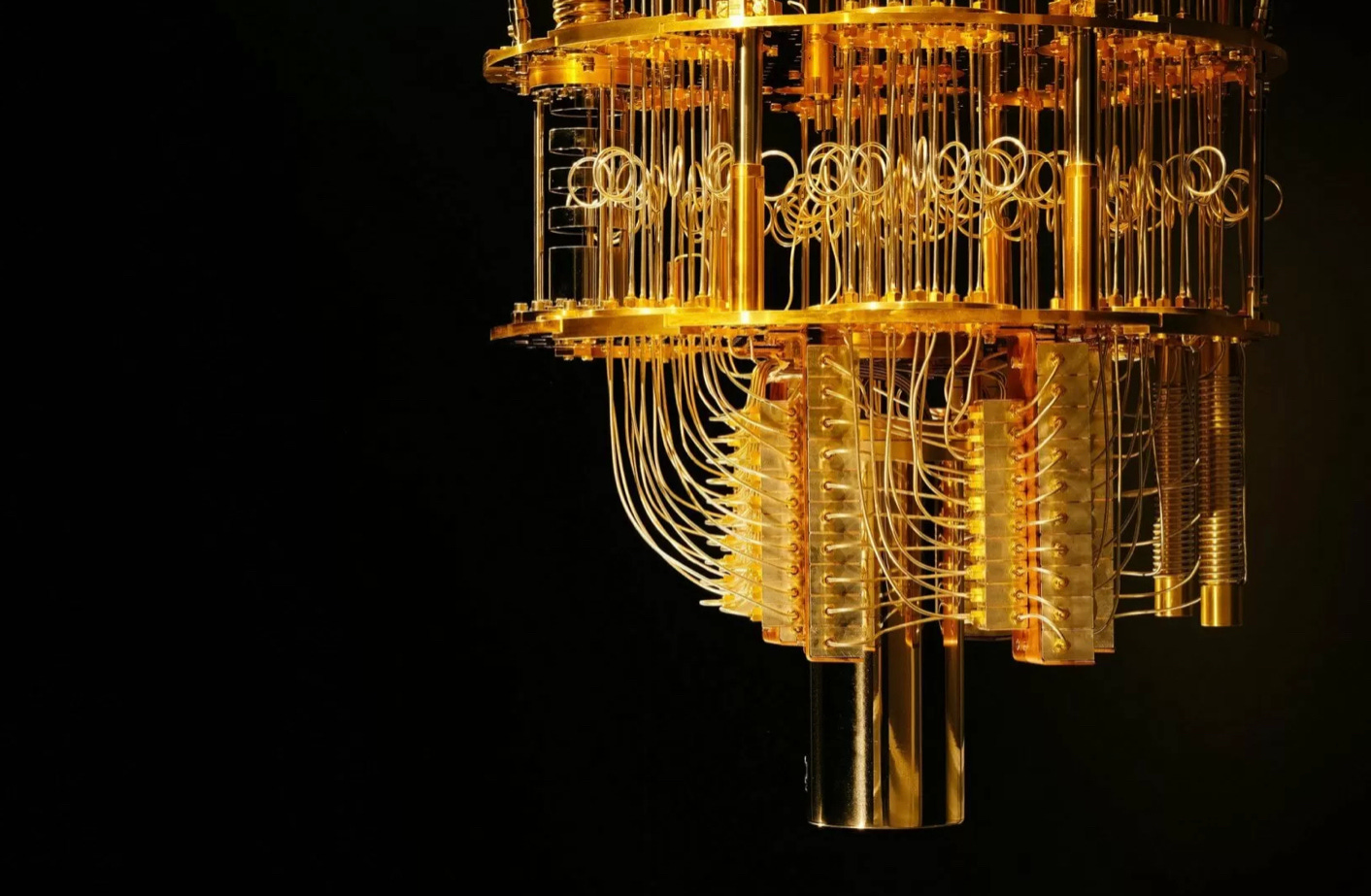

ainsi que l’ordinateur IonQ également proposé par Amazon Braket:

Amazon sous-traite l’ordinateur quantique (3 fournisseurs), l’achète et organise l’écosystème. C’est également la stratégie de Microsoft Azure qui travaille aussi avec IonQ et 4 autres fabricants d’ordinateurs quantiques. Microsoft met également en avant ses outils open source pour accélérer la programmation d’algorithmes quantiques. Azure Quantum a été ouvert en novembre 2019 et étendu au public le 1er février 2020; fidèle à la stratégie Microsoft, Azure Quantum est agnostique sur le hardware préférant se concentrer sur les outils et le langage (Q#) permettant de créer des programmes quantiques. Enfin Google a une stratégie différenciée par rapport à ses deux concurrents cloud: il intègre la fabrication de la puce quantique, le langage de programmation (Circ) et la recherche algorithmique, tout en mettant ses ressources en open source. C’est une stratégie typique de Google utilisée avec Chrome, WebRTC, Kubernetes, TenserFlow ou même Android: créer un standard de place open source mais le dominer en ayant une longueur d’avance sur l’expérience utilisateur.

Les ordinateurs quantiques de la génération actuelle ont en général une capacité de 50 qubits (72 qubits pour celui de Google, 65 pour IBM). C’est à la fois beaucoup parce qu’au dessus de 53 qubits (d’après Google), on atteint la suprématie quantique, c’est à dire l’impossibilité d’être égalé par un super calculateur classique, mais très peu parce que les qubits sont particulièrement instables et sujets à erreurs nombreuses. Le moyen pour corriger ces erreurs est de multiplier les qubits. Il faut plusieurs qubits pour corriger un qubit. D’après IBM Quantum:

Tout d'abord, et c'est peut-être notre plus grand défi, nous devons faire la démonstration de circuits quantiques efficaces et à correction d'erreurs. Nos meilleures théories prédisent que cela nécessiterait de construire des machines avec des dizaines de millions de qubits sur une seule puce refroidie. C'est un niveau peu pratique. Nous devrons concevoir conjointement des codes de correction d'erreurs avec des contraintes matérielles réelles et découvrir de nouvelles stratégies de correction d'erreurs pouvant être mises en œuvre plus efficacement, car même en faisant de notre mieux pour réduire l'empreinte de ces qubits, il s'agira d'un très gros processeur quantique. Il y a des raisons d'être optimiste, les travaux prometteurs en cours indiquant que nous serons en mesure de réduire le nombre de qubits nécessaires pour mettre en œuvre des codes de correction d'erreurs.

On imagine facilement le temps qu’il faudra pour produire des ordinateurs quantiques de millions de qubits de capacité: au moins 30 à 40 ans, comme le temps qui a séparé l’ENIAC des PC des années 90. En attendant, il faut faire avec, d’où l’importance du code et de toute technique qui permet de réduire le taux d’erreur. La réduction du taux d’erreur est la clé pour l’adoption du quantique; c’est là où les progrès sont les plus manifestes et pourraient accélérer l’adoption, au moins sur certaines fonctions

La réduction du taux d’erreurs

Elle passe certes par le code et les algorithmes qui permettront de mitiger l’impact des erreurs mais aussi par l’option hardware poursuivie. La combinaison des deux pourrait avoir un impact plus rapide que prévu.

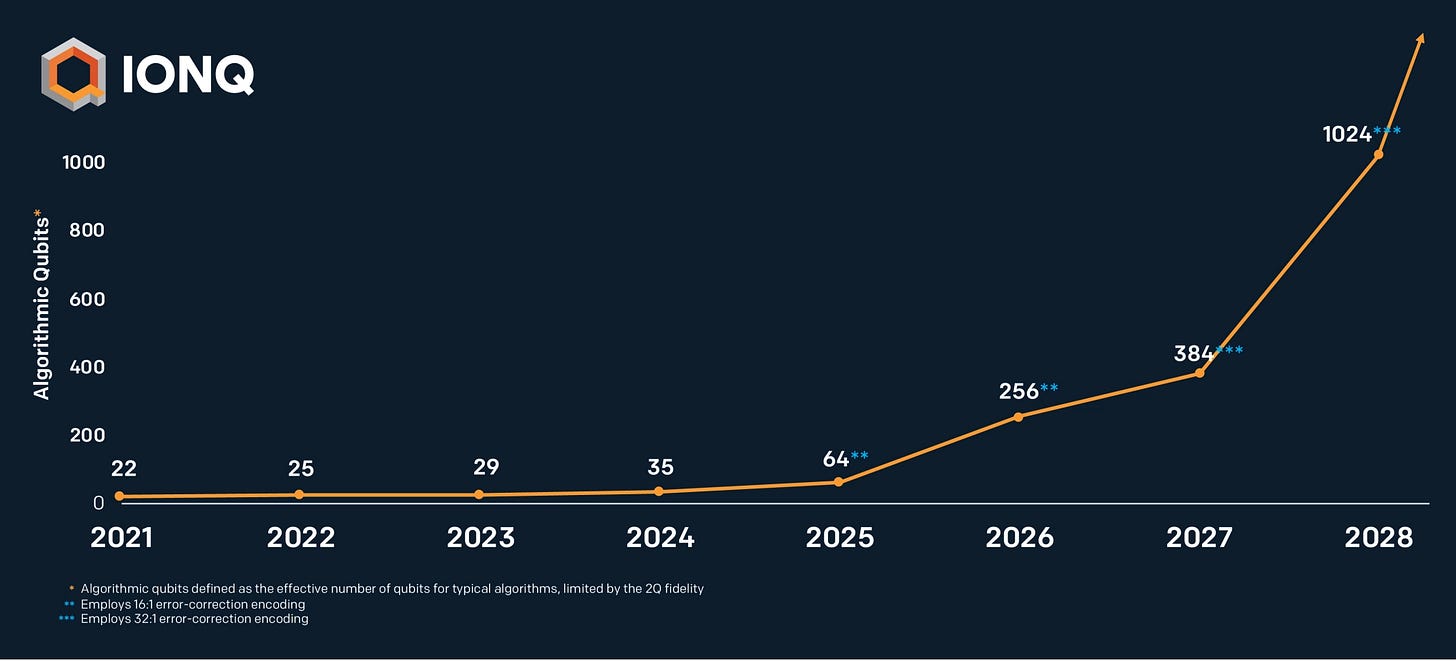

L’approche d’IBM, de Google ou d’Intel sur le matériel est de donner la priorité à l’augmentation de la capacité en qubits pour réduire les erreurs. Pour ce faire, ils utilisent la technologie des boucles supraconductrices qui permet de faciliter les mouvements de qubits et de corriger les erreurs rapidement quand elles se présentent. Leur logique est donc la traditionnelle loi de Moore. IonQ, Honeywell et d’autres ont choisi une autre voie qui est de piéger les ions dans un champ magnétique. Pour en savoir plus, je vous conseille cet article qui présente simplement les deux technologies. Les partisans du piège à ions prétendent que l’important est le qubit utile et non le qubit en tant que tel, qu’un ordinateur quantique à 32 qubits utiles est bien supérieur à un ordinateur quantiques à 50 qubits tournant en environnement supraconducteur. Honeywell a défini un nouveau benchmark: le volume quantique qui prend en compte non seulement le nombre de qubits mais aussi la connectivité entre eux, le ” bruit ” et le taux d’erreur afin d’évaluer la complexité des problèmes que la machine peut résoudre. IonQ raffine le concept avec la métrique du qubit algorithmique, qui est le nombre maximal de qubits parfaits nécessaires pour faire tourner un programme quantique, en clair, le nombre de qubits utiles. C’est pour lui la variable à maximiser. Honeywell prétend que ses qubits sont plus efficaces que ceux d’IBM ou de Google, s’interconnectent plus facilement et ont des portes plus stables. Il en est de même de IonQ qui déclare qu’il peut fabriquer un bit logique presque parfait avec 13 qubits seulement alors qu’il en faut 1 000 pour Google et jusqu’à 1 000 000 pour certains ordinateurs quantiques. C’est pourquoi IonQ (adopté par AWS et Azure) estime que son ordinateur quantique sera opérationnel d’ici 2025 pour une variété de cas d’usage:

Comme IonQ ne nécessite pas d’environnement supraconducteur, ses processeurs quantiques peuvent être intégrés dans une simple puce de la taille d’une pièce de monnaie et montés sur des ordinateurs de la taille de serveurs cloud. Le problème est que les ions piégés sont plus difficiles à mouvoir que les qubits supraconducteurs, les erreurs, même moins nombreuses, plus lentes à contrôler et corriger, même si la connectivité est meilleure. Le problème devient très complexe quand on augmente le nombre de qubits. Il est encore trop tôt pour savoir quelle technologie va l’emporter, c’est pourquoi Amazon Braket et Azure Quantum utilisent les deux, la concurrence est stimulante. Le plus intéressant est qu’on parle maintenant de cas d’utilisation d’ici 5 ans, ce qui devient très proche, la pente étant quasi verticale au delà ! Le cloud devrait accélérer la formation de l’écosystème comme l’affirme Éric Chapman, CEO de IonQ:

Lorsque j'ai rejoint IonQ pour la première fois, il y a moins de deux ans, les gens disaient que les ordinateurs quantiques ne fonctionneraient jamais. Nous voici 18 mois plus tard et ils sont maintenant disponibles sur le cloud et tout le monde peut les utiliser. Je pense que leur mise en ligne a vraiment changé la donne pour beaucoup de sceptiques, et maintenant nous arrivons à un point où les gens commencent à réaliser qu'ils sont vraiment là. Cela fonctionne vraiment.

Le BCG donne une feuille de route intéressante pour l’adoption de l’ordinateur quantique. On peut constater l’aspect déterminant du taux d’erreur dans le développement de cette industrie:

L’application tueuse

Les applications de l’informatique quantique seront limitées, le code étant très contraignant; dans un premier temps les ordinateurs complèteront les super calculateurs pour des taches spécifiques. Il en est des ordinateurs quantiques comme de la voiture électrique: dans la première phase d’adoption, on fabriquait des hybrides, d’abord à essence comme la Prius en 1997, puis plug in et enfin pur électrique comme la Tesla. Il a fallu 20 ans pour une adoption significative. Donc dans une première phase on aura des ordinateurs hybrides, plus performants que les ordinateurs classiques. Google en voit tout l’intérêt pour l’apprentissage machine, le coeur de sa culture:

La mission de notre entreprise est d'organiser l'information mondiale et de la rendre universellement accessible et utile.

L’ordinateur quantique se prête bien aux calculs d’intelligence artificielle en raison de sa possibilité de calculer en parallèle au lieu de séquentiel. Un ordinateur quantique est un GPU géant…

Les applications, de l’avis des principaux protagonistes seront d’abord l’optimisation, l’intelligence artificielle, l’apprentissage machine, la science des matériaux, enfin la cryptographie. C’est là à mon avis l’application tueuse, celle qui va le plus motiver les chercheurs: notre monde est plus fragmenté, national et cherche à se protéger. La Chine et les Etats-Unis sont déjà en guerre technologique. La première des deux puissances qui maîtrisera la cryptographie quantique sera toute puissante car elle pourra:

démasquer n’importe quel clé de cryptage traditionnel (hackers)

créer un espace crypté inviolable même par un ordinateur quantique (se protéger des hackers par la cryptographie post quantique)

Le gouvernement américain s’est donné un objectif 2024 pour commencer la transition de ses données cryptées en post quantique. La course contre la montre a commencé. Le cloud peut faire émerger n’importe quel acteur, la compétition est intense. D’autant plus qu’à la clé, il y a les crypto-monnaies, et notamment le Bitcoin avec une capitalisation boursière de $600 milliards. Les prévisions de taille du marché potentiel à court/moyen terme du BCG sont enfoncées si on intègre les crypto-monnaies. Le bitcoin pourrait être la première victime du cryptage quantique, rendant les clés privées plus difficiles à protéger. Une nouvelle race de crypto-monnaies quantiques pourraient voir le jour et déplacer le bitcoin, à moins que celui-ci réussisse à s’adapter et changer son mode de cryptage. Y aurait-il alors une course à la puissance quantique lancée par les mineurs avec les blocks quantiques ?

L’internet quantique

De nombreuses expériences sont réalisées aujourd’hui pour téléporter des qubits. Les qubits ne voyagent pas en fait mais s’apparient par le phénomène de l’intrication à des km de distance. Ce n’est pas une mince affaire car la création de photons intriqués a un taux d’échec important. Mais pourquoi téléporter des qubits sur longue distance si c’est si difficile ? Il y a deux intérêts majeurs:

transmettre des clés de cryptage sans possibilité d’être intercepté. C’est très intéressant dans le cas des applications de cryptage symétrique où il faut s’échanger la clé avec un risque d’interception. le hacker laisse forcément des traces quand il intercepte un qubit. Un internet complètement sécurisé pourrait ainsi voir le jour, le cryptage symétrique étant plus aisé à mettre en oeuvre à grande échelle que l’asymétrique.

regrouper un réseau d’ordinateurs quantiques épars pour en faire un super ordinateur quantique nettement plus puissant, se partageant les qubits grâce à leur propriété d’intrication; l’internet quantique pourrait être un moyen d’accélérer l’avènement des applications quantiques. C’est pourquoi il est important de surveiller les expériences actuelles.

La Chine est en avance dans ce domaine, ayant lancé en orbite son premier satellite quantique en 2016, dénommé Micius. Depuis, la Chine enregistre des records de distance pour le transport de clés de cryptage, le dernier en date étant 1400 km (sol/sol) . Elle expérimente aussi la création de photons intriqués par fibre optique et a construit un premier réseau internet quantique hybride (fibre optique +satellite) longue distance (2 000 km pour la fibre, 2 600 km pour le satellite). La Chine a réussi à transporter une clé de cryptage sur une distance cumulée de 4 300 km. Depuis des sociétés chinoises utilisent le réseau, notamment deux banques pour le transport sécurisé de certaines de leurs données. Les Etats-Unis de leur côté se différencient sur la précision du signal, l’absence de perte en ligne qui est un élément important pour une exploitation commerciale future. D’après Medium, le 12 janvier 2021:

Nous pourrions maintenant faire un pas de plus vers un Internet quantique pratique, grâce à une équipe internationale de chercheurs du Fermilab, d'AT&T, de Caltech, de l'université de Harvard, du Jet Propulsion Laboratory de la NASA et de l'université de Calgary, qui ont réussi à téléporter des qubits sur deux systèmes. Ils ont réussi à obtenir un enchevêtrement quantique soutenu sur 44 kilomètres de câble à fibre optique avec une précision de 90% - créant ainsi un nouveau record.

Les chinois ne sont qu’à un degré de 80 % de précision. Pour transporter une clé de cryptage, mieux vaut éviter qu’elle se perde pendant le “voyage”…

La gestion du grand écart

La convergence de l’ordinateur et du réseau internet quantiques pourrait accélérer les applications dans deux domaines potentiellement contradictoires: l’intelligence artificielle et la confidentialité des données. Ce sont déjà deux domaines en conflit latent, qui attirent de plus en plus l’attention du pouvoir politique, deux domaines que les sociétés internet d’aujourd’hui apprennent à concilier, notamment les plus importantes et cela leur donne un avantage par rapport au reste du troupeau. Par exemple, Facebook cherche à garder sa suprématie sur la collecte et l’exploitation de données personnelles (une usine à données), tout en mettant en avant la possibilité de converser sur ses applications comme WhatsApp en crypté ou sur Instagram en mode éphémère. La gestion du grand écart devient une spécialité des GAFA. Ils se préparent ainsi naturellement à l’avènement du quantique. C’est pourquoi je ne vois pas une révolution du quantique mais un renforcement de l’écosystème actuel, notamment celui des opérateurs cloud qui pourront investir à la fois dans les ordinateurs et dans le réseau quantiques, fabriquer des offres hybrides pour renforcer leur avantage, apporter plus de pertinence et de sécurité à leurs utilisateurs. Les tentatives louables de la France avec son plan quantique de € 1,8 milliard, dont € 800 millions réservés à l’ordinateur quantique et €325 millions à l’internet quantique ne créeront pas l’écosystème nécessaire. Le cloud français manque d’échelle (OVH doit avoir peut-être $1 milliard de chiffre d’affaires en 2020, ce qui est une belle réussite mais souffre de la comparaison aux $45 milliards d’AWS)…et ne semble pas s’intéresser au quantique. L’écosystème ne se forme pas, on en reste au stade de savant Cosinus.

En résumé, c’est toujours plus de centralisation vers les même opérateurs cloud: évolution, oui, révolution, non ! Les crypto-monnaies ont encore de beaux jours devant elles !

Bonne fin de semaine,

Hervé