Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Le krach technologique actuel ne doit pas être assimilé au précédent de 1999/2000. Il y avait alors une pléthore d’infrastructures par rapport à des applications inexistantes et qui ont mis des années à se matérialiser. La dette n’a pu être payée, faute de cash-flows. La situation est aujourd’hui inverse: les infrastructures sont trop maigres par rapport aux applications gigantesques qui pointent à l’horizon ( Back to the Future 2, part 1 et Back to the Future 2, part 2). Et il y a des cash-flows pour financer ces investissements dans les sociétés technologiques établies. Ce qui change est la nature du cash: dans les années 2010, il provenait largement des sociétés de capital risque qui cherchaient à construire des plates-formes et donnaient le tempo à toutes les sociétés technologiques. Il y’avait une course à la plate-forme. Faute de munitions aujourd’hui, la plate-forme est reléguée en arrière plan et le tarissement des ressources des sociétés de capital risque impose une autre démarche fondée sur le temps et la matière.

Cela entraine des conséquences qu’on va voir sur la demande de semi-conducteurs et la structuration de l’écosystème technologique.

De plates-formes à produits

On a vite oublié que le succès tant d’Apple que de Google, Amazon, Facebook ou même Netflix, est d’avoir conçu de bons produits d’abord avant d’avoir constitué des plates-formes. Les investisseurs ne retiennent que la plate-forme parce que l’investissement est léger, l’effet d’échelle et l’effet réseau potentiellement infinis…Amazon s’est fait apprécier en bourse par sa place de marché puis par AWS. Ces deux plateformes doivent leur succès cependant au produit de base: le commerce en ligne de livres puis de toute sorte de biens (The Everything Store, selon Brad Stone). A partir des années 2010 particulièrement, le concept de plate-forme est devenu à la mode auprès des sociétés de capital développement. Elles ont eu l’idée de financer des unicorns 🦄, des plates-formes privées principalement, qui gagnaient leur effet réseau à coup de subventions et faisaient miroiter une domination inévitable du fait de la rapidité de leur conquête. D’après Wikipedia:

En affaires, une licorne est une entreprise privée en démarrage évaluée à plus d'un milliard de dollars américains. Le terme a été publié pour la première fois en 2013, inventé par la spécialiste du capital-risque Aileen Lee, choisissant l'animal mythique pour représenter la rareté statistique de telles entreprises à succès.

CB Insights a identifié 1 191 licornes an activité au 30 septembre 2022. Parmi les anciennes et iconiques, on peut citer Alibaba, non cotée jusqu’en 2014 qui représente l’archétype de la plate-forme: mise en relation de marchands et d’acheteurs par le logiciel, prix cassés pour le service de mise en relation afin de créer l’effet réseau, utilisation de logistique extérieure pour l’acheminement, faibles immobilisations. Puis remontée des tarifs, une fois l’effet réseau obtenu. Le modèle a plu, malgré ses faiblesses et les plates-formes se sont multipliées cherchant la domination éclair. Le nirvâna est devenu la mise en relation à propos d’un sujet x, y ou z à définir avec la société de capital développement . Le produit n’était qu’un prétexte, souvent bâclé, faute de temps, pour arriver à cet objectif le plus vite possible ! Voici par exemple un tableau des licornes sur le e-commerce:

Et ce n’est qu’un petit échantillon parmi les licornes: plateformes toujours et encore…Une forme particulière de plate-forme est l’API (Application Programming Interface), une pièce de logiciel qui effectue une fonction précise et peut se déployer sur n’importe quel programme. Plus cette fonction est utilisée, plus elle devient un standard et alors une plate-forme, sur laquelle les sociétés viennent se brancher pour atteindre leurs clients. Stripe en est un bon exemple dans les paiements, Twilio dans les communications.

Le krach technologique remet les pendules à l’heure. On revient des plateformes, de gré ou de force; on réalise que la différenciation se fait avec le produit (hardware ou software). Amazon a perfectionné son offre d’e-commerce pendant 4 années avant de lancer sa place de marché, le premier iPhone n’avait pas d’App Store, Google n’a lancé sa plate-forme publicitaire Adwords qu’en 2000, 4 ans après sa création ! Le moteur de recherche est avant tout un produit comme chaque réseau social de Facebook. Les investisseurs ont fini par oublier qu’il n’y a pas de plate-forme à succès sans l’effet « whaoo » du produit ! La conception d’un bon produit requiert:

du temps: une interaction avec le consommateur est nécessaire, qui permet de définir ce qu’il veut vraiment et ainsi de perfectionner le dit produit. L’expérimentation fatalement engendre des échecs qu’il faut corriger. Ce processus est le fruit d’une fertilisation croisée entre concurrents, qui prend beaucoup de temps jusqu’à l’apparition du produit « idéal ». Apple n’a sorti son premier IPhone qu’après que Nokia, Samsung, BlackBerry, etc. aient fait progresser le concept de smartphone. Entre le premier smartphone inventé par IBM et l’IPhone il y a 18 ans. Instagram a beaucoup appris de Snapchat puis maintenant de TikTok. A l’inverse, l’objectif de la plate-forme est l’effet réseau, qui nécessite d’être avant les autres. Il lui faut subventionner les parties pour aller plus vite, réduire le prix du produit sous-jacent pour les demandeurs, l’augmenter pour les offreurs pour provoquer plus de volume. L’approche est antinomique avec celle du produit, elle n’est pas intrinsèquement porteuse de qualité.

des investissements: fabriquer un bon produit nécessite de faire bouger de la matière, que ce soit pour produire ou acheminer ledit produit. Apple est avant tout une société de logistique, coordonnant à la quasi-perfection les différentes étapes du processus de production, d’assemblage, d’emballage et de livraison de ses iPhones, Macs ou autres. Ces étapes engendrent des frais variables. Le moteur de recherche de Google est si efficace et perçu comme tel car il repose sur une logistique de serveurs et de puces qu’il faut coordonner là aussi à la perfection. Une fois la logistique en place, il y a un réel avantage concurrentiel reproductible sur des produits adjacents: la logistique est durable. La plate-forme, étant essentiellement mise en relation, évite ces investissements lourds et variables mais au coût d’un avantage concurrentiel fugace. L’effet réseau est vite détrôné quand le produit sous-jacent n’est pas à la hauteur.

Dans ce dernier cas de figure, le fameux effet réseau de la plate-forme ne se transforme jamais en espèce sonnante et trébuchante, car toute tentative de remontée des prix sera vite contrée par une nouvelle plate-forme plus originale qui finira par détruire l’effet réseau de la première par des prix cassés.

Le mode de financement disponible contraint le modèle économique. Sans financement massif au départ, le perfectionnement du produit est la seule voie possible, car il s’inscrit dans le temps long et la matière est consommée progressivement au rythme des ventes et des cash-flows. Une plate-forme au contraire est le réceptacle idéal pour des investissements en capital risque avec un avenir idéalisé en PowerPoint (financement de WeWork par SoftBank Vision Fund par exemple). Or quelle est l’ambiance aujourd’hui (20/11/2022) ?

Oubliez les plates-formes, il faut maintenant penser produits, temps, matière, logistique et frais variables. « Hardware is eating the world »…again.

IA: le cas Midjourney

Paradoxalement, Midjourney fabrique du software, mais c’est un produit quand même ! David Holz est le fondateur de Midjourney, un programme d’intelligence artificielle qui transforme du texte (appelé prompt) en images. Ce programme préfigure le futur tel qu’envisagé en part 1. David Holz veut prendre son temps pour peaufiner son produit sans penser à constituer une plate-forme. Il prend la leçon de sa précédente start up Leap Motion: il avait alors inventé une souris qui au lieu de se balader sur un bureau pour faire bouger la flèche, traque le mouvement des mains par un système de caméra, lesquelles mains sont censées donner les instructions sur l’écran.

Mais, plutôt que de se pencher sur le besoin (inexistant à l’époque), il avait essayé de fédérer des développeurs, créant une plate-forme de 600 apps sans intérêt. Le résultat fut un four. Pour bien comprendre son client, l’essence du produit, comme l’explique David Holz, il lance Midjourney sur Discord, un réseau social en vogue. Cela lui permet d’observer ce que les utilisateurs attendent de Midjourney: comment ils progressent dans leur art de créer des images grâce à la discussion et au partage des scripts, comment ils arrivent à maximiser leur créativité. Puis il fait évoluer son produit en créant de nouvelles versions, aujourd’hui la V4. Il lui faut arbitrer entre la qualité de l’image et le temps qu’il faut pour la produire. L’observation du comportement des utilisateurs est clé pour définir le bon mix. Il n’est pas aujourd’hui question de créer une plate-forme mais une logistique, comme pour tout bon produit, fut-il un service. La fourniture d’une image mobilise une quantité importante de GPUs dans le cloud. Si on multiplie par le nombre d’utilisateurs on arrive à des chiffres qui vont bientôt dépasser les capacités des opérateurs cloud. Midjourney apprend à gérer la pénurie comme une société de logistique, en faisant travailler des serveurs la nuit à l’autre bout du monde pour répondre aux besoins présents le jour. Il faut organiser une rotation des GPUs à travers le monde, arbitrant les capacités disponibles les moins cher entre opérateurs cloud. Tout comme Apple ou Ferrari, Midjourney est toujours à court d’une image par rapport à la demande. Comme Tesla, il n’a pas besoin de faire de la publicité pour vendre, au contraire il se limite. David Holz:

presque chaque dollar dépensé par quelqu'un pour notre service sert à payer un GPU, ce qui est assez bizarre. Tout cela va calculer plus de flops par dollar que n'importe quel autre service, certainement. Et puis, oui, ce qui s'est passé, c'est qu'il n'y avait pas vraiment de demande de calcul de la part des consommateurs, et maintenant nous montrons qu'il y en a une, et les clouds ne sont pas fondamentalement construits en supposant qu'il y a une grande demande de calcul de la part des consommateurs.

En fait, le cloud devra se réadapter à cette nouvelle réalité. Et c'est un réajustement assez important. Pour moi, si je devais deviner, si nous voulons qu'un milliard de personnes dans le monde utilisent de grands modèles d'IA, que ce soit pour la génération d'images d'IA ou pour du texte ou pour quoi que ce soit, ce ne sont que de grands modèles, peu importe à quoi ils sont utilisés. Si nous voulons qu'un milliard de personnes y aient accès, le cloud doit probablement être mille fois plus important qu'aujourd'hui en termes de calcul. Et donc une différence de mille fois, c'est comme si ce n'était pas physiquement possible à court terme. C'est pourquoi, au cours des prochaines années, je pense que ces marchés seront surtout limités sur le plan informatique, et c'est l'une des raisons pour lesquelles nous sommes relativement discrets sur le plan marketing, et nous sommes relativement discrets sur le plan de la nécessité de ne pas avoir un produit pour tout le monde.

Silicium au centre (redimensionnement du cloud)

Le cloud a été conçu à l’ère des plates-formes et dimensionné en fonction. Les clouds opéraient principalement au CPU traditionnel, Intel régnait en maitre. Les besoins en puissance de calcul étaient limités: il fallait fournir des APIs pour parfaire les plate-formes (API de communication, API d’analyse de données, API de paiement), selon la logique du lego. J’ai abordé ce point dans un article de 2020: conteneurs, lego et web3.0:

L’informatique vit une transition, tout comme le transport maritime et inter modal pendant les vingt premières années de l’introduction du conteneur. Il n’était probablement pas facile à l’époque de prévoir ce qui allait sortir de la modularisation du transport. Cette expérience peut nous aider maintenant à comprendre les bouleversements à attendre de la modularisation de l’information pour l’organisation des entreprises: d’un côté trois pourvoyeurs de cloud (maximum), de l’autre une myriade d’applications hyper-spécialisées, entre deux des packagers tentant leur chance.

Certes, certaines sociétés technologiques fabriquaient des produits (les sociétés les plus valorisées aujourd’hui comme Apple, Alphabet ou Amazon) et avaient constitué leur propre logistique. Mais la plupart des autres vivaient à leur remorque en cherchant le modèle magique (peu de frais, donc peu de hardware, beaucoup de rentabilité, donc beaucoup de logiciel…). Le mantra lancé par Mark Andreessen en 2011 était: « Software is eating the world ». Tout comme Midjourney, les autres promoteurs d’IA générative vont devoir s’adapter pour trouver leur bon positionnement, dans un combat darwinien qui va mobiliser des ressources en GPUs considérables. Les systèmes type Midjourney consomment des GPUs à 10% pour l’entraînement et à 90% pour l’inférence. Nous sommes aujourd’hui au point zéro de l’évolution, il y a un boulevard de progrès devant nous. D’après Raphaël Richard, CEO de 24pm Academy, grand connaisseur de l’IA:

De mon humble point de vue, ces outils ressemblent aux moteurs de recherche des années 90: ils permettaient de trouver énormément d'informations, mais pas forcément celle dont tu avais besoin. Donc, l'enjeu était, en reconnaissant leurs limites, surtout de comprendre dans quel cas ils étaient utiles. Ces outils d'IA générative en sont un peu là, il faut pour chaque outil déterminer là où il est bon. Dall-e est un bon outil pour générer des images de tout type: photos, scènes, digital art, etc... mais n'excelle dans aucun domaine. Midjourney excelle dans le digital art. GPT-3 est un bon outil généraliste de génération de textes mais qui a du mal à rédiger de longs textes techniques. Galactica est un générateur de texte spécialisé dans l'info scientifique.

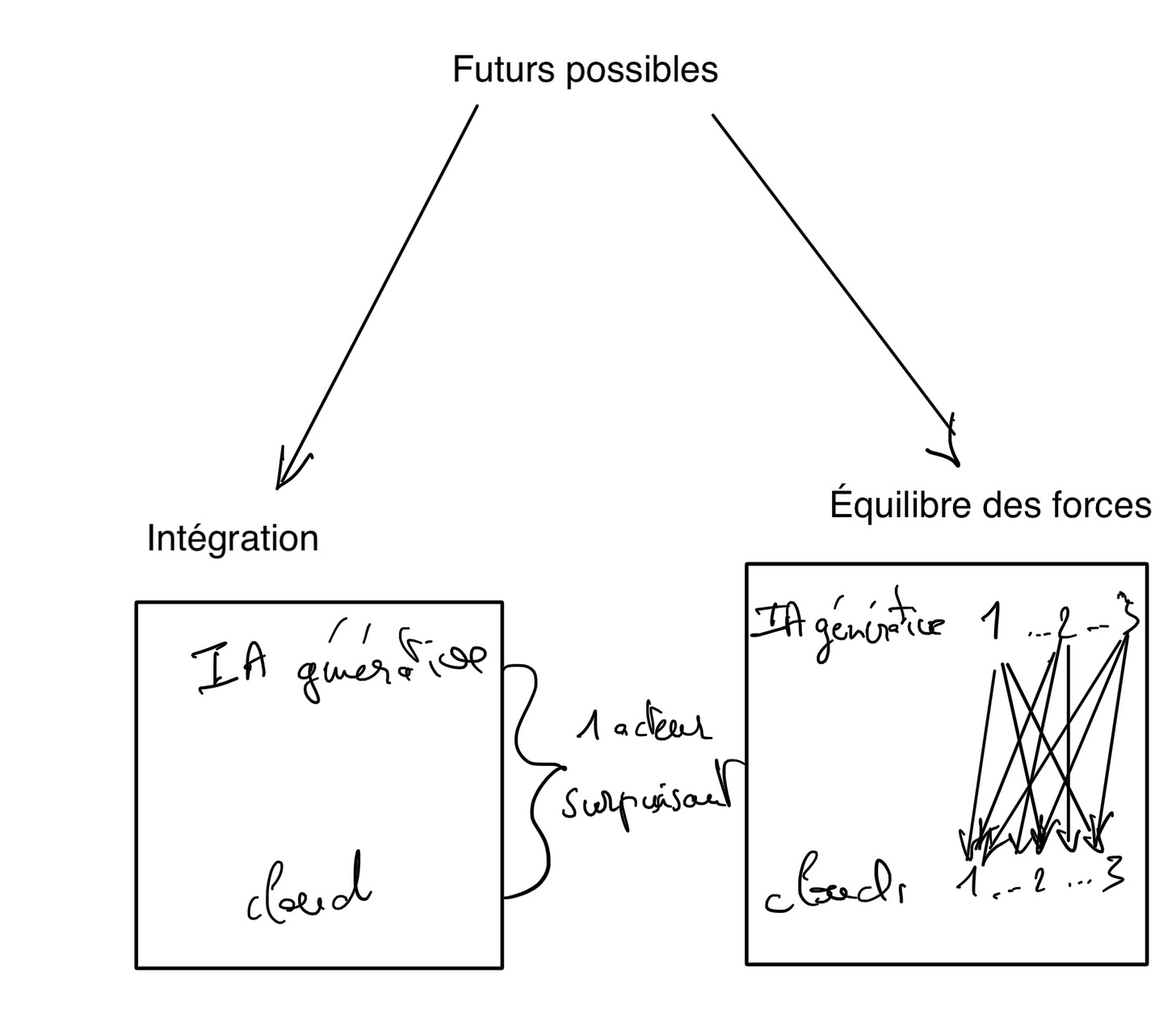

Google a conçu le bon produit, apprenant les leçons des défauts des moteurs de recherche antérieurs et il a 95% de parts de marché, tout comme l’IPhone a tiré les leçons de l’échec de BlackBerry. Il en sera probablement de même de l’IA générative, au prix d’un investissement massif dans les parcs de serveurs pour supporter une charge de calcul sans commune mesure avec ce que les clouds peuvent offrir aujourd’hui. Les promoteurs des meilleurs produits seront plébiscités et se différencieront par leur logistique (comme Apple aujourd’hui), les produits moyens seront marginalisés. A terme, deux modèles pourraient émerger: un producteur d’IA generative surpuissant intégré à un parc de serveurs massifs; ou alors un équilibre des forces entre producteurs d’IA générative, chacun spécialisé dans sa niche et des opérateurs clouds dotés de moyens en GPUs extraordinaires; ou les deux…

Ce qui est prévisible est la débauche de silicium pour arriver à cet objectif et d’imagination pour perpétuer la loi de Moore. Il est probable que les opérateurs clouds ne voudront pas laisser leurs marges à Nvidia et concevront leurs propres puces d’intelligence artificielle (ASICS), tout comme Google le fait déjà avec ses TPUs. On a observé le même phénomène avec le Bitcoin, les mineurs abandonnant progressivement les GPUs (multi-usages) pour des ASICS spécialisés. Les bénéficiaires seront à l’évidence les fonderies. Cette forte demande en silicium va se télescoper avec celle provenant du perfectionnement du hardware de réalité virtuelle, car là aussi, il faut pouvoir trouver le bon produit avant de penser à une éventuelle plate-forme…et le bon produit consommera beaucoup de silicium.

Silicium à la périphérie (du 2D au 3D)

L’approche centralisée est aujourd’hui et dans un futur prévisible (cinq/dix ans) peu probable pour les applications de réalité virtuelle/mixte. J’y vois deux raisons:

Transposer en local une expérience de réalité virtuelle immersive depuis le cloud est très demandeur en GPUs. Il n’y a pratiquement pas d’économie de puissance de calcul à réaliser les calculs dans le cloud plutôt que localement. En cela la distribution de la puissance de calcul des GPUs est différente de celle de l’électricité.

De toute façon le réseau ne permet pas de faire arriver le rendu 3D en local suffisamment rapidement compte tenu de sa faible qualité.

De fait, il est beaucoup plus simple de positionner la puissance de calcul en local sur les appareils eux-même: ce n’est pas plus consommateur en GPUs globalement et l’expérience de réalité virtuelle peut être délivrée immédiatement (sans latence), augmentant ainsi la perception de réalité. C’est pourquoi de fait, il faudra penser produit plutôt que plate-forme, l’expérience étant plus locale que centralisée.

C’est aussi pourquoi la demande de puces va exploser sur le hardware local comme elle le fera sur le cloud, grâce notamment à l’IA générative. Les deux futurs imaginés en part 1 et part 2 sont complémentaires du point de vue de la répartition de la charge de calcul. Autant les calculs VR se feront en local, autant on ne peut à mon sens imaginer décentraliser les GPUs d’inférence concernant l’IA générative. En effet, cela impliquerait également de décentraliser le logiciel, c’est à dire d’adopter un modèle de licence à l’ancienne, fort peu compatible avec l’itération nécessaire pour améliorer le produit.

Le combat pour la VR est nettement moins ouvert que celui pour l’IA générative. Meta a fait place nette et est largement dominant sur les casques (70% à 80% de part de marché), largement devant le chinois ByteDance avec son casque Pico (10% de part de marché). Les deux ont contracté avec Qualcomm pour la conception des puces, lesquelles sont fabriquées par TSMC. Comme Pico est chinois, le risque est grand que l’accès aux technologies américaines soient un jour interdites, ne laissant en place que le trio Meta-Qualcomm-TSMC. Cette consolidation est précoce dans le cycle du produit et empêchera la réelle innovation. C’est bien ce qu’escompte Meta qui sait qu’il ne pourra plus, compte tenu de son historique, employer la stratégie classique d’acheter la start-up innovante pour la mettre à l’échelle (type Instagram ou WhatsApp). Il ne lui reste plus qu’à tuer dans l’œuf toute velléité de concurrence…tout en prônant l’open source pour la canaliser. Finalement, on se retrouve dans le schéma du smartphone avec cette fois d’un côté Apple et de l’autre Meta/Qualcomm, les deux types de puces sous licence Arm fabriquées par TSMC. La concurrence y apparait encore plus verrouillée et risque d’être un jeu de pouvoir entre ces quatre acteurs, avec quelques trublions type Sony ou Intel.

C’est la différence entre ces deux futurs. L’un, le casque VR semble télescopé par les suspects habituels. On peut imaginer les différentes versions du casque comme celles de l’IPhone: plus puissant, plus léger, plus de batterie, un meilleur graphisme, un sentiment de présence amélioré a chaque version. Du déjà vu appliqué à la troisième dimension. L’autre futur (l’IA générative) va déchaîner la créativité à tous les niveaux: l’utilisateur va apprendre l’assemblage de prompts; la société d’IA va apprendre à créer la bonne interface dans les domaines les plus variés, spécialisés et généralistes; la logistique va être un élément déterminant du succès d’un produit et pourra prendre des formes variées avec des puces très différentes adaptées à l’expérience client. Le deuxième futur semble plus passionnant que le premier…

Bonne semaine,

Hervé